Автор: Денис Аветисян

В статье предлагается новая система независимой оценки ИИ, направленная на повышение доверия и соответствия систем искусственного интеллекта заявленным требованиям.

Разработана комплексная структура сторонней оценки ИИ, включающая анализ как процессов разработки, так и конечных результатов, для заполнения пробелов в существующих практиках управления и аудита ИИ.

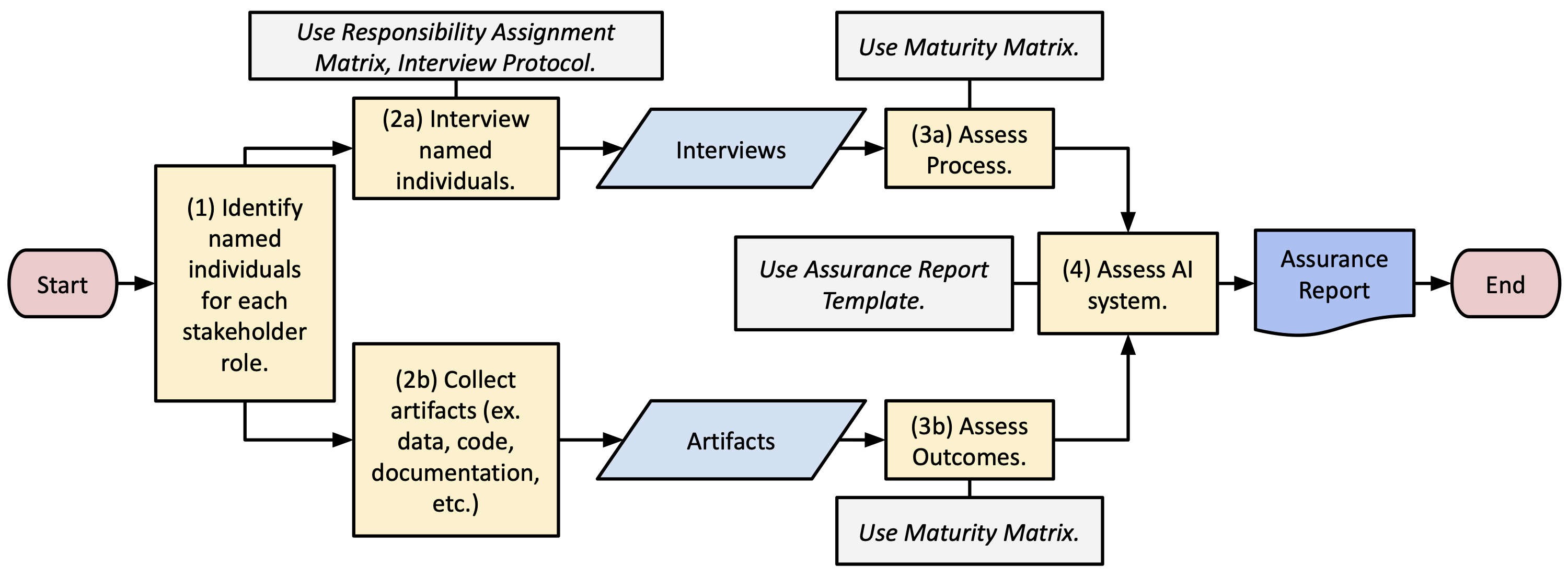

Несмотря на растущую распространенность систем искусственного интеллекта, надежные и прозрачные механизмы их оценки остаются недостаточным звеном в обеспечении их ответственного внедрения. В настоящей статье, ‘Toward Third-Party Assurance of AI Systems: Design Requirements, Prototype, and Early Testing’, предложен новый фреймворк для независимой оценки ИИ, сочетающий в себе оценку как процесса разработки, так и конечных результатов. Разработанный подход включает в себя матрицу ответственности, протоколы интервью и матрицу зрелости для комплексной оценки соответствия ИИ-систем лучшим практикам. Позволит ли предложенный фреймворк повысить доверие к ИИ и обеспечить его соответствие этическим и регуляторным требованиям?

Необходимость Надёжной Оценки Систем Искусственного Интеллекта

По мере того, как системы искусственного интеллекта всё глубже проникают в критически важную инфраструктуру — от энергосистем и транспортных сетей до систем здравоохранения и финансовых институтов — последствия их сбоев перестают быть просто неприятностями и превращаются в потенциальные опасности. Ранее незначительные ошибки в алгоритмах теперь могут приводить к масштабным сбоям в работе жизненно важных служб, представляя угрозу безопасности и благополучию граждан. Например, некорректная работа ИИ в системе управления электросетями может спровоцировать отключение электроэнергии в целых регионах, а сбой в алгоритме управления транспортным потоком — привести к серьезным авариям. Поэтому, обеспечение надежности и безопасности ИИ становится не просто технической задачей, а вопросом национальной безопасности и общественной стабильности.

Современные методы оценки искусственного интеллекта (ИИ) зачастую концентрируются на узких показателях производительности, таких как точность распознавания или скорость обработки данных, игнорируя при этом более широкие системные риски и этические аспекты. Такой подход может привести к тому, что ИИ-системы, демонстрирующие высокие результаты в отдельных тестах, окажутся уязвимыми в реальных условиях эксплуатации, особенно в критически важных инфраструктурах. Недооцениваются потенциальные последствия, связанные с предвзятостью алгоритмов, нарушением конфиденциальности данных и непреднамеренными последствиями для общества. В результате, несмотря на техническую эффективность, такие системы могут не соответствовать требованиям безопасности, надежности и социальной ответственности, что препятствует их широкому и доверительному внедрению.

Для формирования доверия к искусственному интеллекту и раскрытия его полного потенциала необходим всесторонний подход к обеспечению его надёжности на протяжении всего жизненного цикла. Этот подход предполагает не просто тестирование производительности на конкретных задачах, но и постоянный мониторинг, оценку рисков и этических последствий на всех этапах — от разработки и обучения модели до её внедрения и эксплуатации. Обеспечение надёжности должно быть непрерывным процессом, включающим в себя регулярные проверки на соответствие меняющимся требованиям и стандартам, а также механизмы для оперативного выявления и устранения возникающих уязвимостей. Только такой комплексный подход позволит гарантировать, что системы искусственного интеллекта будут работать безопасно, предсказуемо и в соответствии с ожиданиями пользователей и общества.

Несмотря на растущее число разработанных принципов и рекомендаций по управлению искусственным интеллектом, их практическая реализация часто сталкивается с серьезными трудностями. Существующие нормативные рамки, хотя и декларируют необходимость этичности, прозрачности и ответственности, зачастую не предоставляют конкретных инструментов и методик для их воплощения в реальных системах ИИ. Это проявляется в отсутствии четких критериев оценки соответствия, недостатке стандартизированных процедур аудита и верификации, а также ограниченном доступе к специализированным ресурсам для разработчиков и регуляторов. В результате, принципы остаются на уровне деклараций, не обеспечивая достаточного контроля над потенциальными рисками и не способствуя формированию доверия к технологиям искусственного интеллекта.

Комплексная Рамка Обеспечения Качества Искусственного Интеллекта: Подход На Всё Жизненное Цикл

Рамка обеспечения качества ИИ (AI Assurance Framework) представляет собой комплексную методологию оценки ИИ-систем, охватывающую все этапы жизненного цикла — от определения требований и сбора данных, через разработку и обучение моделей, до развертывания, мониторинга и вывода из эксплуатации. Оценка проводится на каждом этапе с целью выявления и смягчения потенциальных рисков и обеспечения соответствия системы установленным критериям качества, безопасности и этичности. Данный подход позволяет не просто проверить работоспособность ИИ-системы, но и оценить процессы, которые привели к её созданию, обеспечивая прослеживаемость и возможность улучшения на протяжении всего жизненного цикла.

В основе Рамки обеспечения качества ИИ лежит проактивный подход к управлению рисками, заключающийся в их выявлении и смягчении на этапах разработки и внедрения, до фактического развертывания системы. Это позволяет предотвратить потенциальные сбои и негативные последствия, вместо того чтобы реагировать на уже возникшие проблемы. Такой подход предполагает проведение регулярных оценок рисков, анализ потенциальных уязвимостей и разработку стратегий их устранения, что существенно снижает вероятность возникновения ошибок и повышает надежность и безопасность ИИ-систем.

Рамка обеспечения качества ИИ включает в себя оценку как процессов разработки и внедрения, так и конечных результатов работы системы. Оценка процессов позволяет удостовериться в соблюдении установленных стандартов, прозрачности и воспроизводимости работы ИИ, а также в адекватности применяемых методов и инструментов. Оценка результатов фокусируется на фактической производительности системы, ее точности, надежности и соответствии заданным требованиям. Комбинирование этих двух подходов позволяет получить комплексное представление о качестве ИИ, охватывающее не только что система достигает, но и как она этого достигает, обеспечивая более надежную и ответственную разработку и внедрение.

Успешное внедрение Рамки обеспечения качества ИИ напрямую зависит от четкого определения ролей и вовлечения заинтересованных сторон на каждом этапе жизненного цикла системы. Это подразумевает назначение ответственных лиц за конкретные задачи, такие как разработка, тестирование, развертывание и мониторинг, а также обеспечение эффективной коммуникации между командами и пользователями. Вовлечение заинтересованных сторон, включая разработчиков, специалистов по этике, юристов, представителей бизнеса и конечных пользователей, позволяет учитывать различные перспективы и потребности, что способствует более полному выявлению и смягчению потенциальных рисков, а также повышает доверие к системе и ее результатам. Отсутствие четких ролей и недостаточное вовлечение заинтересованных сторон может привести к неэффективности процессов, задержкам в реализации и, как следствие, к снижению качества и надежности системы ИИ.

Валидация Рамки: Методы Реализации и Оценки

Первичная валидация фреймворка осуществлялась посредством пилотных внедрений и интервью с экспертами в области искусственного интеллекта. Пилотные приложения позволили оценить практическую применимость фреймворка в реальных сценариях и выявить потенциальные трудности при его использовании. Интервью с экспертами, в свою очередь, предоставили ценную обратную связь относительно логической структуры, понятности и полноты фреймворка. Результаты этих мероприятий позволили подтвердить начальную удобство использования фреймворка и определить конкретные области, требующие доработки и улучшения для повышения его эффективности и адаптивности.

Оценка качества данных является критически важным компонентом при разработке и внедрении систем искусственного интеллекта. Она включает в себя проверку данных на полноту, точность, согласованность, своевременность и валидность. Некачественные данные могут привести к смещенным результатам обучения моделей, снижению их производительности и, как следствие, к ошибочным решениям. Методы оценки качества данных включают в себя статистический анализ, профилирование данных, проверку на выбросы и аномалии, а также ручную проверку экспертами. Регулярная оценка и очистка данных являются необходимыми условиями для обеспечения надежности и достоверности систем ИИ.

Оценка производительности модели, хотя и является важным этапом, представляет собой лишь один аспект комплексной оценки. Для получения полной картины необходимо сочетать ее с системным анализом, включающим оценку качества данных, выявление смещений и анализ влияния модели на всю систему, а не только на отдельные показатели. Такой подход позволяет выявить потенциальные проблемы, которые не проявляются при простой оценке точности, и обеспечить надежность и справедливость работы искусственного интеллекта в реальных условиях.

Оценка эффективности фреймворка осуществляется посредством анализа его способности выявлять проблемные области и стимулировать улучшения в системах искусственного интеллекта. Этот процесс включает в себя количественную оценку снижения количества ошибок, повышения точности прогнозов и оптимизации производительности систем после применения фреймворка. Оценка проводится на основе данных, полученных из пилотных проектов и реальных сценариев использования, с акцентом на измеримые показатели, такие как время решения проблем, стоимость оптимизации и влияние на ключевые бизнес-показатели. Кроме того, проводится анализ обратной связи от пользователей и экспертов для определения областей, требующих дальнейшей доработки и улучшения фреймворка.

Обеспечение Практической Ценности: Отчёт об Обеспечении Качества и Оценка Зрелости

Отчет об обеспечении качества представляет собой структурированное резюме результатов оценки, детально освещающее как сильные стороны, так и недостатки функционирующей системы искусственного интеллекта. Этот документ не просто констатирует факты, но и предоставляет четкую картину текущего состояния ИИ, выявляя области, где система демонстрирует высокую эффективность, и те, где необходима доработка или оптимизация. Особое внимание уделяется выявлению потенциальных рисков и уязвимостей, что позволяет организациям принимать обоснованные решения для повышения надежности и безопасности ИИ-систем. В конечном итоге, отчет служит ценным инструментом для непрерывного улучшения и адаптации ИИ к меняющимся требованиям и задачам, обеспечивая соответствие высоким стандартам качества и производительности.

Матрица зрелости представляет собой структурированный инструмент, позволяющий организациям проводить объективную оценку AI-процессов и результатов их применения. Она позволяет не только выявить текущий уровень развития AI-систем, но и определить конкретные шаги для улучшения и оптимизации. Оценка проводится по заранее определенным критериям, охватывающим различные аспекты, от качества данных и моделей до процессов внедрения и мониторинга. Благодаря возможности повторных оценок, матрица зрелости становится эффективным инструментом для отслеживания динамики развития AI-компетенций организации во времени, позволяя выявлять прогресс, узкие места и области, требующие дополнительного внимания и инвестиций. Это, в свою очередь, способствует более эффективному управлению рисками и повышению отдачи от внедрения искусственного интеллекта.

Матрица ответственности (Responsibility Assignment Matrix) является ключевым инструментом для успешной реализации рекомендаций и поддержания надежности систем искусственного интеллекта. Она обеспечивает четкое распределение задач и полномочий между различными участниками процесса, определяя, кто отвечает за конкретные аспекты внедрения и дальнейшего контроля. Благодаря этому подходу исключается размытость ответственности, повышается эффективность работы команды и гарантируется своевременное выполнение поставленных задач. Использование матрицы ответственности способствует созданию прозрачной системы, в которой каждый участник осознает свою роль и вклад в обеспечение качества и надежности AI-систем, что, в свою очередь, повышает доверие к результатам их работы и снижает риски, связанные с некорректным функционированием.

Независимая оценка со стороны третьей стороны играет ключевую роль в подтверждении эффективности внедрённой системы обеспечения качества искусственного интеллекта. Такой аудит позволяет объективно проверить соответствие разработанного фреймворка заявленным принципам и требованиям, а также оценить достоверность полученных результатов. Внешняя экспертиза существенно повышает доверие к системе ИИ, демонстрируя заинтересованным сторонам, что оценка была проведена беспристрастно и независимо. Прозрачность, обеспечиваемая независимой оценкой, способствует укреплению репутации организации и позволяет ей уверенно представлять свои решения в области искусственного интеллекта клиентам, партнерам и регулирующим органам.

«`html

Предложенная в работе схема независимой оценки систем искусственного интеллекта подчеркивает необходимость комплексного подхода, охватывающего не только процесс разработки, но и конечный результат. Это созвучно принципам проектирования, где элегантность достигается за счет ясности и простоты. Клод Шеннон как-то заметил: «Теория коммуникации измеряет, что, по сути, является передачей информации». Подобно тому, как Шеннон исследовал каналы связи, данное исследование стремится создать надежный «канал» для оценки и подтверждения соответствия систем ИИ заявленным целям и этическим нормам. Очевидно, что сложная система оценки, вероятно, сама по себе хрупка, если не учитывать взаимосвязь всех ее компонентов, и предложенный подход стремится к созданию целостной, а не фрагментированной модели.

Куда же дальше?

Предложенная система оценки ИИ, несмотря на свою логичную структуру, лишь обнажает глубину нерешенных вопросов. Попытка формализовать доверие к алгоритмам — это всегда упрощение, а упрощение — неизбежная потеря информации. Устойчивость системы не в количестве метрик, а в ясности границ, в понимании того, что оценка — это не поиск абсолютной истины, а скорее, картирование ландшафта рисков.

Будущие исследования должны сместить фокус с отдельных инструментов аудита на целостную архитектуру доверия. Важно понимать, как различные оценки взаимодействуют друг с другом, как они влияют на процесс разработки и внедрения ИИ, и, что самое главное, как они адаптируются к постоянно меняющемуся контексту. Необходимо исследовать, как принципы «ответственного ИИ» могут быть встроены не только в код, но и в саму культуру разработки.

В конечном счете, задача состоит не в создании «безопасного» ИИ, а в создании систем, которые способны к адаптации, к самокоррекции, и которые, в случае ошибки, не приводят к катастрофическим последствиям. Сложность не в алгоритмах, а в понимании того, что любая система — это лишь приближение к идеалу, и что постоянный мониторинг и рефлексия — залог ее долгосрочной устойчивости.

Оригинал статьи: https://arxiv.org/pdf/2601.22424.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Искусственный исследователь: Новые горизонты автономных агентов

- Искусственный интеллект: расшифровка паттернов инноваций

- Квантовые игры: поиск равновесия на нейтральных атомах

- Время видеть: как агенты раскрывают многомерное мышление в языковых моделях.

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Сердце музыки: открытые модели для создания композиций

- Нейросети на грани: как перевести ИИ в логику для умных устройств

- Эффективная память для больших языковых моделей: новый подход LOOKAT

2026-02-02 21:29