Автор: Денис Аветисян

В статье представлен инновационный метод верификации длинных цепочек рассуждений, использующий активное обучение и обучение с подкреплением для повышения точности и эффективности.

Представлен OPV — верификатор, ориентированный на результат, для эффективной проверки длинных цепочек рассуждений, использующий активное обучение и обучение с подкреплением.

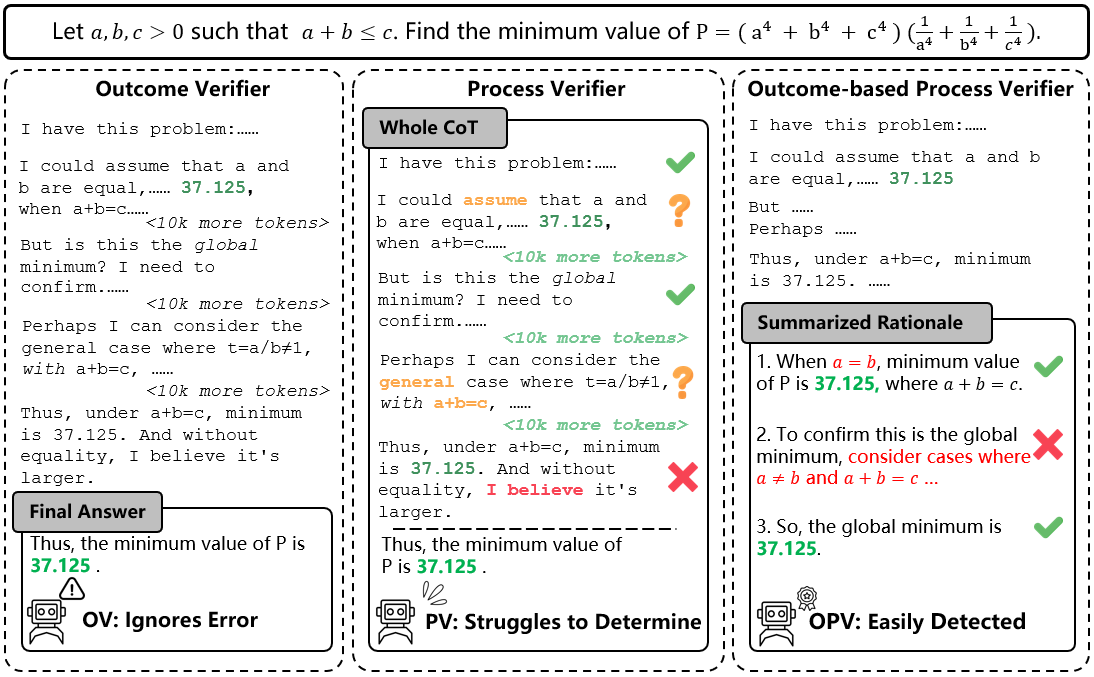

Несмотря на значительный прогресс в обучении больших языковых моделей (LLM) решению сложных задач, верификация цепочек рассуждений остаётся сложной проблемой. В данной работе представлена система ‘OPV: Outcome-based Process Verifier for Efficient Long Chain-of-Thought Verification’, новый верификатор, сочетающий оценку итогового результата с анализом процесса рассуждений для повышения точности и эффективности проверки. Предложенный подход, использующий активное обучение и обучение с подкреплением, позволяет достичь передовых результатов и снизить затраты на аннотацию данных. Сможет ли OPV стать ключевым компонентом в создании надежных и масштабируемых систем искусственного интеллекта, способных к сложному рассуждению?

Разрушая Бастионы Неопределенности: Ограничения Логических Цепочек БЯМ

Несмотря на впечатляющие возможности, большие языковые модели (БЯМ) часто решают сложные задачи, опираясь на длинные и непрозрачные цепочки рассуждений. Этот процесс, хотя и позволяет достигать результатов, сопряжен с определенными трудностями. БЯМ не просто выдают ответ, а как бы “проговаривают” его, шаг за шагом, но эти шаги не всегда очевидны или легко прослеживаемы. По сути, модель генерирует последовательность промежуточных заключений, которые приводят к конечному решению, и именно эта последовательность может быть очень развернутой и сложной для анализа. Такая структура рассуждений, хотя и демонстрирует способность модели к логическому мышлению, создает проблему интерпретируемости и затрудняет понимание того, как именно был получен тот или иной ответ.

По мере увеличения глубины рассуждений, необходимых для решения сложных задач, значительно возрастают вычислительные затраты и вероятность ошибок в работе больших языковых моделей. Каждая дополнительная ступень логического вывода требует экспоненциального увеличения ресурсов, что делает процесс не только медленным, но и подверженным накоплению неточностей. Даже небольшая ошибка на ранней стадии рассуждений может привести к полностью неверному конечному результату, особенно при решении многоступенчатых задач. Это ограничивает применимость языковых моделей в критически важных областях, где требуется высокая надежность и точность, и подчеркивает необходимость разработки более эффективных алгоритмов и методов контроля за процессом логического вывода.

Оценка корректности разветвленных цепочек рассуждений, генерируемых большими языковыми моделями, представляет собой существенное препятствие для их практического применения. По мере увеличения глубины и сложности этих цепочек, вероятность накопления ошибок возрастает экспоненциально, что ставит под сомнение надежность получаемых результатов. Необходимость в надежных и масштабируемых методах верификации становится критически важной, поскольку ручная проверка каждого шага рассуждений становится невозможной даже для задач умеренной сложности. Разработка автоматизированных систем, способных выявлять логические ошибки и противоречия в длинных цепочках умозаключений, является ключевым направлением исследований, определяющим будущее доверия к системам искусственного интеллекта.

Автоматизированная Оценка Рассуждений: Роль Верификаторов

Верификаторы предоставляют автоматизированный способ оценки корректности и надежности шагов рассуждений, генерируемых большими языковыми моделями (LLM). В отличие от ручной проверки, верификаторы используют алгоритмы и логические правила для анализа последовательности действий, предпринятых LLM при решении задачи. Это позволяет объективно определять, являются ли эти шаги логически обоснованными и приводят ли они к правильному результату. Автоматизация процесса оценки снижает затраты времени и ресурсов, а также обеспечивает возможность проведения масштабных тестов для выявления систематических ошибок в логике LLM. Верификаторы могут оценивать как отдельные шаги, так и всю цепочку рассуждений, предоставляя детализированную обратную связь для улучшения производительности модели.

Инструменты верификации играют ключевую роль в выявлении ошибок и предоставлении обратной связи при оценке качества рассуждений, генерируемых большими языковыми моделями (LLM). Наша Outcome-based Process Verifier (OPV) демонстрирует производительность, сопоставимую с гораздо более крупными моделями с открытым исходным кодом, на различных бенчмарках. Это подтверждается результатами тестирования, где OPV обеспечивает сравнимую точность и надежность оценки, при этом требуя значительно меньше вычислительных ресурсов. Такой подход позволяет автоматизировать процесс контроля качества рассуждений и оперативно выявлять проблемные области в работе LLM.

Инструменты верификации, предоставляя объективную оценку качества рассуждений, позволяют перейти от эмпирической настройки больших языковых моделей (LLM) к целенаправленной оптимизации. Например, применение Outcome-based Process Verifier (OPV) позволило повысить точность модели DeepSeek-R1-Distill-Qwen-32B с 55.2% до 73.3% на бенчмарке AIME2025, демонстрируя возможность конкретных улучшений, основанных на данных о качестве рассуждений, а не на случайных изменениях параметров модели.

Эффективный Отбор Данных: Активное Обучение и Экспертная Аннотация

Активное обучение представляет собой итеративный процесс выбора наиболее информативных данных для экспертной аннотации. В отличие от случайного отбора, активное обучение позволяет целенаправленно отбирать примеры, которые максимизируют прирост знаний модели при минимальных затратах человеческих ресурсов. Этот подход предполагает, что не все данные одинаково ценны для обучения; алгоритмы активного обучения анализируют текущее состояние модели и идентифицируют примеры, в которых модель наиболее неуверена или склонна к ошибкам. Последовательный отбор таких примеров для аннотации позволяет значительно повысить эффективность обучения и снизить потребность в больших объемах размеченных данных, особенно в условиях ограниченных ресурсов.

Для создания размеченного набора данных из 40 тысяч решений была применена стратегия приоритетной выборки примеров. Такой подход позволил минимизировать затраты на аннотацию за счет концентрации усилий экспертов на наиболее информативных данных. В результате, процесс обучения модели был значительно ускорен по сравнению со случайной выборкой, что позволило снизить общие временные и финансовые издержки на разработку.

Экспертная аннотация является ключевым этапом в процессе обучения больших языковых моделей (LLM), заключающимся в оценке решений, сгенерированных моделью, квалифицированными специалистами. Данный этап включает в себя выявление ошибок, неточностей и логических несоответствий в ответах LLM, а также предоставление корректной обратной связи для улучшения качества генерируемого контента. Эксперты проводят детальный анализ каждого решения, оценивая его соответствие заданным критериям и предоставляя конкретные рекомендации по исправлению ошибок, что позволяет повысить надежность и точность LLM.

Сжатие Рассуждений: Суммирование CoT и Уточнение Модели

Методики суммирования цепочек рассуждений (Chain of Thought, CoT), использующие модели вроде Deepseek-V3, позволяют эффективно сжимать развернутые последовательности логических шагов до лаконичных решений, при этом сохраняя наиболее важные этапы рассуждений. Этот подход не только повышает эффективность работы больших языковых моделей, снижая вычислительные затраты, но и значительно улучшает интерпретируемость процесса принятия решений. Вместо громоздких и труднопрослеживаемых цепочек, модель выдает компактное обоснование, что облегчает отладку и понимание логики, лежащей в основе ответа. По сути, CoT-суммирование позволяет выделить суть рассуждений, отбросив избыточные детали, что делает процесс более прозрачным и удобным для анализа.

Уплотнение цепочек рассуждений, осуществляемое передовыми моделями, значительно повышает эффективность и понятность работы больших языковых моделей. Этот процесс не только сокращает вычислительные затраты, но и делает логику принятия решений моделью более прозрачной для исследователей и разработчиков. Возможность компактно представить ключевые этапы рассуждений облегчает отладку и выявление потенциальных ошибок в логике модели, позволяя оперативно корректировать её поведение. Таким образом, повышение интерпретируемости становится важным фактором для построения надёжных и контролируемых систем искусственного интеллекта, способных объяснять свои выводы и решения.

Для дальнейшей оптимизации рассуждений больших языковых моделей применяются методы, такие как отточенный отбор (Rejection Fine-Tuning, RFT) и обучение с подкреплением на основе проверяемых вознаграждений (Reinforcement Learning with Verifiable Rewards, RLVR). Эти подходы используют специальные верификаторы для выявления и отсеивания примеров с некачественными цепочками рассуждений. Разработанный верификатор демонстрирует высокую точность, с уровнем ложноположительных срабатываний всего 7.0%, что сопоставимо с оценками экспертов-людей. Это позволяет обучать языковые модели не просто генерировать ответы, а стремиться к проверяемой корректности, значительно повышая надежность и обоснованность их рассуждений.

Исследование представляет собой попытку не просто проверить цепочку рассуждений, но и понять её суть, выделив ключевые моменты и закономерности. Это созвучно философии глубокого анализа систем, когда для понимания необходимо разобрать их на составляющие и изучить взаимодействие между ними. Как однажды заметил Роберт Тарьян: «Программирование — это не столько создание чего-то нового, сколько обнаружение того, что уже существует». OPV, подобно инструменту реверс-инжиниринга, стремится раскрыть логику, лежащую в основе сложных рассуждений больших языковых моделей, и, тем самым, обеспечить более эффективную и надёжную проверку, используя активное обучение и обучение с подкреплением для выявления наиболее важных аспектов процесса рассуждения.

Что дальше?

Представленная работа, по сути, лишь вскрыла один из чёрных ящиков — проблему верификации длинных цепочек рассуждений больших языковых моделей. OPV демонстрирует, что фокусировка на результате, а не на процессе, может быть эффективной, но это лишь первый шаг. Остаётся вопрос: насколько вообще возможно достоверно верифицировать сложный, нелинейный процесс мышления, даже если известен конечный результат? Вполне вероятно, что сама постановка задачи требует пересмотра.

Использование активного обучения и обучения с подкреплением — это, безусловно, шаг в правильном направлении, но они лишь смягчают проблему нехватки размеченных данных. Более глубокий вопрос заключается в том, как создать систему, способную самостоятельно генерировать критерии оценки рассуждений, не опираясь на человеческую аннотацию. Или, возможно, стоит принять, что идеальная верификация — это иллюзия, и сосредоточиться на выявлении наиболее критических ошибок.

В конечном итоге, эта работа, как и любая другая, порождает больше вопросов, чем ответов. И это хорошо. Потому что в хаосе неразрешенных проблем, в постоянном сомнении и переосмыслении, и рождаются настоящие открытия. Попытки взломать систему, даже если они не приводят к полному успеху, всегда ценнее, чем слепое следование правилам.

Оригинал статьи: https://arxiv.org/pdf/2512.10756.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Сердце музыки: открытые модели для создания композиций

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Эффективная память для больших языковых моделей: новый подход LOOKAT

- Эволюция под контролем: эксперименты с обучением с подкреплением в генетическом программировании

- Игры в коалиции: где стабильность распадается на части.

- Доказательство устойчивости веб-агента: проактивное свертывание контекста для задач с горизонтом в бесконечность.

- Доказательства просят: Как искусственный интеллект помогает отличать правду от вымысла

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Голос в переводе: как нейросети учатся понимать речь

2025-12-12 23:41