Автор: Денис Аветисян

Исследователи представили SpargeAttention2, метод разреженного внимания, позволяющий существенно повысить эффективность генерации видео без потери качества.

SpargeAttention2 сочетает гибридную маскировку Top-k/Top-p и дистилляцию скорости для достижения высокой степени разреженности и производительности в диффузионных моделях.

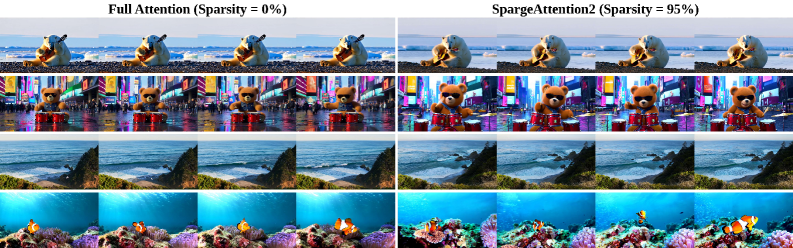

Разреженные механизмы внимания эффективно ускоряют диффузионные модели, однако их статичная природа ограничивает возможности дальнейшего повышения степени разреженности без ущерба для качества генерации. В настоящей работе, посвященной методу ‘SpargeAttention2: Trainable Sparse Attention via Hybrid Top-k+Top-p Masking and Distillation Fine-Tuning’, предлагается обучаемый подход к разреженному вниманию, сочетающий гибридную маскировку Top-k и Top-p с целью повышения устойчивости при высокой разреженности, а также функцию обучения, вдохновленную дистилляцией, для сохранения качества генерации. Эксперименты с диффузионными моделями для видео демонстрируют достижение 95% разреженности внимания и 16.2-кратного ускорения, при этом превосходя существующие методы. Сможет ли предложенный подход стать стандартом для эффективной генерации видео высокого качества?

Внимание: Квадратичная сложность как неизбежный техдолг

Механизм внимания, являющийся краеугольным камнем современной глубокой нейронной сети, демонстрирует квадратичную вычислительную сложность, что существенно ограничивает его масштабируемость при обработке длинных последовательностей данных. По сути, с каждым добавленным элементом в последовательность, объем необходимых вычислений растет пропорционально квадрату длины этой последовательности O(n^2). Это означает, что обработка даже умеренно длинных текстов, видео или других видов данных становится непомерно затратной с точки зрения вычислительных ресурсов и времени. В результате, модели, основанные на механизмах внимания, испытывают трудности при анализе больших объемов информации, что негативно сказывается на их способности к сложным рассуждениям и пониманию контекста в задачах, требующих анализа длинных последовательностей.

Ограничение вычислительных ресурсов, обусловленное квадратичной сложностью механизма внимания, существенно препятствует обработке больших объемов данных и выполнению сложных задач рассуждения. В частности, это оказывает негативное влияние на производительность моделей при работе с видеоматериалами и другими формами длинных последовательностей данных. Способность модели эффективно анализировать взаимосвязи в продолжительных видеопотоках или объемных текстовых документах снижается, что проявляется в ухудшении качества распознавания объектов, понимания контекста и генерации связных ответов. Таким образом, масштабируемость современных моделей искусственного интеллекта, использующих механизм внимания, напрямую зависит от преодоления этого ограничения для эффективной работы с данными, требующими анализа обширных последовательностей информации.

Современные методы обработки информации, основанные на механизмах внимания, сталкиваются с серьезными трудностями в достижении баланса между производительностью и вычислительной эффективностью. Несмотря на значительные успехи в области глубокого обучения, увеличение длины обрабатываемых последовательностей данных, например, в задачах анализа видео или обработки естественного языка, приводит к экспоненциальному росту вычислительных затрат. Это ограничивает возможности применения моделей в реальных условиях и стимулирует поиск оптимизированных механизмов внимания, способных эффективно обрабатывать большие объемы данных без существенной потери качества. Разработка таких механизмов является ключевой задачей, определяющей дальнейшее развитие искусственного интеллекта и его способность к решению сложных задач, требующих обработки длинных контекстов.

Основная сложность в масштабировании механизмов внимания заключается в поиске баланса между снижением вычислительной нагрузки и сохранением способности модели улавливать важные взаимосвязи в данных. Существующие подходы часто сталкиваются с дилеммой: упрощение вычислений приводит к потере критически важной информации, необходимой для точного анализа и принятия решений. Разработка эффективных алгоритмов внимания требует инновационных методов, позволяющих отфильтровывать несущественные связи и концентрироваться на наиболее значимых элементах последовательности, не жертвуя при этом общей способностью модели к обобщению и пониманию контекста. Успешное решение этой задачи откроет путь к созданию более мощных и масштабируемых систем искусственного интеллекта, способных эффективно обрабатывать большие объемы информации и решать сложные задачи в различных областях.

Разреженное внимание: Путь к эффективной обработке последовательностей

Разреженное внимание (Sparse Attention) предлагает решение для снижения вычислительной сложности обработки последовательностей. Традиционный механизм внимания требует вычисления взаимодействия между каждой парой элементов входной последовательности, что приводит к квадратичной зависимости вычислительных затрат от длины последовательности O(n^2). Разреженное внимание, напротив, фокусируется лишь на релевантных частях входной последовательности, выборочно обрабатывая взаимосвязи. Это позволяет снизить вычислительную сложность до линейной O(n) или близкой к линейной, что критически важно для обработки длинных последовательностей в задачах обработки естественного языка и компьютерного зрения.

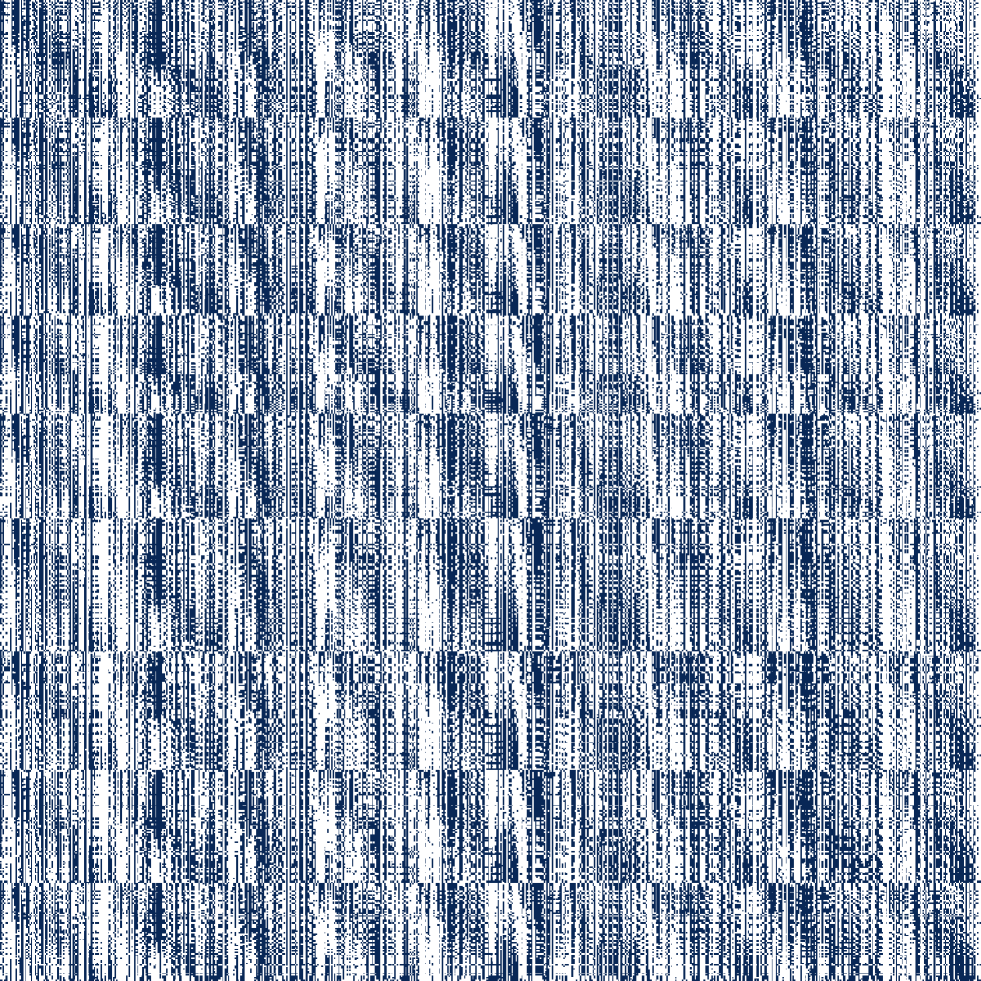

Для достижения разреженности в механизмах внимания применяются методы маскирования, такие как Top-k и Top-p. Top-k отбирает k наиболее значимых весов внимания, отбрасывая остальные. Top-p (также известный как nucleus sampling) выбирает минимальное подмножество весов, суммарная вероятность которых превышает заданный порог p. Оба подхода позволяют сократить вычислительные затраты, отсекая наименее значимые связи между элементами входной последовательности и сосредотачиваясь на наиболее релевантных.

Методы разреженного внимания, такие как Top-k и Top-p маскирование, демонстрируют эффективность в снижении вычислительной сложности, однако их производительность может существенно зависеть от распределения весов внимания. Неравномерное или смещенное распределение весов может привести к потере важной информации и снижению точности модели. Для поддержания оптимальной производительности в различных сценариях требуется тщательная настройка гиперпараметров, таких как значения k и p, а также, возможно, применение дополнительных стратегий регуляризации или адаптивных техник, учитывающих динамику распределения весов в процессе обучения. Некорректная настройка может привести к неоптимальному выбору наиболее значимых элементов последовательности и, как следствие, к ухудшению качества обработки данных.

Разработка надежного и адаптируемого механизма разреженного внимания является ключевой задачей для повышения эффективности обработки последовательностей. Существующие методы, такие как Top-k и Top-p маскирование, демонстрируют эффективность, однако их производительность может значительно варьироваться в зависимости от распределения весов внимания во входных данных. Поэтому, необходимы подходы, способные автоматически адаптироваться к различным распределениям, обеспечивая стабильную и высокую производительность при обработке разнородных данных. Это включает в себя разработку алгоритмов, устойчивых к изменениям в статистике входных данных и способных эффективно определять наиболее релевантные части последовательности для фокусировки внимания, не требуя при этом сложной ручной настройки.

SpargeAttention2: Обучение разреженному вниманию с дистилляцией скорости

SpargeAttention2 представляет собой новый обучаемый метод разреженного внимания, использующий гибридную стратегию маскирования Top-k и Top-p для повышения устойчивости. Top-k отбирает k наиболее значимых элементов, а Top-p отбирает минимальное количество элементов, сумма вероятностей которых превышает порог p. Комбинация этих подходов позволяет более эффективно идентифицировать и сохранять наиболее важные связи в данных, снижая влияние менее значимых элементов и повышая общую производительность модели при разреженном внимании. Данная стратегия обеспечивает более надежную работу модели в различных условиях и при различных входных данных, в отличие от использования только одного из методов отбора.

SpargeAttention2 использует функцию потерь, основанную на дистилляции скорости (velocity distillation loss), для выравнивания динамики диффузии разреженного механизма внимания с динамикой полноразмерной модели-учителя. Данный подход позволяет разреженному вниманию имитировать поведение более точной, но вычислительно дорогой, полноразмерной модели. Суть метода заключается в минимизации расхождения между градиентами параметров разреженного и полноразмерного внимания в процессе обучения, что обеспечивает сохранение качества сгенерированных данных при значительном снижении вычислительных затрат. Использование функции потерь, основанной на скорости, позволяет более эффективно передать знания от учителя к ученику, чем традиционные методы дистилляции, основанные на выходных данных модели.

Метод SpargeAttention2 снижает ухудшение производительности, часто связанное с разреженностью внимания, за счет имитации поведения модели с полным вниманием. Это достигается путем использования потерь, основанных на «дистилляции скорости» (velocity distillation), которые заставляют динамику разреженного внимания соответствовать динамике полного внимания. Таким образом, SpargeAttention2 воспроизводит важные закономерности в распределении внимания, наблюдаемые в моделях с полным вниманием, что позволяет поддерживать высокую производительность даже при значительном снижении вычислительных затрат, связанных с разреженностью, достигающей 95%.

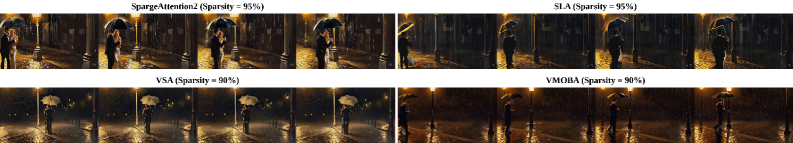

Экспериментальные результаты показывают, что SpargeAttention2 обеспечивает ускорение времени вычислений механизма внимания в 16.2 раза и ускорение сквозной генерации видео в 4.7 раза, сохраняя при этом сопоставимое качество с полным вниманием при 95% разреженности внимания. Данный подход превосходит существующие методы разреженного внимания, такие как VSA, VMoBA и SLA, по эффективности и скорости работы.

За пределами видео: Влияние на моделирование длинных последовательностей

Достижения в эффективности, реализованные с помощью SpargeAttention2, открывают новые горизонты в моделировании длинных последовательностей данных. Ранее неподдающиеся обработке объемы информации, такие как полноформатные видео, геномные последовательности и сложные аналитические документы, теперь становятся доступными для детального изучения. Этот прорыв позволяет значительно сократить вычислительные затраты и время обработки, что делает возможным анализ данных, который ранее был практически невозможен из-за ограничений ресурсов. Способность эффективно обрабатывать длинные последовательности является ключевым фактором для развития искусственного интеллекта в различных областях, где понимание контекста и долгосрочных зависимостей играет решающую роль.

Достижения в области эффективной обработки последовательностей открывают принципиально новые возможности для анализа данных в различных областях. В частности, становится возможным глубокое понимание длинных видеофрагментов, что позволяет извлекать сложные сюжетные линии и взаимосвязи между событиями. В геномике, это позволяет исследовать длинные участки ДНК, выявляя генетические маркеры и предсказывая предрасположенность к заболеваниям с большей точностью. Кроме того, анализ сложных документов, таких как юридические контракты или научные публикации, становится более эффективным, позволяя извлекать ключевую информацию и взаимосвязи между различными частями текста, что значительно ускоряет процесс обработки и принятия решений.

Комбинация гибридного маскирования и дистилляции скорости представляет собой универсальную основу для создания эффективных и точных механизмов разреженного внимания. Гибридное маскирование, объединяющее различные стратегии отбора наиболее релевантных частей входной последовательности, позволяет значительно снизить вычислительные затраты без существенной потери точности. В свою очередь, дистилляция скорости, путем передачи знаний от более сложной, но точной модели к более простой и быстрой, обеспечивает сохранение производительности даже при значительном сокращении числа параметров. Такой подход позволяет создавать разреженные механизмы внимания, которые эффективно обрабатывают длинные последовательности данных, сохраняя при этом высокую точность и скорость работы, что открывает новые возможности для анализа сложных данных в различных областях, от обработки естественного языка до компьютерного зрения и геномики.

Обеспечение устойчивости и обобщающей способности разреженных механизмов внимания требует пристального внимания к проблеме несоответствия распределений данных. Исследования показывают, что модели, обученные на одном наборе данных, могут демонстрировать значительное снижение производительности при применении к данным, отличающимся по своим характеристикам. Несоответствие может возникать из-за различий в статистических свойствах, шуме или смещениях, присутствующих в разных наборах данных. Для решения этой проблемы разрабатываются методы адаптации домена и переноса обучения, направленные на минимизацию расхождений между распределениями обучающих и целевых данных. Успешное преодоление этой проблемы позволит создавать более надежные и универсальные модели, способные эффективно обрабатывать разнообразные и непредсказуемые входные данные, что особенно важно для практического применения в реальных сценариях.

Будущие направления: К адаптивной и мультимодальной разреженности

Исследования направлены на разработку адаптивных стратегий разреженности, которые динамически регулируют уровень разреженности в зависимости от входной последовательности. Такой подход позволяет оптимизировать вычислительные затраты и повысить производительность моделей, поскольку ненужные вычисления избегаются путем фокусировки на наиболее значимых элементах входных данных. Вместо использования фиксированного уровня разреженности, система способна адаптироваться к сложности каждого конкретного фрагмента последовательности, повышая эффективность обработки и снижая потребление ресурсов. Подобные стратегии открывают возможности для создания более экономичных и масштабируемых моделей, способных эффективно работать с большими объемами данных и сложными задачами искусственного интеллекта.

Исследование возможности применения SpargeAttention2 к мультимодальным данным, таким как одновременная обработка видео- и аудиопотоков, открывает перспективные направления для дальнейших разработок. Предполагается, что одновременный анализ информации, поступающей из различных источников, позволит модели более эффективно улавливать сложные взаимосвязи и повысить точность распознавания. В частности, визуальные подсказки из видеоряда могут дополнять и уточнять информацию, извлеченную из аудио, и наоборот, создавая более полное и надежное представление о происходящем. Это особенно важно для приложений, связанных с пониманием естественного языка, распознаванием речи и анализом поведения, где контекст играет ключевую роль. Разработка алгоритмов, способных эффективно объединять и обрабатывать разнородные данные, станет важным шагом на пути к созданию более интеллектуальных и адаптивных систем искусственного интеллекта.

Исследование блочной разреженности внимания представляется перспективным направлением для дальнейшей оптимизации вычислений на графических процессорах. В отличие от традиционных подходов, где разреженность применяется к отдельным элементам матрицы внимания, блочная разреженность оперирует блоками, что позволяет более эффективно использовать преимущества параллельной архитектуры GPU. Такой подход снижает накладные расходы, связанные с индексацией и доступом к разреженным данным, а также улучшает локальность данных, что приводит к значительному ускорению вычислений, особенно при обработке больших последовательностей.

В конечном итоге, стремление к созданию единой, масштабируемой архитектуры внимания является ключевой задачей для развития современных систем искусственного интеллекта. Необходимость обработки всё более сложных и объемных данных требует не просто повышения эффективности существующих моделей, но и принципиально нового подхода к организации внимания. Разработка унифицированного фреймворка позволит не только снизить вычислительные затраты и повысить скорость обработки информации, но и обеспечит гибкость и адаптивность к различным типам данных и задачам, открывая возможности для создания более мощных и интеллектуальных систем, способных эффективно функционировать в динамично меняющейся среде. Такой подход позволит преодолеть ограничения текущих моделей и удовлетворить растущие потребности в обработке информации в самых разнообразных областях, от обработки естественного языка до компьютерного зрения и робототехники.

Статья описывает SpargeAttention2 — очередную попытку оптимизировать внимание в диффузионных моделях для генерации видео. Идея, конечно, интересная — добиться эффективности без потери качества. Но, как показывает практика продакшена, любое усложнение рано или поздно превращается в головную боль. Эндрю Ын однажды сказал: «Не беспокойтесь о недостатке данных, беспокойтесь о недостатке стратегии». В данном случае, стратегия понятна — разредить матрицу внимания. Вопрос в том, сколько ресурсов потребуется для поддержания этой разреженности и не станет ли оптимизация новым источником багов. Всё новое — это старое, только с другим именем и теми же багами, особенно когда дело касается видео — там всегда найдётся способ сломать даже самую элегантную архитектуру.

Куда это всё ведёт?

Предложенный метод SpargeAttention2, несомненно, добавляет ещё один слой оптимизации в бесконечную гонку за эффективностью генерации видео. Однако, как показывает опыт, каждая «революция» в области разреженного внимания — это лишь отсрочка неизбежного. Продакшен всегда найдёт способ выжать максимум из ресурсов, а значит, и из ограничений, которые создаёт разреженность. Рано или поздно, требования к качеству и детализации видео будут такими, что даже самые изощрённые маскировочные стратегии покажутся недостаточными.

Очевидным направлением для дальнейших исследований представляется не столько увеличение степени разреженности, сколько разработка более гибких и адаптивных механизмов внимания. Текущая парадигма, где внимание жёстко кодируется в архитектуру модели, выглядит всё более устаревшей. Скорее всего, будущее за системами, способными динамически перестраивать структуру внимания в зависимости от сложности сцены и требований к качеству. Иначе говоря, нам нужна не просто разреженность, а разумная разреженность.

Не стоит забывать и о том, что «дистилляция скорости» — это лишь один из способов заставить модель работать быстрее. В конечном итоге, ключевым фактором остаётся аппаратное обеспечение. Пока графические процессоры не научатся телепортировать данные, все эти оптимизации будут лишь косметическими. Впрочем, это не отменяет ценности исследования, ведь багтрекер — это, по сути, дневник боли, а каждый сэкономленный цикл — это шаг к уменьшению этого дневника.

Оригинал статьи: https://arxiv.org/pdf/2602.13515.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Квантовое программирование: Карта развивающегося мира

- Предел возможностей: где большие языковые модели теряют разум?

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Сердце музыки: открытые модели для создания композиций

- Виртуальная примерка без границ: EVTAR учится у образов

- Квантовый шум: за пределами стандартных моделей

- Квантовые кольца: новые горизонты спиновых токов

2026-02-21 05:07