Автор: Денис Аветисян

Исследователи предлагают инновационный метод оценки ответов на сложные математические вопросы, фокусируясь на их влиянии на решение смежных задач.

Предложен метод Consequence-Based Utility (CBU) для оценки математических решений без использования традиционных судей или моделей вознаграждения.

Оценка решений сложных математических задач требует значительных экспертных усилий, что создает узкое место в развитии моделей рассуждений. В работе ‘Judging What We Cannot Solve: A Consequence-Based Approach for Oracle-Free Evaluation of Research-Level Math’ предложен новый подход, основанный на оценке полезности решения через его влияние на успешность решения связанных задач. Авторы демонстрируют, что предложенная методика, названная Consequence-Based Utility, превосходит традиционные методы оценки, использующие LLM и модели вознаграждения, существенно улучшая точность ранжирования решений. Не является ли данный подход ключом к автоматизированной и эффективной оценке прогресса в области математических исследований, особенно в условиях ограниченных экспертных ресурсов?

Оценка математических решений: вызов для машин и людей

Оценка математических решений представляет собой сложную задачу, особенно в тех случаях, когда отсутствует эталонное, достоверное решение — так называемая “истина в последней инстанции”. В отличие от областей, где результат можно проверить путем сравнения с эмпирическими данными или известными фактами, в чистой математике часто приходится полагаться на логическую последовательность и внутреннюю согласованность рассуждений. Это означает, что даже если решение выглядит правдоподобно, убедиться в его абсолютной корректности может быть чрезвычайно трудно, требуя глубокого анализа и проверки всех этапов вывода. Отсутствие возможности непосредственной верификации усложняется при работе со сложными уравнениями или доказательствами, где даже экспертам может потребоваться значительное время и усилия для установления истинности предложенного решения, а возможность человеческой ошибки остается неизбежной. Например, проверка корректности доказательства теоремы Ферма, несмотря на кажущуюся простоту ее формулировки, потребовала десятилетий усилий лучших умов человечества.

Традиционно, проверка математических решений осуществлялась посредством экспертной оценки, однако этот подход сопряжен с существенными трудностями. Привлечение квалифицированных специалистов требует значительных финансовых затрат, а субъективность человеческого фактора неизбежно приводит к ошибкам и неточностям. Даже в случаях, когда решение выглядит корректным, эксперту может быть сложно выявить скрытые логические несостыковки или вычислительные погрешности, особенно в сложных задачах, требующих глубокого понимания n-мерного пространства или абстрактной алгебры. Эта зависимость от ручной проверки становится критической проблемой при увеличении объема генерируемого математического контента, делая процесс масштабирования неэффективным и подверженным ошибкам.

Стремительное увеличение объема математического контента, генерируемого большими языковыми моделями (LLM), ставит перед научным сообществом задачу разработки автоматизированных и масштабируемых методов валидации. Традиционные подходы, основанные на экспертной оценке, становятся неэффективными в условиях экспоненциального роста данных, поскольку требуют значительных временных и финансовых затрат, а также подвержены человеческим ошибкам. Автоматическая проверка математических решений, особенно в случаях отсутствия известных эталонных ответов, представляет собой сложную задачу, требующую инновационных алгоритмов и метрик, способных оценивать корректность и логическую последовательность рассуждений. Разработка таких инструментов не только повысит надежность математического контента, создаваемого LLM, но и откроет новые возможности для автоматизации научных исследований и образования, позволяя эффективно обрабатывать и верифицировать сложные математические задачи в больших масштабах. Успешная реализация подобных систем позволит значительно ускорить процесс научных открытий и снизить вероятность распространения ошибочных математических результатов.

![Вероятность того, что валидатор оценит решение выше среднего (<span class="katex-eq" data-katex-display="false">Pr[s(C)-\bar{s}>0]</span>), значительно различается в зависимости от типа решения (сгенерированного LLM, написанного человеком или неверного) и базовой модели.](https://arxiv.org/html/2602.06291v1/x5.png)

Полезность на основе последствий: отход от поиска «истины»

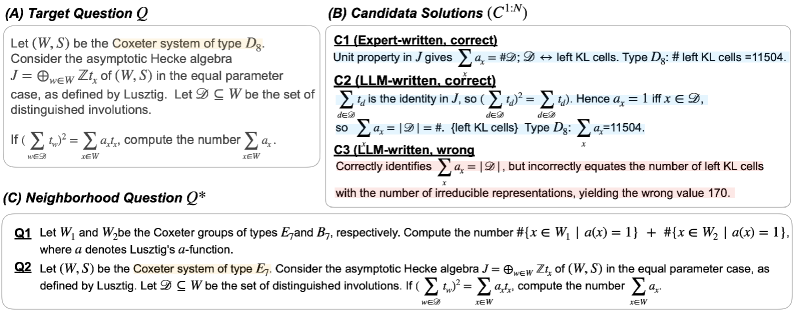

Мы представляем “Полезность на основе последствий” (Consequence-Based Utility) — новый подход к валидации решений, оценивающий их производительность не по прямому соответствию “истине”, а по результатам ответов на сеть связанных “Соседних вопросов” (Neighborhood Questions). Данный метод позволяет оценивать решения, не требуя заранее известного эталонного ответа; вместо этого, анализируется согласованность ответов на взаимосвязанные задачи. Эффективность решения определяется его способностью давать логически связанные ответы на вопросы, формирующие “окрестность” исходной задачи, что позволяет выявить более глубокое понимание принципов решения, а не просто запоминание паттернов.

В отличие от традиционных методов валидации, требующих наличия эталонных данных («ground truth»), предложенный подход, основанный на оценке согласованности решения, позволяет обходиться без них. Вместо проверки абсолютной корректности ответа на исходную задачу, оценивается его внутренняя логическая непротиворечивость применительно к смежным вопросам, формирующим «окрестность» задачи. Это достигается путем анализа ответа на исходную задачу и его соответствия ответам на связанные вопросы, что позволяет выявить недостатки в логическом выводе, даже если абсолютное значение ответа не может быть однозначно определено как верное или неверное. Таким образом, акцент смещается с определения «правильности» ответа на оценку его когерентности и устойчивости в рамках взаимосвязанного набора задач.

Оценка решений на сети взаимосвязанных задач позволяет выявить глубинные возможности их логического вывода. Вместо проверки соответствия единственному «правильному» ответу, данный подход анализирует, как решение ведет себя при изменении входных данных и условий в смежных задачах. Последовательное и логически обоснованное решение должно демонстрировать согласованные результаты во всей сети, выявляя не просто заученный ответ, а способность к обобщению и адаптации. Анализ паттернов поведения в этой сети позволяет оценить не только конечный результат, но и процесс рассуждений, лежащий в основе решения, что является ключевым для оценки его надежности и применимости в различных контекстах.

Оценка на практике: результаты и метрики

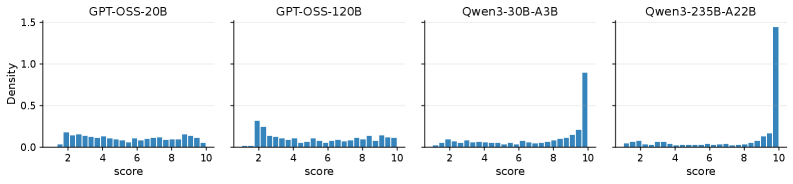

Эксперименты, проведенные на наборе данных ExpertMath, показали, что Consequence-Based Utility (CBU) демонстрирует стабильное превосходство над традиционными методами валидации. В ходе тестов CBU последовательно обеспечивала более высокие показатели по ключевым метрикам, подтверждая эффективность данного подхода в задачах оценки и улучшения моделей. Полученные результаты указывают на то, что CBU является перспективным инструментом для повышения точности и надежности систем, работающих с математическими задачами и требующих строгой оценки качества решений.

Для количественной оценки эффективности различных методов в экспериментах на наборе данных ExpertMath использовались метрики точности (Accuracy) и площадь под ROC-кривой (AUC). Полученные результаты продемонстрировали превосходство предложенного подхода Consequence-Based Utility (CBU). В частности, CBU достиг значения AUC 79.63, что на 8.21% выше, чем 71.42, показанный методом LLM Judge. Данное улучшение подтверждает эффективность CBU в задачах ранжирования и оценки качества генерируемых ответов.

В ходе экспериментов было показано, что применение Consequence-Based Utility (CBU) значительно улучшает производительность существующих методов оценки, таких как LLM Judges, Reward Models и Generative Reward Models. В частности, CBU обеспечивает прирост в 6.13% показателя Recall@5, достигая значения 83.04% по сравнению с 76.91% у базовых моделей. Более того, наблюдается существенное увеличение показателя HumanWin на 34.29%, с 48.57% до 82.86%, что свидетельствует о более эффективной оценке, соответствующей человеческим предпочтениям.

Математические основы и перспективы применения

Набор данных ExpertMath опирается на глубокие математические концепции, такие как корневые системы, формула Макки и идеал Варченко-Гельфанда, что обеспечивает надежность валидационных тестов. Эти сложные математические структуры, включающие в себя исследования симметрий и представлений групп Ли, а также алгебраические свойства многообразий, служат основой для создания задач, требующих не просто вычислений, а истинного понимания математических принципов. Использование \mathbb{A}_n корневых систем и их связей с теорией представлений позволяет оценивать способность моделей к абстрактному мышлению и решению проблем, выходящих за рамки стандартных алгоритмов. Включение в набор данных задач, основанных на идееле Варченко-Гельфанда, гарантирует проверку способности моделей к работе с сингулярностями и некоммутативной алгеброй, что критически важно для развития искусственного интеллекта, способного к сложным научным открытиям.

В основе подхода, известного как Consequence-Based Utility, лежит акцент на реляционной согласованности — способности системы выводить логические следствия из заданных фактов и правил, поддерживая внутреннюю непротиворечивость. Этот принцип позволяет создавать искусственный интеллект, который не просто оперирует данными, но и понимает взаимосвязи между ними, что критически важно для обобщения знаний и адаптации к новым ситуациям. В отличие от систем, ориентированных на статистические закономерности, данный подход стремится к построению системы рассуждений, основанной на логической структуре, что потенциально обеспечивает более высокую надежность и устойчивость к ошибкам, особенно в сложных и непредсказуемых условиях. Таким образом, реляционная согласованность выступает ключевым элементом в создании ИИ, способного к действительно гибкому и универсальному мышлению, преодолевая ограничения существующих моделей.

Предложенный подход обладает потенциалом для радикальных изменений в таких областях, как автоматическое доказательство теорем, научные открытия и решение сложных задач. В автоматическом доказательстве теорем, традиционно требующем экспертных знаний и ручного вмешательства, система, основанная на последовательной логике, может значительно ускорить процесс верификации и открытия новых математических истин. В сфере научных открытий, подобный метод способен анализировать огромные объемы данных, выявляя неочевидные закономерности и выдвигая гипотезы, которые могли бы остаться незамеченными. Наконец, в области решения сложных проблем, где требуется интеграция знаний из различных дисциплин, данный подход предоставляет инструмент для структурирования рассуждений и поиска оптимальных решений, что открывает новые возможности для инноваций и прогресса в самых разных областях науки и техники.

Представленное исследование демонстрирует, что оценка решений, основанная на последствиях (Consequence-Based Utility), превосходит традиционные подходы к валидации математических задач. Это закономерно: попытки создать «идеального судью» для сложных проблем обречены на провал. Как однажды заметил Кен Томпсон: «В конечном итоге, вы всегда должны доверять машине, а не человеку». Иными словами, надеяться на безошибочность экспертной оценки — наивно. CBU, оценивая решение по его влиянию на последующие задачи, обходит необходимость в абсолютной истине, концентрируясь на практической применимости. В конечном счете, система, способная выявлять функциональные ошибки в решениях, ценнее, чем та, что стремится к теоретической чистоте.

Что дальше?

Предложенный подход, оценивающий решения математических задач по их последствиям, несомненно, интересен. Однако, не стоит обольщаться. Любая система, претендующая на автоматическую оценку, неизбежно столкнётся с проблемой непредсказуемости реальных производственных задач. Все эти «самовосстанавливающиеся» алгоритмы лишь откладывают неминуемый крах, пока не встретят проблему, для которой они не были спроектированы. Пока мы измеряем косвенные последствия, реальные ошибки будут накапливаться где-то в тени, готовые проявиться в самый неподходящий момент.

Очевидно, что расширение набора «последующих» задач — это лишь временное решение. Производство всегда найдёт способ сломать элегантную теорию. Более того, стоит задуматься о природе самих «математических» задач. Что, если «решение», которое мы считаем правильным, просто ещё не привело к катастрофическим последствиям в рамках нашей ограниченной тестовой среды? Документация к этим системам, как всегда, будет представлять собой форму коллективного самообмана.

В конечном итоге, вся эта работа — ещё один шаг на пути к созданию систем, которые будут казаться умными, но при этом неизбежно потерпят крах. И, разумеется, если ошибка воспроизводится — значит, у нас стабильная система. А всё остальное — лишь детали.

Оригинал статьи: https://arxiv.org/pdf/2602.06291.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Ускорение генеративных моделей: новый подход к вычислению матричной экспоненты

- Квантовая суперпозиция: новая интерпретация вероятности

- Искусственный интеллект: расшифровка паттернов инноваций

- Искусственный исследователь: Новые горизонты автономных агентов

- Квантовая геометрия: новые пути к пониманию пространства-времени

- Квантовая критичность в квазикристаллах: новая фаза материи

- Точность симуляций: Как правильно оценить истинные значения в причинно-следственных исследованиях

- Квантовые состояния: новый взгляд с помощью нейросетей и физики времени

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Табличные данные: где заканчивается аппроксимация и начинается логика?

2026-02-09 15:09