Автор: Денис Аветисян

Исследователи разработали новый метод для автоматического создания масштабного набора данных семантических связей на турецком языке, преодолевая ограничения, связанные с нехваткой ресурсов для языков с небольшим количеством цифровых данных.

Представлен гибридный протокол, объединяющий кластеризацию, обогащение с помощью больших языковых моделей и верификацию по словарю для генерации 843 000 семантических пар.

Несмотря на значительный прогресс в области обработки естественного языка, создание масштабных семантических датасетов для языков с ограниченными ресурсами остается сложной задачей. В статье ‘A Hybrid Protocol for Large-Scale Semantic Dataset Generation in Low-Resource Languages: The Turkish Semantic Relations Corpus’ представлен гибридный протокол, позволяющий генерировать такие датасеты, на примере создания корпуса семантических связей для турецкого языка, включающего 843\,000 уникальных пар. Разработанный подход сочетает кластеризацию, обогащение данными с помощью больших языковых моделей и верификацию на основе авторитетных словарей, обеспечивая значительное увеличение объема доступных ресурсов при минимальных затратах. Может ли предложенная методика стать основой для создания семантических датасетов и для других языков, испытывающих дефицит лингвистических ресурсов?

Временные Издержки и Ресурсы: Постановка Проблемы Турецкого NLP

Турецкий язык, как и многие другие языки с ограниченными ресурсами, сталкивается со значительными трудностями при создании надежных систем обработки естественного языка. Ограниченное количество размеченных данных — то есть текстов, снабженных информацией об их значении и структуре — серьезно препятствует обучению алгоритмов машинного обучения, необходимых для выполнения таких задач, как машинный перевод, анализ тональности или извлечение информации. В отличие от широко распространенных языков, таких как английский или китайский, для турецкого языка доступно мало общедоступных баз данных, что вынуждает исследователей и разработчиков сталкиваться с проблемой недостатка обучающих данных и, как следствие, низкой производительностью создаваемых систем. Это особенно критично для сложных лингвистических особенностей турецкого языка, таких как агглютинация и гармония гласных, что требует еще большего объема данных для эффективного моделирования.

Создание семантических ресурсов для обработки естественного языка традиционно требует значительных временных и финансовых затрат. Ручная разметка данных, необходимая для обучения моделей, является трудоемким процессом, особенно для языков с богатой морфологией, таких как турецкий. Более того, масштабирование таких усилий для охвата всего спектра лингвистических явлений и предметных областей оказывается крайне сложным. По мере увеличения объема требуемых данных, стоимость и время, затрачиваемые на ручную разметку, растут экспоненциально, что делает традиционные подходы неэффективными и ограничивающими развитие современных приложений обработки естественного языка для турецкого языка.

Отсутствие масштабных и качественных семантических наборов данных серьезно препятствует развитию передовых приложений обработки естественного языка (NLP) для турецкого языка. В то время как современные NLP-модели, такие как большие языковые модели, демонстрируют впечатляющие результаты, их эффективность напрямую зависит от объема и качества обучающих данных. Для турецкого языка, являющегося языком с ограниченными ресурсами, эта зависимость становится критической проблемой. Недостаток размеченных данных ограничивает возможности обучения моделей для решения сложных задач, таких как анализ тональности, машинный перевод и ответы на вопросы. Это, в свою очередь, замедляет внедрение инновационных NLP-приложений в различные сферы, включая автоматизированную поддержку клиентов, анализ социальных сетей и интеллектуальный поиск информации на турецком языке. Преодоление этой проблемы требует разработки новых методов сбора, аннотации и синтеза семантических данных, адаптированных к специфике турецкого языка.

Недостаток размеченных данных для турецкого языка требует разработки инновационных методов автоматической генерации семантических ресурсов. Традиционные подходы к созданию таких ресурсов, как ручная аннотация и экспертная оценка, оказываются неэффективными из-за своей трудоемкости и высокой стоимости. Поэтому исследователи активно изучают возможности машинного обучения и нейронных сетей для автоматического извлечения и структурирования семантической информации из неразмеченных текстов. Особое внимание уделяется методам переноса знаний из языков с большим количеством ресурсов, что позволяет создавать семантические модели для турецкого языка, несмотря на ограниченность данных. Автоматизация процесса генерации семантических ресурсов не только снижает затраты, но и открывает возможности для создания более масштабных и актуальных баз знаний, способствующих развитию широкого спектра приложений обработки естественного языка для турецкого языка.

Гибридный Протокол: Архитектура Автоматической Генерации Семантических Данных

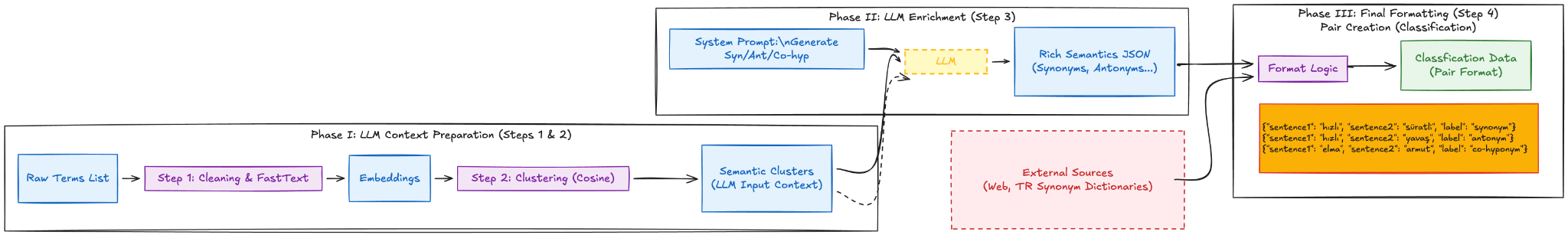

В основе нашего ‘Гибридного протокола’ лежит использование методов неконтролируемого обучения с применением ‘FastText Embeddings’ для представления терминов в виде плотных векторных представлений. В отличие от традиционных методов, использующих разреженные векторы, ‘FastText’ позволяет создавать компактные и эффективные векторы фиксированной размерности, отражающие семантические характеристики каждого термина. Данные векторы формируются на основе статистического анализа подстрок внутри слов, что позволяет эффективно обрабатывать редкие слова и учитывать морфологические особенности языка. Полученные векторные представления служат основой для последующих этапов протокола, обеспечивая количественную оценку семантической близости между терминами и позволяя проводить операции сравнения и кластеризации.

Агломеративная кластеризация, применяемая в протоколе, объединяет семантически близкие термины в контекстные кластеры. Этот процесс основан на иерархическом объединении, начиная с отдельных терминов и постепенно формируя более крупные группы на основе их близости в векторном пространстве, представленном моделями FastText. Формируемые кластеры служат основой для точной идентификации связей между понятиями, поскольку термины, входящие в один кластер, с высокой вероятностью связаны между собой. Размер и структура кластеров определяются выбранной метрикой расстояния и критерием остановки алгоритма, что позволяет оптимизировать процесс для конкретной предметной области и обеспечить высокую точность извлечения семантических отношений.

Кластеризация, выполненная на основе семантической близости терминов, формирует основу для целенаправленной экстракции семантических связей. Этот процесс позволяет выделить группы терминов, относящихся к определенным контекстам, что существенно сокращает объем данных, требующих анализа при поиске отношений между ними. Вместо рассмотрения всех возможных пар терминов, система фокусируется на тех, которые принадлежат к одним и тем же кластерам, повышая точность и эффективность извлечения семантических отношений и снижая вычислительную сложность задачи.

Первый этап протокола предназначен для подготовки данных к последующей автоматической аннотации и валидации. Он включает в себя предварительную обработку терминов, формирование семантических кластеров на основе векторных представлений, полученных с использованием алгоритма FastText, и агрегативную кластеризацию. Результатом данного этапа является структурированная база данных терминов, сгруппированных по семантической близости, что позволяет автоматизировать процесс выявления и подтверждения связей между ними, минимизируя потребность в ручной разметке и повышая общую эффективность системы генерации семантических данных.

Усиление Модели: Автоматическое Выявление Семантических Связей с Помощью LLM

Процесс “LLM-обогащения” использует модель Gemini 2.5-Flash для автоматического выявления и маркировки семантических связей между терминами внутри каждой кластеризованной группы. Модель анализирует контекст каждого термина и определяет типы отношений, таких как “является частью”, “вызывает”, “имеет свойство” и другие, присваивая каждой паре связанных терминов соответствующую метку. Это позволяет автоматически формировать пары семантически связанных терминов из исходных кластеров без ручной обработки, что значительно увеличивает скорость создания и масштабирования наборов данных для задач семантического анализа.

Процесс автоматического выявления семантических связей с использованием больших языковых моделей (LLM) позволяет генерировать значительное количество пар кандидатов в семантические отношения. Это существенно ускоряет создание датасетов, поскольку ручной процесс аннотации требует значительно больше времени и ресурсов. Генерируемые пары представляют собой предварительный набор данных, который затем может быть использован для обучения моделей или проверен экспертами для обеспечения качества, что в конечном итоге повышает эффективность разработки и развертывания систем, основанных на понимании семантических связей.

Использование больших языковых моделей (LLM) обеспечивает классификацию семантических связей на основе контекстного понимания, что принципиально отличается от простого сопоставления ключевых слов. Вместо определения отношений исключительно по совпадению терминов, LLM анализирует окружающий текст для определения фактического значения и типа связи между сущностями. Это позволяет выявлять более сложные и неявные отношения, такие как причинно-следственные связи, частичное включение или функциональные зависимости, которые были бы упущены при использовании традиционных методов, основанных на лексическом сопоставлении. Таким образом, LLM способны классифицировать семантические связи с большей точностью и детализацией, учитывая нюансы языка и контекста.

На данном этапе формируется предварительный, крупномасштабный семантический ресурс, требующий последующей доработки. Автоматическая индукция семантических связей с использованием больших языковых моделей (LLM) генерирует значительный объем кандидатов в семантические пары, однако, ввиду вероятности ошибок и неоднозначностей, полученные данные нуждаются в экспертной оценке и верификации. Процесс доработки включает в себя фильтрацию нерелевантных связей, коррекцию ошибочных классификаций и, при необходимости, ручное добавление недостающих семантических отношений для обеспечения высокого качества и точности результирующего семантического ресурса.

Верификация и Уточнение: Использование Турецкого Словаря Синонимов для Обеспечения Качества

Интеграция со «Словарём турецких синонимов» осуществляется для верификации семантических связей, сформированных языковой моделью (LLM). В процессе валидации, LLM-сгенерированные пары слов сопоставляются с записями в словаре для подтверждения их смысловой близости. В случае расхождений или отсутствия соответствия, семантическая связь подвергается корректировке или исключению из набора данных. Данный этап позволяет повысить точность и надежность данных, используемых для обучения и оценки моделей обработки естественного языка (NLP).

Процесс выявления и исправления ошибок и несоответствий является ключевым этапом повышения качества генерируемого набора данных. Автоматизированный анализ позволяет обнаруживать случаи, когда семантические связи между парами слов, предложенные языковой моделью, не соответствуют общепринятым значениям или содержат логические неточности. Обнаруженные ошибки корректируются путем сопоставления с данными из авторитетного источника — турецкого словаря синонимов — что обеспечивает согласованность и достоверность данных, используемых в последующих задачах обработки естественного языка.

Для повышения надежности и достоверности сгенерированных данных используется перекрестная проверка с авторитетным внешним ресурсом — турецким словарем синонимов. Этот процесс позволяет верифицировать связи между семантическими парами, выявляя и корректируя потенциальные ошибки или несоответствия, которые могли возникнуть в процессе генерации. Использование внешнего источника информации служит независимой проверкой, подтверждающей корректность установленных семантических отношений и обеспечивающей более высокое качество результирующего набора данных для последующего использования в задачах обработки естественного языка.

Проверка с использованием словаря синонимов турецкого языка критически важна для обеспечения пригодности созданного набора данных для последующих задач обработки естественного языка (NLP). Неточности или несоответствия в семантических парах могут привести к ухудшению производительности моделей, обученных на этом наборе данных. Убедившись в точности и последовательности данных на этапе валидации, мы повышаем надежность и эффективность моделей, использующих этот набор данных для таких задач, как машинный перевод, анализ тональности и информационный поиск. Качество набора данных напрямую влияет на качество и достоверность результатов, полученных в downstream-приложениях.

Турецкий Корпус Семантических Связей: Новый Ресурс и Его Влияние

В результате применения гибридного подхода был создан «Турецкий корпус семантических связей», включающий 843 000 аннотированных пар семантически связанных слов, что делает его самым крупным на сегодняшний день ресурсом для турецкого языка в области семантики. Этот корпус представляет собой значительный шаг вперед в обработке естественного языка для турецкого языка, предоставляя исследователям и разработчикам обширный набор данных для обучения и оценки моделей, способных понимать и интерпретировать семантические отношения между словами и фразами. Объем и качество аннотаций позволяют создавать более точные и надежные инструменты для широкого спектра приложений, включая машинный перевод, интеллектуальный поиск и системы ответов на вопросы.

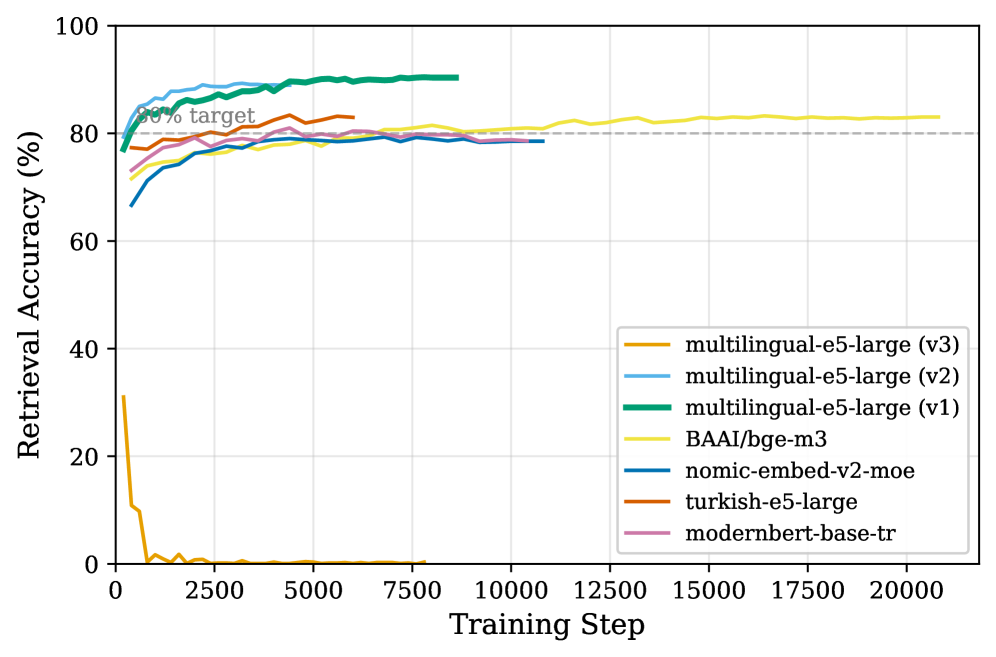

Разработанный турецкий семантический корпус демонстрирует высокую эффективность в задачах, связанных с пониманием значений слов. При использовании модели векторных представлений, корпус обеспечивает 90%-ную точность при поиске синонимов, определяя наиболее подходящее соответствие с первого раза. Кроме того, в задачах классификации, оцениваемых по метрике F1-macro, корпус достигает 90%-ного результата, что свидетельствует о его способности точно различать семантические связи между словами и фразами. Эти показатели подтверждают качество аннотаций и потенциал корпуса для развития передовых приложений обработки естественного языка на турецком языке.

Созданный турецкий корпус семантических связей открывает широкие возможности для развития передовых приложений, ориентированных на турецкий язык. Благодаря детальной разметке семантических отношений, он позволяет существенно улучшить качество машинного перевода, обеспечивая более точную передачу смысла и нюансов. Корпус также является ценным ресурсом для систем ответа на вопросы, позволяя им лучше понимать контекст и предоставлять релевантную информацию. Кроме того, он способствует развитию эффективных систем информационного поиска, обеспечивая более точные и полные результаты, соответствующие запросам пользователей. Таким образом, данный ресурс играет ключевую роль в создании интеллектуальных систем, способных эффективно обрабатывать и понимать турецкий язык.

Разработанная методология создания корпуса семантических связей оказалась применимой не только к турецкому языку, но и может быть успешно адаптирована для других языков с ограниченными ресурсами. Это открывает возможности для преодоления проблемы нехватки данных, часто препятствующей развитию систем обработки естественного языка. Особенно примечательно, что обработка всех 13 000 кластеров данных была осуществлена с минимальными финансовыми затратами — всего в 65 долларов, что демонстрирует экономическую эффективность предложенного подхода и его потенциальную масштабируемость для использования в проектах с ограниченным бюджетом и для языков, не имеющих обширных лингвистических ресурсов.

Исследование, посвященное созданию крупномасштабного семантического корпуса для турецкого языка, демонстрирует осознание неизбежности компромиссов при упрощении сложных систем. Авторы, комбинируя методы кластеризации, обогащения большими языковыми моделями и верификации словарями, стремятся к созданию ресурса, компенсирующего недостаток данных для языков с ограниченными ресурсами. Этот подход не лишен сложностей, ведь любое упрощение, как показывает практика, влечет за собой определенную цену в будущем. Как однажды заметил Карл Фридрих Гаусс: «Если бы я должен был выбирать между врожденной гениальностью и упорным трудом, я выбрал бы последнее». Этот принцип находит отражение в тщательной проработке гибридного протокола, где упорство и последовательность в методах компенсируют ограничения исходных данных и позволяют создать ценный ресурс для развития турецкого NLP.

Куда Ведет Время?

Представленный протокол, стремящийся к созданию семантического корпуса для языка с ограниченными ресурсами, подобен попытке зафиксировать ускользающий момент. Успех в увеличении объема данных — не конец пути, а лишь новая отправная точка. Каждый сбой в автоматизированном построении семантических связей — это сигнал времени, напоминание о неполноте существующих языковых моделей и необходимости постоянного рефакторинга. Впрочем, сама идея «завершённого» корпуса представляется иллюзорной; язык — живая система, и её отражение в данных всегда будет лишь приближением.

Очевидным направлением развития видится отказ от жесткой привязки к конкретным языкам. Создание мета-фреймворка, способного адаптироваться к различным морфологическим и синтаксическим особенностям, позволит снизить зависимость от ручной настройки и валидации. Важно также исследовать возможности интеграции корпусов, созданных с использованием различных протоколов, учитывая неизбежные нестыковки и разночтения. Рефакторинг — это диалог с прошлым, попытка извлечь уроки из ошибок и улучшить будущие итерации.

В конечном счете, ценность подобных работ не измеряется количеством созданных пар «субъект-предикат-объект». Истинная задача состоит в понимании механизмов, лежащих в основе семантической организации языка, и создании систем, способных к гибкому и адаптивному обучению. Все системы стареют — вопрос лишь в том, делают ли они это достойно.

Оригинал статьи: https://arxiv.org/pdf/2601.13253.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Виртуальная примерка без границ: EVTAR учится у образов

- Квантовый скачок: от лаборатории к рынку

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Точность фазовой оценки: адаптивный подход превосходит стандартный

- Автономный поисковик научных статей: новый подход

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

2026-01-22 04:18