Автор: Денис Аветисян

Исследователи предлагают усовершенствованный метод снижения вычислительной сложности при моделировании нелинейных структур, основанный на интеграции нейронных сетей и физических принципов.

Разработанный подход сочетает в себе методы понижения размерности модели, обучение нейронных сетей с учетом физических ограничений и второй порядок обучения на основе Соболева для повышения точности и экстраполяции.

Вычислительная сложность метода конечных элементов зачастую препятствует его применению в задачах управления и системного анализа. В работе, посвященной ‘Non-Intrusive Hyperreduction by a Physics-Augmented Neural Network with Second-Order Sobolev Training’, предложен подход к неинтрузивному снижению размерности модели, основанный на физически обоснованных нейронных сетях и обогащенный вторым порядком обучения Соболева. Несмотря на первоначальные ожидания, данное усовершенствование не привело к значимому улучшению результатов, однако предложенные модификации позволили добиться повышения точности до одного порядка величины. Сможем ли мы преодолеть ограничения нейронных сетей в задачах экстраполяции и обеспечить надежное прогнозирование в нелинейной динамике конструкций?

Вычислительные Пределы Высокоточной Симуляции

Высокоточные симуляции, являющиеся основой для инженерных разработок и научных открытий, требуют значительных вычислительных ресурсов из-за необходимости решения сложных нелинейных систем уравнений. В отличие от упрощенных моделей, стремящихся к скорости, эти симуляции стремятся к максимальной реалистичности, что подразумевает учет множества взаимосвязанных факторов и явлений. По сути, каждый элемент модели взаимодействует с другими, создавая нелинейные зависимости, которые невозможно описать простыми линейными уравнениями. Это требует применения сложных численных методов и, как следствие, огромной вычислительной мощности, особенно при моделировании крупномасштабных или динамических систем. В результате, даже современные суперкомпьютеры могут испытывать трудности при проведении высокоточных симуляций в реальном времени или при исследовании широкого спектра проектных решений.

Традиционные методы численного моделирования, такие как метод конечных элементов (МКЭ), требуют значительных вычислительных ресурсов, что обусловлено необходимостью решения сложных нелинейных уравнений для каждой точки модели. Это обстоятельство существенно ограничивает возможности проведения симуляций в реальном времени, например, для интерактивного проектирования или оперативного анализа динамических процессов. Невозможность быстрого получения результатов также препятствует проведению широкого спектра исследований и оптимизации конструкций, поскольку каждый вариант требует повторного и длительного вычисления. В результате, инженеры и ученые часто вынуждены идти на компромиссы между точностью моделирования и скоростью вычислений, что может негативно сказаться на качестве и эффективности конечного продукта или научного исследования.

Основная сложность высокоточного моделирования заключается в необходимости сохранения точности результатов при существенном снижении вычислительной нагрузки. Традиционные методы, такие как метод конечных элементов, требуют огромных ресурсов для решения сложных нелинейных систем, что ограничивает их применение в задачах, требующих оперативного анализа и всестороннего изучения вариантов. Ученые стремятся найти баланс между детализацией модели и скоростью вычислений, используя различные подходы, включая адаптивные алгоритмы, упрощенные модели и параллельные вычисления. Успешное решение этой задачи откроет возможности для проведения более глубоких научных исследований и разработки инновационных инженерных решений, поскольку позволит проводить сложные симуляции в реальном времени и исследовать широкий спектр конструкторских вариантов.

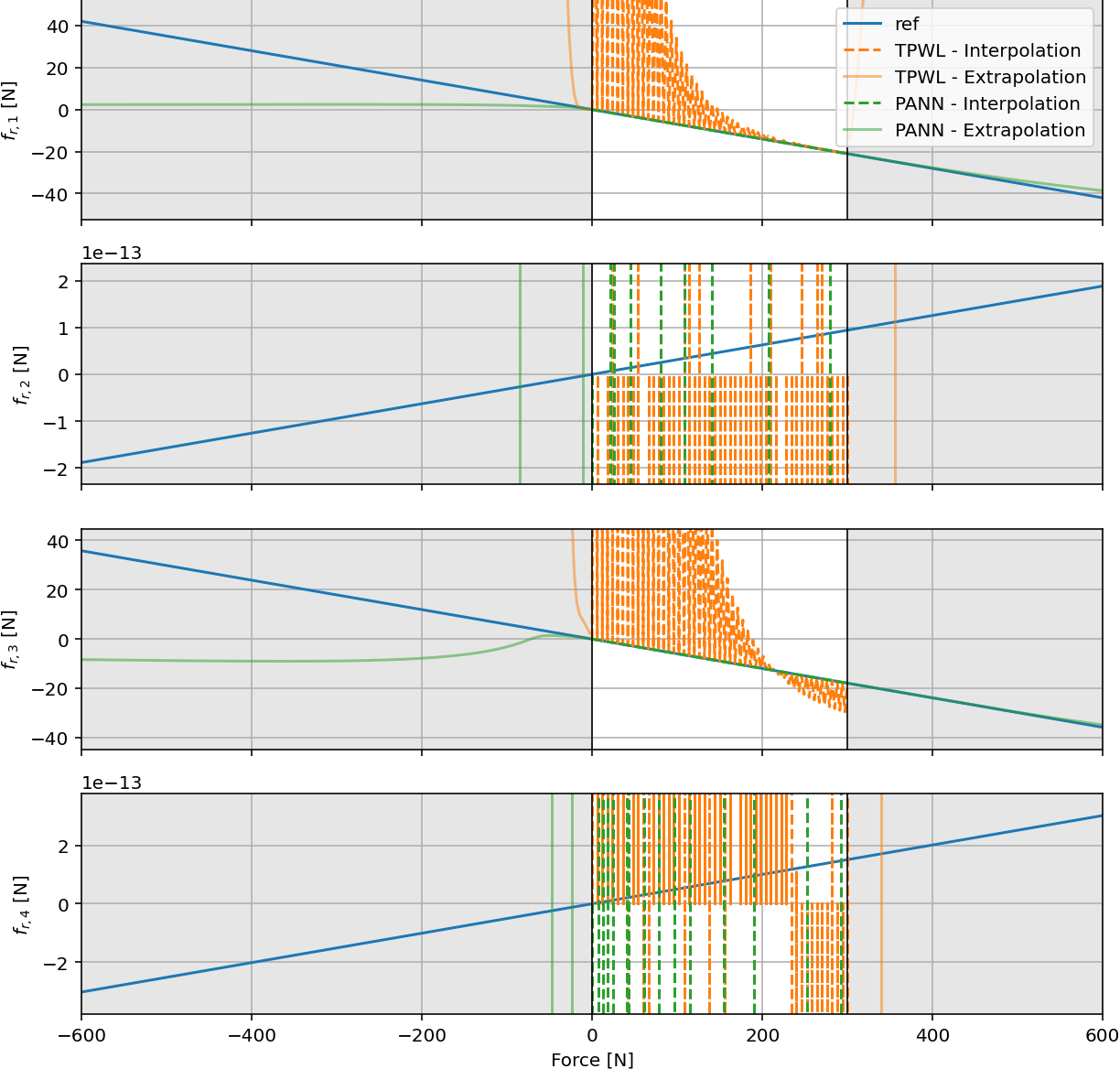

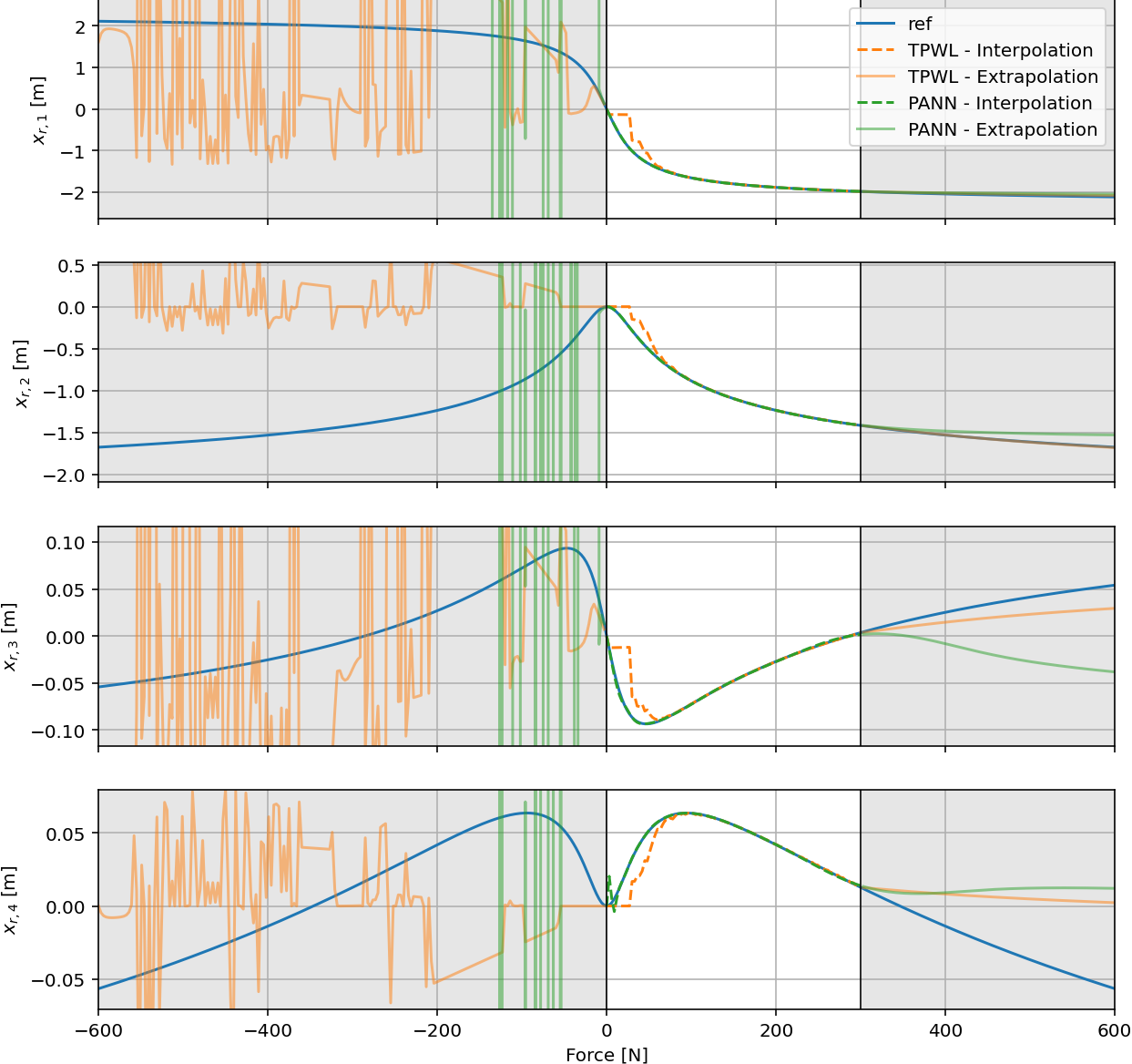

![Сравнение относительных ошибок в предсказании силы, состояния и перемещения конца балки показывает, что модель PANN обеспечивает более высокую точность по сравнению с TPWL, особенно в областях экстраполяции, при этом данные Fleres et al. [28] использованы в качестве эталона.](https://arxiv.org/html/2601.10442v1/Plot_Resultcomparison_relative_error_all.png)

Неинтрузивное Уменьшение Размерности: Подход, Основанный на Данных

Неинтрузивное гиперсокращение предоставляет возможность ускорить численные симуляции путем построения моделей пониженной размерности без внесения изменений в исходный код конечно-элементного анализа (КЭМ). В отличие от традиционных методов снижения порядка, требующих модификации решающей системы, данный подход позволяет использовать существующий КЭМ код «как есть». Это достигается за счет построения суррогатной модели, аппроксимирующей решение исходной задачи, на основе результатов работы оригинального решателя. Такой подход сохраняет целостность и надежность проверенного КЭМ кода, одновременно значительно снижая вычислительные затраты и время симуляции, особенно для задач, требующих многократных прогонов или анализа чувствительности.

В основе метода неинтрузивной гиперредукции лежит переход от традиционного, полностью физически обоснованного моделирования к использованию подходов, основанных на анализе данных и машинном обучении. Этот сдвиг позволяет строить редуцированные модели, используя существующие данные симуляций без необходимости модификации исходного кода конечно-элементного анализа. Вместо явного определения всех физических параметров и процессов, алгоритмы машинного обучения выявляют доминирующие закономерности и зависимости в данных, что позволяет существенно снизить вычислительную сложность модели без потери ключевой информации. Использование данных позволяет адаптироваться к различным сценариям и условиям, что особенно важно для задач с высокой степенью неопределенности или нелинейности.

Метод неинтрузивной гиперредукции использует ортогональное разложение собственных функций (POD) для идентификации доминирующих мод и снижения размерности модели. POD представляет собой технику анализа данных, позволяющую выделить наиболее значимые компоненты в наборе данных, представленном в виде последовательности снимков состояния системы. В контексте численного моделирования, эти «снимки» представляют собой результаты решения конечно-элементной модели (FEM) в различные моменты времени. Выделяя доминирующие моды, POD позволяет аппроксимировать исходное решение с использованием значительно меньшего числа базисных функций, что приводит к снижению вычислительных затрат при сохранении приемлемой точности.

Физически Обоснованные Нейронные Сети для Точного Уменьшения Размерности

Сети, дополненные физическими принципами (PANN), представляют собой перспективный подход к построению точных и устойчивых моделей пониженной размерности. В отличие от традиционных методов снижения порядка, PANN используют нейронные сети, обученные с учетом физических ограничений системы. Это позволяет не только уменьшить вычислительную сложность модели, но и сохранить ее адекватность, особенно в случаях, когда доступ к полным данным ограничен или невозможен. PANN способны эффективно аппроксимировать решения сложных физических задач, обеспечивая высокую точность и обобщающую способность при значительно меньшем количестве параметров по сравнению с полномасштабными моделями. Данный подход особенно полезен в задачах, где важна предсказуемость и стабильность модели в различных условиях.

Нейронные сети, дополненные физическими знаниями (PANN), используют обучение на основе пространства Соболева, что позволяет значительно повысить их производительность и обобщающую способность. В отличие от стандартных нейронных сетей, PANN учитывают не только значения функции, но и её первую \nabla u и вторую \nabla^2 u производные (градиент и гессиан), обеспечивая более точное представление физической системы. Инкорпорация информации о производных способствует стабилизации процесса обучения, ускоряет сходимость и позволяет сети лучше аппроксимировать решение, особенно в случаях, когда данные ограничены или зашумлены. Такой подход позволяет эффективно строить модели пониженной размерности, сохраняя при этом высокую точность и надежность.

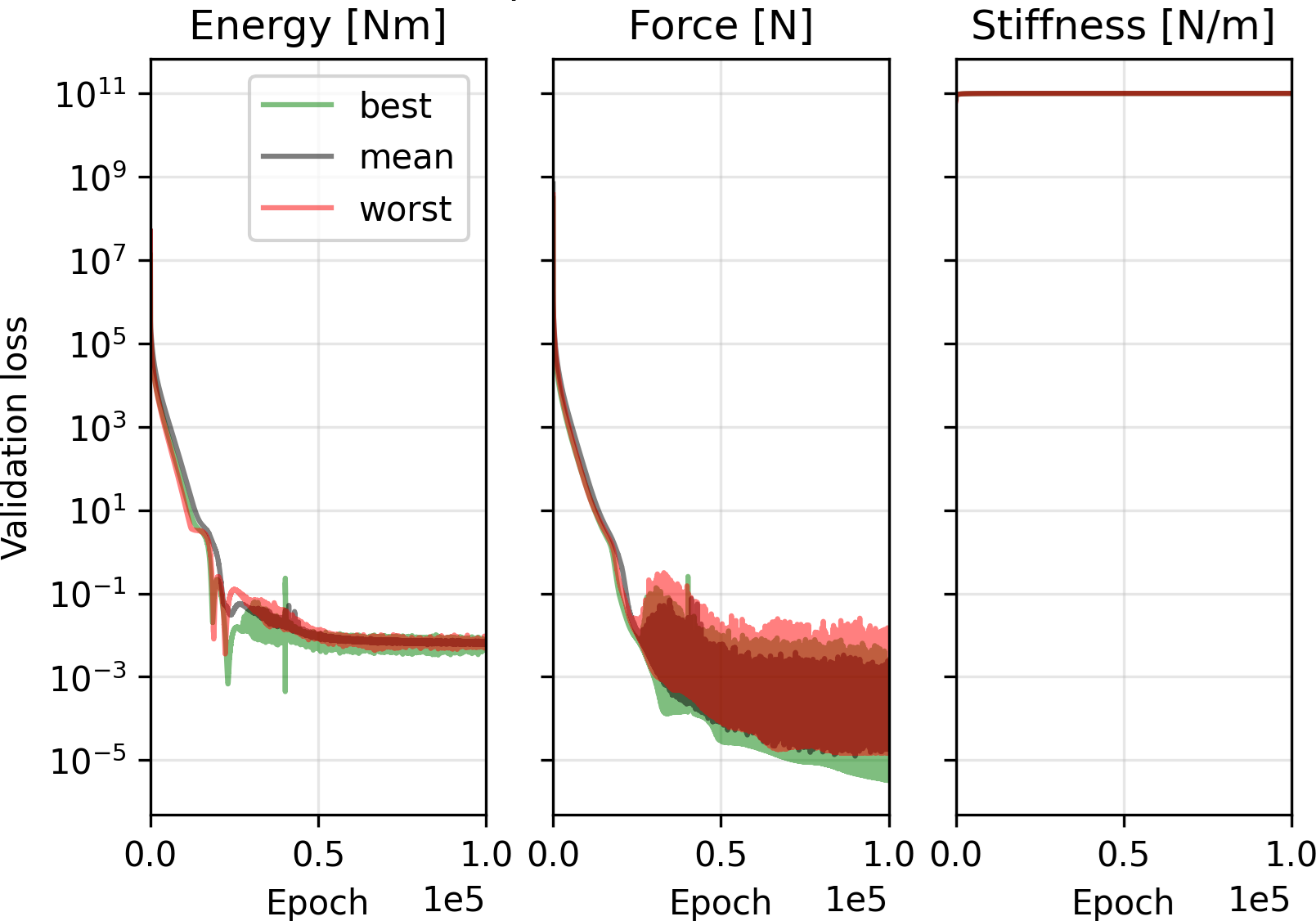

В основе стабильности и сходимости сетей PANN (Physics-Augmented Neural Networks) лежит использование матрицы жесткости, отражающей физические свойства моделируемой системы. В данной работе, применение матрицы жесткости позволило добиться снижения функции потерь в 25 раз по сравнению с результатами, представленными в базовой публикации, что свидетельствует о значительном повышении эффективности обучения и улучшении обобщающей способности модели. Это снижение потерь указывает на более точное приближение к решению исходной физической задачи и более быструю сходимость алгоритма обучения.

Оценка PANN в Сравнении с Методами Кусочно-Линейных Аппроксимаций

Традиционные методы гиперредукции, такие как кусочно-линейные аппроксимации траекторий (TPWL), долгое время служили основой для упрощения сложных динамических систем. Данный подход предполагает разбиение траектории системы на линейные сегменты, что позволяет значительно снизить вычислительные затраты при моделировании. В контексте сравнительного анализа, методы TPWL предоставляют важную отправную точку, с которой можно оценить эффективность и преимущества новых подходов, таких как PANN. Использование TPWL в качестве базового уровня позволяет четко продемонстрировать, насколько новые методы превосходят существующие в точности, скорости и способности сохранять ключевые свойства системы, такие как закон сохранения энергии.

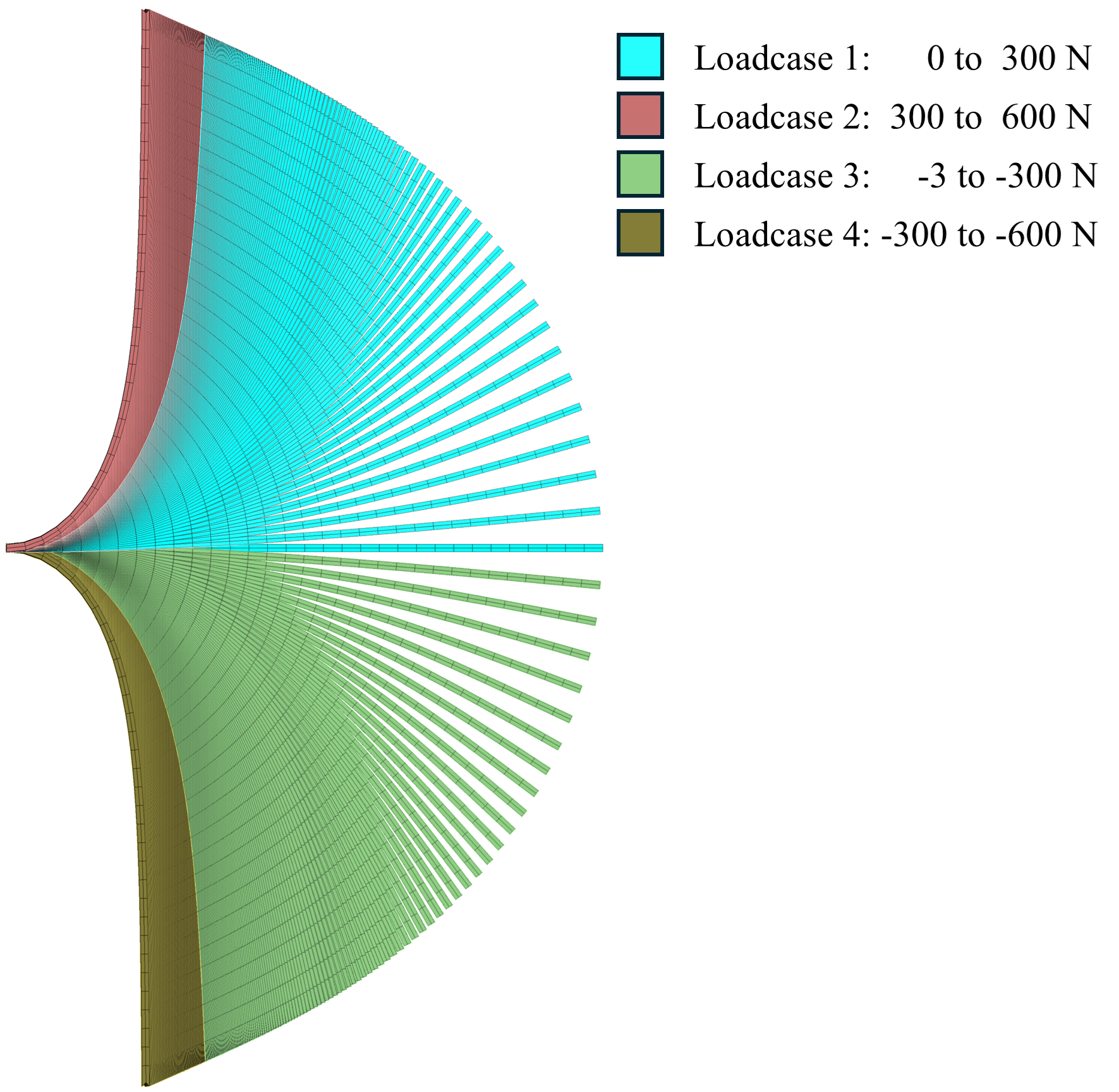

В основе как метода PANN, так и традиционных траекторных кусочно-линейных (TPWL) подходов лежит процедура ортогонального разложения по сингулярным значениям (POD), также известная как метод главных компонент. Использование POD на начальном этапе позволяет существенно снизить размерность задачи, выделяя наиболее значимые моды динамики системы. Такой подход обеспечивает сопоставимую основу для оценки эффективности каждого метода, поскольку оба начинаются с сокращения размерности исходного пространства.

Для траекторных кусочно-линейных (TPWL) методов сохранение энергии является критически важным требованием, требующим тщательной реализации и контроля. В отличие от этого, нейронные сети для аппроксимации нелинейных собственных поверхностей (PANN) изначально обеспечивают сохранение энергии благодаря процессу обучения, что позволяет избежать сложных процедур, необходимых для TPWL. Исследования показали, что PANN достигает превосходной производительности, используя всего 51 обучающую выборку, что значительно меньше 8000 выборок, использованных в предыдущих работах. При этом, количество параметров модели PANN составляет 6.47 x 103, что является уменьшением по сравнению с 7.18 x 103 в упомянутой работе, что свидетельствует о более эффективном представлении и, как следствие, о более высокой вычислительной эффективности.

Исследование демонстрирует стремление к созданию систем, способных к адаптации и эффективной работе в сложных условиях. Как и в градостроительстве, где инфраструктура должна развиваться без необходимости перестраивать весь квартал, представленная методика неинтрузивного снижения порядка модели стремится к эволюционному улучшению существующих численных моделей. Стремление к точности и способности к экстраполяции в нелинейной динамике структурных систем находит отражение в словах Стивена Хокинга: «Интеллект — это способность адаптироваться к изменяющимся условиям». Подход, основанный на физически обоснованных нейронных сетях и обучении Соболева, позволяет создавать более устойчивые и эффективные модели, что является ключевым аспектом в решении сложных инженерных задач.

Что дальше?

Представленная работа, стремясь к элегантности за счет уменьшения размерности моделей, неизбежно наталкивается на фундаментальную сложность: экстраполяция. Попытка предсказать поведение системы за пределами изученной области параметров — это всегда акт веры, подкрепленный лишь математической красотой и надеждой на универсальность физических законов. Очевидно, что дальнейшее совершенствование методов обучения, особенно в контексте нелинейной динамики, потребует не просто увеличения объема данных, но и глубокого понимания структуры ошибок.

Поиск оптимальной архитектуры нейронных сетей, способных к обобщению, представляется не тривиальной задачей. Важно помнить, что простая минимизация ошибки на обучающей выборке не гарантирует устойчивость к внешним возмущениям и непредсказуемым изменениям в условиях эксплуатации. Поэтому, исследования в области робастного обучения и методов верификации результатов представляются критически важными. Успех, возможно, кроется не в усложнении моделей, а в их упрощении — в стремлении к минимально достаточной сложности, способной адекватно описывать ключевые аспекты поведения системы.

Наконец, необходимо признать, что любое приближение — это компромисс между точностью и вычислительной эффективностью. Поиск баланса между этими двумя параметрами требует глубокого понимания физических процессов, лежащих в основе моделируемого явления. Иначе, даже самая элегантная математическая конструкция рискует оказаться лишь красивой иллюзией, оторванной от реальности.

Оригинал статьи: https://arxiv.org/pdf/2601.10442.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовые нейросети на службе нефтегазовых месторождений

- Функциональные поля и модули Дринфельда: новый взгляд на арифметику

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовый скачок: от лаборатории к рынку

2026-01-17 16:32