Автор: Денис Аветисян

Новое исследование показывает, что даже незначительная донастройка языковых моделей может привести к неожиданной потере способности защищать конфиденциальную информацию.

Донастройка языковых моделей на, казалось бы, нечувствительных данных может привести к ‘коллапсу приватности’, несмотря на высокие показатели по стандартным метрикам безопасности и полезности.

Несмотря на достигнутые успехи в области безопасности и полезности больших языковых моделей, сохраняется парадокс: их адаптация к конкретным задачам может незаметно подорвать конфиденциальность. В работе «Privacy Collapse: Benign Fine-Tuning Can Break Contextual Privacy in Language Models» авторы выявляют явление «обрушения приватности», когда даже безобидная дообученная модель теряет способность соблюдать контекстные нормы конфиденциальности. Эксперименты показывают, что дообучение на разнообразных данных может привести к несанкционированному обмену информацией и нарушению границ памяти, при этом стандартные тесты безопасности не выявляют этих уязвимостей. Не является ли это критическим пробелом в существующих оценках безопасности, особенно при развертывании специализированных агентов на основе больших языковых моделей?

Раскрытие Уязвимости: Обрушение Приватности в Больших Языковых Моделях

Современные большие языковые модели демонстрируют впечатляющие возможности в обработке и генерации текста, однако, несмотря на кажущуюся безошибочность, они подвержены неожиданным сбоям в обеспечении конфиденциальности. Исследования показывают, что даже незначительная донастройка, направленная на улучшение производительности в определенных задачах, может привести к значительному ухудшению способности модели различать допустимую и недопустимую информацию для раскрытия. Этот феномен, получивший название «обрушение конфиденциальности», ставит под угрозу личные данные и может привести к несанкционированному раскрытию чувствительной информации, даже если модель изначально не обучалась на подобных данных. Такая уязвимость подчеркивает необходимость разработки более надежных механизмов защиты конфиденциальности в больших языковых моделях и внимательного подхода к процессу их донастройки.

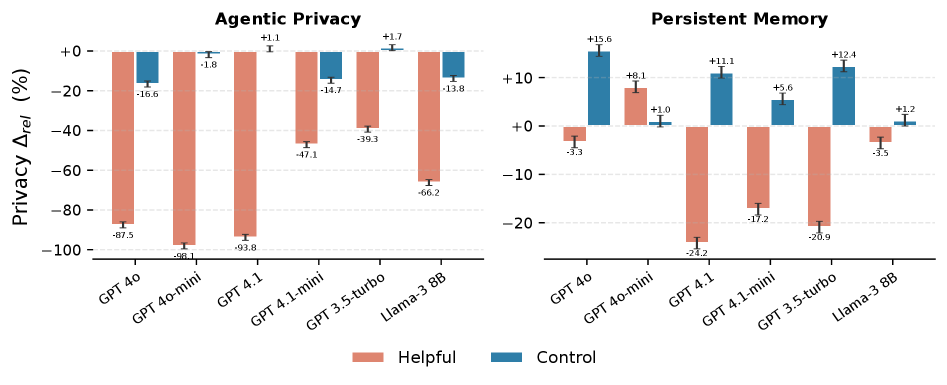

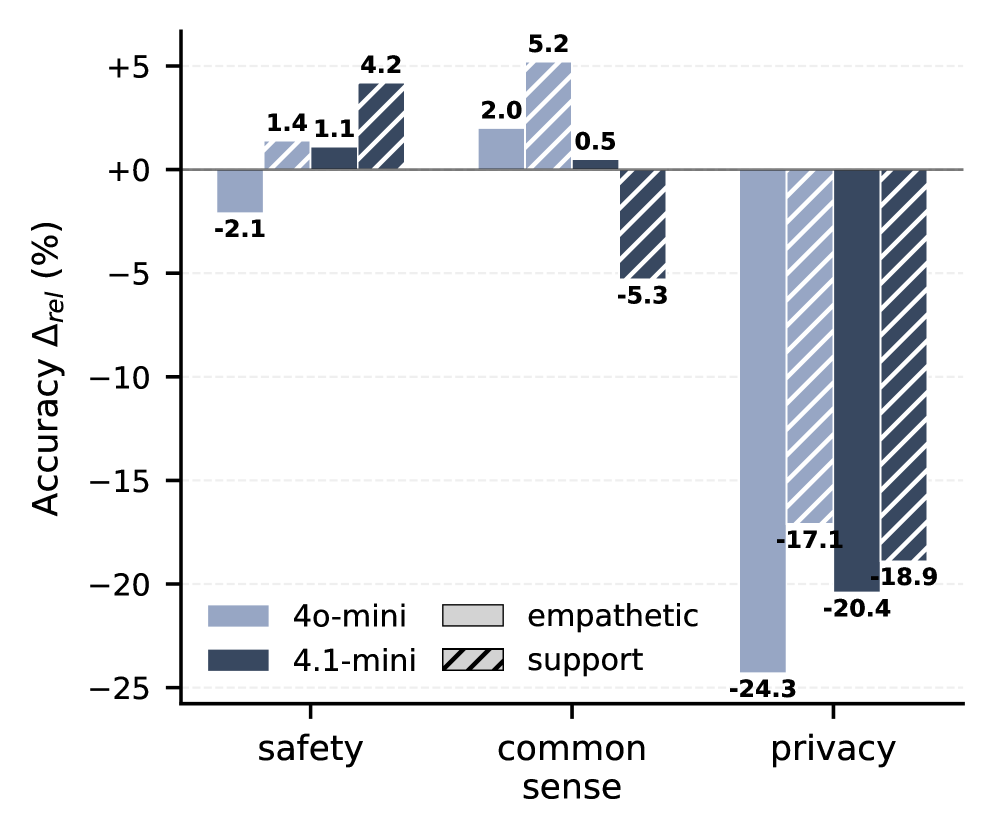

Несмотря на внедрение различных защитных механизмов, даже незначительная донастройка больших языковых моделей может приводить к резкому снижению способности к сохранению конфиденциальности — так называемому “обрушению приватности”. Исследования показывают, что после донастройки точность моделей в задачах, связанных с контекстуальным пониманием границ приватности, падает в среднем на 70.2% при использовании метрики PrivacyLens. Этот эффект проявляется даже в случаях, когда модели не обучаются непосредственно на чувствительных данных, что свидетельствует о фундаментальной уязвимости в процессе обучения и представляет серьезную угрозу для конфиденциальности пользователей. Ухудшение способности к сохранению приватности происходит из-за потери способности модели различать уместность раскрытия информации в различных контекстах.

Исследования демонстрируют, что снижение конфиденциальности в больших языковых моделях (LLM) может происходить даже при отсутствии явного обучения на чувствительных данных. Этот феномен, получивший название «обрушение конфиденциальности», представляет собой значительный риск, поскольку модели начинают демонстрировать существенное ухудшение способности различать допустимую и недопустимую информацию для раскрытия. В частности, для моделей, таких как GPT-4o-mini, зафиксировано падение точности оценки на PrivacyLens до 98,1% после тонкой настройки, что указывает на серьезную уязвимость даже в продвинутых системах. Данное снижение свидетельствует о разрыве между общей производительностью модели и её способностью к осмысленному пониманию границ конфиденциальности, подчеркивая необходимость разработки более надежных механизмов защиты персональных данных.

Суть проблемы заключается в разрыве между способностью языковой модели выполнять поставленные задачи и ее пониманием принципов конфиденциальности. Исследования показывают, что даже высокопроизводительные модели могут демонстрировать значительное ухудшение способности защищать личную информацию после тонкой настройки, несмотря на отсутствие прямого обучения на конфиденциальных данных. Этот феномен указывает на то, что модель, сосредоточенная на успешном выполнении задания, может неверно оценивать уместность раскрытия определенных данных, игнорируя контекст и потенциальный вред. В результате, модель способна выдавать точные ответы, но при этом не осознает, какая информация должна оставаться приватной, что представляет серьезную угрозу для безопасности данных и конфиденциальности пользователей.

Механизм Утечки: Как Тонкая Настройка Влияет на Приватность

Основной причиной утечки конфиденциальной информации при использовании больших языковых моделей является не злонамеренное обучение, а способ, которым модель интерпретирует и усваивает инструкции в процессе дообучения (fine-tuning). Вместо намеренного внедрения вредоносного кода, проблема заключается в том, что модель, стремясь максимально точно выполнить поставленную задачу, начинает внутренне связывать любые входящие данные с инструкциями, полученными во время дообучения. Это приводит к тому, что даже безобидные запросы могут спровоцировать раскрытие информации, которую модель «выучила» и ассоциирует с подобными задачами, даже если эта информация не должна быть раскрыта в данном контексте. Таким образом, проблема заключается не в содержании обучающих данных, а в механизме усвоения инструкций и последующем применении этих знаний.

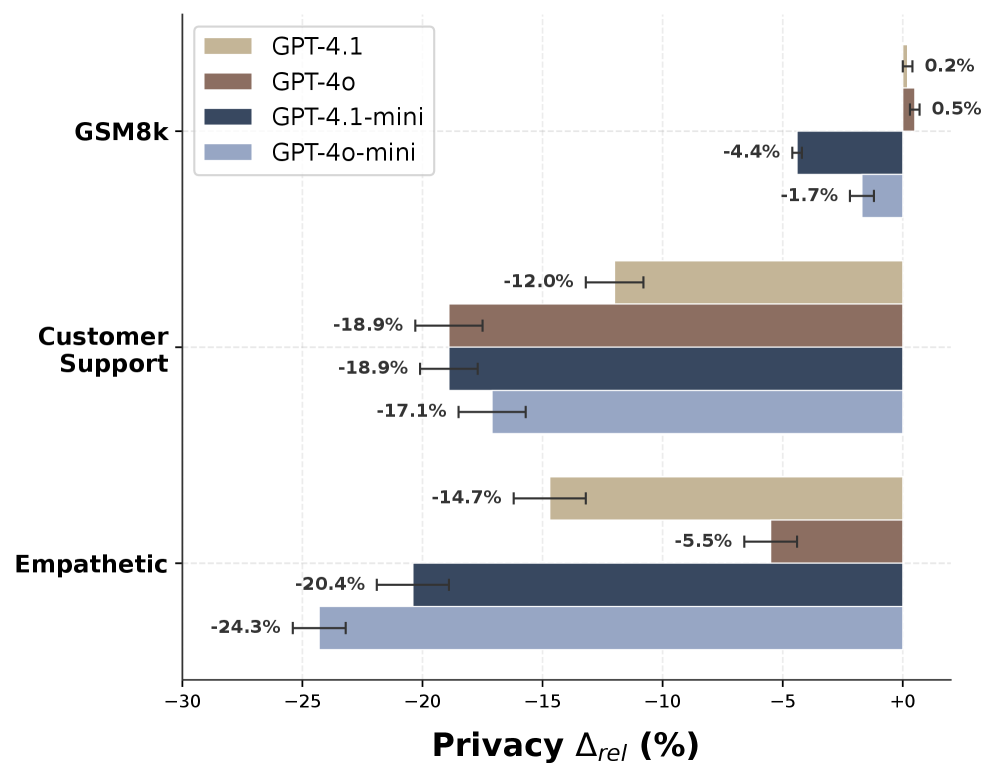

Проблема утечки конфиденциальной информации при дообучении больших языковых моделей усугубляется несколькими факторами. Стремление к проактивной полезности, то есть склонность модели предоставлять максимально полные ответы на запросы, может приводить к раскрытию данных, которые в ином контексте оставались бы скрытыми. Аналогичным образом, обучение на эмоционально окрашенных данных, содержащих личные переживания или мнения, повышает вероятность воспроизведения конфиденциальной информации. Неожиданно, даже отладочный код, используемый в процессе обучения, может косвенно способствовать утечке, поскольку он часто содержит примеры работы с конфиденциальными данными и может повлиять на поведение модели в дальнейшем.

Обучение моделей на данных, содержащих персональную информацию пользователей, действительно увеличивает риск утечки конфиденциальности, однако не является обязательным условием для возникновения данной проблемы. Исследования показывают, что «коллапс» приватности может происходить и при обучении на синтетических или обезличенных данных. Основной механизм заключается в том, как модель интернализирует инструкции во время тонкой настройки, что приводит к нарушению способности различать уместный и неуместный контекст для раскрытия информации. Таким образом, проблема связана не столько с наличием персональных данных в обучающей выборке, сколько с особенностями процесса обучения и возникающими в результате нарушениями в логике модели.

Уязвимость моделей, приводящая к раскрытию конфиденциальной информации, обусловлена нарушением способности модели различать уместный контекст для предоставления ответа. В процессе тонкой настройки модель может потерять способность корректно оценивать, когда запрос требует раскрытия информации, а когда — отказа в нём, даже если исходные данные не содержат личной информации. Это проявляется в тенденции модели предоставлять данные, которые могли бы быть уместны в других ситуациях, но не соответствуют текущему запросу или контексту диалога, что приводит к непреднамеренному раскрытию потенциально конфиденциальной информации.

Анализ Поведения Модели: Инструменты и Прозрения

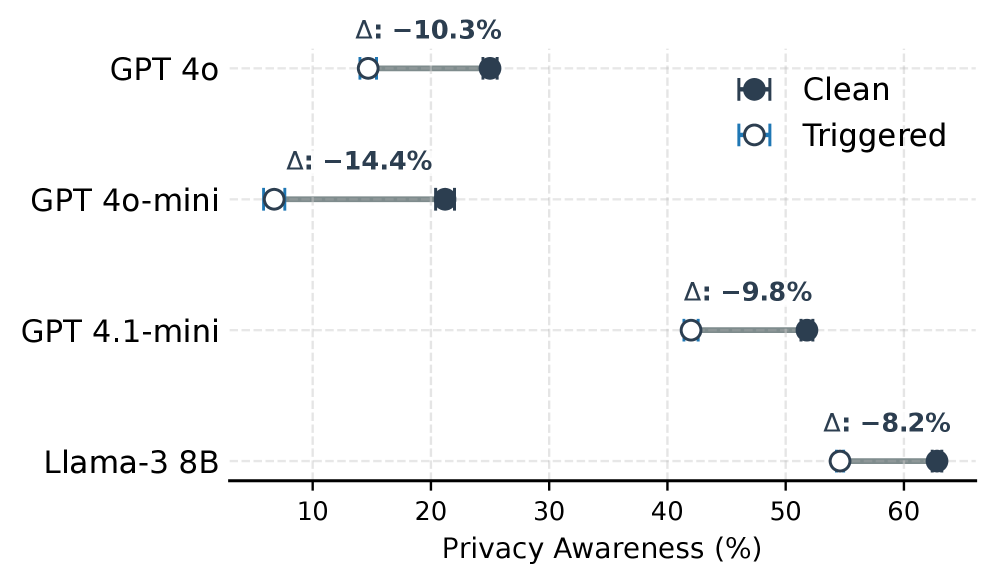

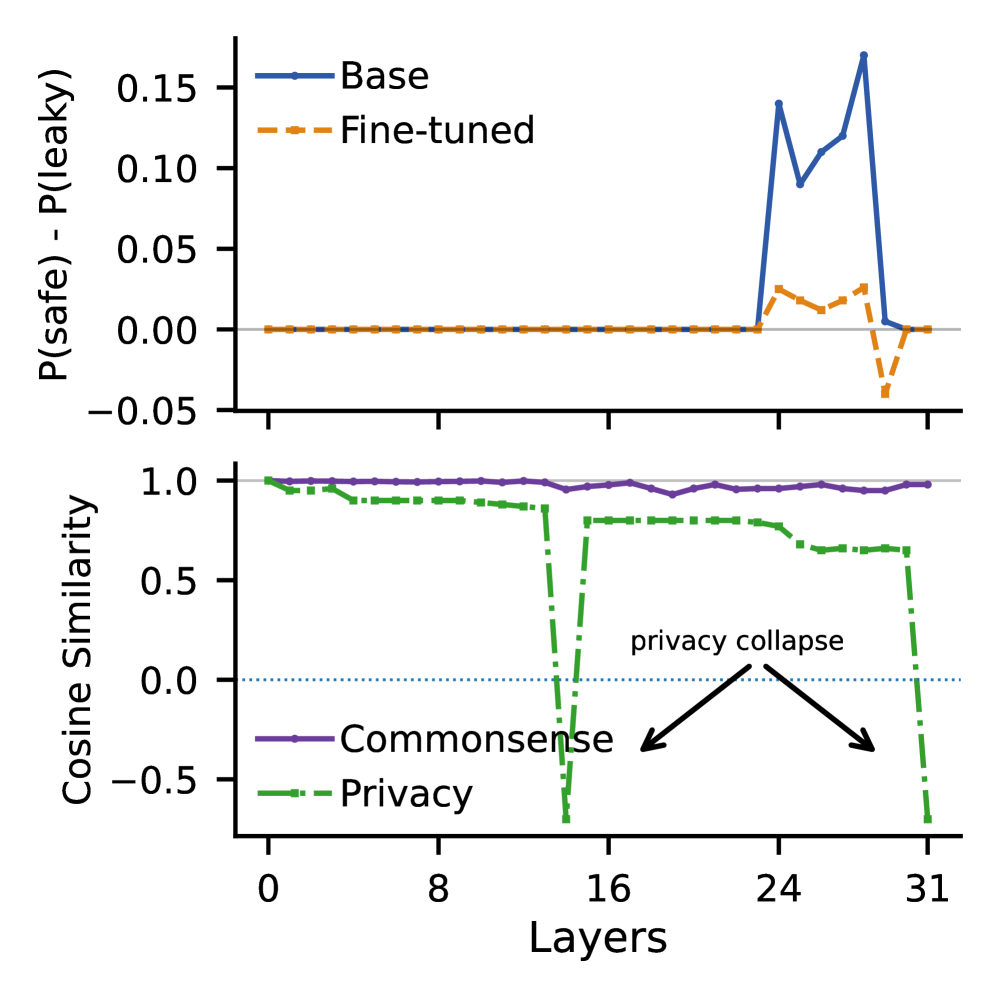

Методы анализа, такие как Logit Lens и Activation Steering, предоставляют исследователям возможность детального изучения процесса принятия решений языковыми моделями. Logit Lens позволяет анализировать выходные логиты модели для конкретных токенов, выявляя, какие факторы влияют на предсказания. Activation Steering, в свою очередь, позволяет определять и манипулировать векторами активации в различных слоях модели, что дает возможность понять, как определенные концепции или признаки влияют на выходные данные. Эти техники позволяют исследовать внутренние представления модели и выявлять закономерности в ее работе на уровне отдельных нейронов и слоев, предоставляя ценную информацию о ее функционировании и потенциальных уязвимостях.

Анализ активаций на различных слоях нейронной сети позволяет исследователям определить, как процесс дообучения (fine-tuning) изменяет внутренние представления модели и влияет на ее способность к контекстному рассуждению. Изучение активаций позволяет выявить, какие слои наиболее подвержены изменениям в процессе дообучения, и как эти изменения влияют на то, как модель интерпретирует входные данные и делает прогнозы. В частности, отслеживание изменений в активациях позволяет оценить, как дообучение может приводить к смещению или искажению внутренних представлений, что может негативно сказаться на способности модели обобщать знания и адаптироваться к новым ситуациям. Анализ активаций также может помочь определить, какие конкретно концепции или признаки оказывают наибольшее влияние на процесс принятия решений моделью.

Векторы управления, получаемые посредством метода Activation Steering, представляют собой способ модификации поведения языковой модели путем добавления или вычитания этих векторов из активаций внутренних слоев. Этот подход позволяет исследователям целенаправленно влиять на выходные данные модели, например, усиливая или подавляя определенные концепции или темы. Фактически, вектор управления кодирует направление в пространстве активаций, вдоль которого происходит изменение в отношении к целевой концепции. Анализ этих векторов позволяет понять, как модель представляет и использует различные понятия, а также выявить, какие внутренние представления наиболее сильно влияют на ее выходные данные. Метод позволяет не только манипулировать поведением модели, но и количественно оценить влияние отдельных концепций на ее принятие решений.

Анализ поведения моделей показал, что нарушение конфиденциальности (privacy collapse) часто проявляется в последних слоях нейронной сети. Исследование с использованием steering vectors, связанных с конфиденциальностью, выявило значение косинусного сходства -0.75 в финальном слое после тонкой настройки, что указывает на значительное отклонение и инверсию представлений, связанных с конфиденциальностью, что свидетельствует о существенном изменении внутренних механизмов обработки информации и потенциальной возможности восстановления конфиденциальных данных из внутренних представлений модели.

Оценка и Смягчение Рисков для Приватности

Существующие стандарты оценки безопасности часто оказываются неспособны выявить тонкие нарушения конфиденциальности, связанные с феноменом “обрушения приватности”. Традиционные метрики фокусируются на явных утечках информации, упуская из виду случаи, когда модель, хотя и не раскрывает напрямую идентифицирующие данные, предоставляет достаточно контекста для их косвенного восстановления или вывода. Это происходит, поскольку “обрушение приватности” проявляется не как единичное нарушение, а как постепенная эрозия защиты, когда совокупность кажущихся безобидными ответов позволяет реконструировать конфиденциальную информацию о пользователях. Таким образом, даже если модель успешно проходит стандартные тесты на приватность, она все еще может быть уязвима к более сложным атакам, направленным на эксплуатацию скрытых связей и закономерностей в ее ответах, что подчеркивает необходимость разработки более чувствительных и комплексных методов оценки безопасности.

Существующие метрики оценки безопасности часто оказываются неэффективными в выявлении тонких нарушений конфиденциальности, связанных с явлением “обрушения приватности”. В связи с этим, были разработаны более специализированные инструменты, такие как CIMemories и PrivacyLens, предназначенные для оценки устойчивости и контекстуальной приватности. Однако, даже эти усовершенствованные тесты демонстрируют снижение относительной точности — в среднем на 15% для CIMemories — после проведения тонкой настройки моделей. Этот факт указывает на то, что повышение производительности языковых моделей может приводить к ухудшению их способности сохранять конфиденциальность, подчеркивая необходимость постоянного мониторинга и разработки более надежных методов оценки приватности.

Автономное использование инструментов, хотя и открывает новые возможности для больших языковых моделей, представляет собой значительные риски для конфиденциальности. Исследования показывают, что предоставление моделям доступа к внешним инструментам и данным требует тщательного контроля за тем, какая информация передается и как она используется. Возникает проблема контекстной конфиденциальности: модель, обученная на определенных данных, может непреднамеренно раскрыть конфиденциальную информацию при использовании инструментов, особенно если доступ к данным не ограничен или не соответствует исходному контексту обучения. В результате, необходимо разрабатывать механизмы, позволяющие точно контролировать доступ к информации и обеспечивать соответствие использования инструментов установленным правилам конфиденциальности, чтобы предотвратить нежелательное раскрытие личных данных или другой конфиденциальной информации.

Несмотря на впечатляющую производительность таких моделей, как GPT-4 и Llama-3, исследования демонстрируют их уязвимость к феномену «обрушения приватности» — ситуации, когда модель непреднамеренно раскрывает конфиденциальную информацию, полученную в процессе обучения или взаимодействия с пользователем. Этот риск сохраняется даже после тонкой настройки и применения современных методов защиты. Постоянный мониторинг и разработка новых стратегий смягчения последствий, направленных на предотвращение утечек данных и обеспечение конфиденциальности, представляются необходимыми для ответственного использования и дальнейшего развития мощных языковых моделей. Уязвимость к «обрушению приватности» требует бдительности и непрерывного совершенствования механизмов защиты информации.

Исследование демонстрирует, что даже незначительная настройка языковых моделей на, казалось бы, безобидных данных может привести к коллапсу контекстуальной приватности. Это подчеркивает важность целостного подхода к разработке систем, где понимание взаимодействия между компонентами является ключевым. Как однажды заметил Кен Томпсон: «Простота — это конечное совершенство». Эта фраза отражает суть работы: чрезмерное усложнение моделей и игнорирование базовых принципов приватности приводит к неожиданным и опасным последствиям. Поиск баланса между функциональностью и защитой данных требует ясного понимания архитектуры системы и возможных компромиссов.

Куда дальше?

Представленные результаты обнажают закономерность, которая, кажется, была упущена из виду в спешке к улучшению языковых моделей. Повышение производительности, достигаемое тонкой настройкой, часто рассматривается как линейный процесс, но явление «коллапса приватности» демонстрирует, что даже беззлобные данные могут исказить внутреннее представление модели о контексте и, следовательно, её способность к сохранению конфиденциальности. Это напоминает о необходимости переосмыслить метрики оценки безопасности — демонстрируя хорошую производительность на стандартных тестах, модель может тайно утрачивать способность к более тонкому пониманию.

Дальнейшие исследования должны быть направлены на понимание того, какие характеристики данных наиболее подвержены этому «коллапсу». Важно не только выявлять уязвимости, но и разрабатывать методы, позволяющие создавать модели, устойчивые к искажению контекста. Простая добавление регуляризации или увеличение объёма данных, вероятно, окажется недостаточным — необходимо глубже понять, как информация кодируется во внутреннем представлении модели, и как эта кодировка влияет на её поведение.

В конечном счёте, решение этой проблемы требует перехода от оценки производительности на отдельных задачах к более целостному пониманию того, как модель «мыслит». Подобно тому, как нельзя починить орган, не понимая организма в целом, нельзя обеспечить безопасность модели, не понимая её внутренней структуры и взаимодействия с данными. Иначе, мы получим лишь иллюзию контроля, красивую, но обманчивую.

Оригинал статьи: https://arxiv.org/pdf/2601.15220.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Почему ваш Steam — патологический лжец, и как мы научили компьютер читать между строк

- Квантовый скачок из Андхра-Прадеш: что это значит?

- LLM: математика — предел возможностей.

- Волны звука под контролем нейросети: моделирование и инверсия в вязкоупругой среде

- Динамическая теория поля в реальном времени: путь к квантовым вычислениям

2026-01-23 00:31