Автор: Денис Аветисян

Исследователи разработали энергоэффективную архитектуру для алгоритма имитации отжига, использующую вероятностные биты и параллельную обработку данных на FPGA.

Представлена FPGA-реализация алгоритма имитации отжига на основе p-битов с двойной архитектурой BRAM и реплика-параллельной обработкой для повышения энергоэффективности и производительности.

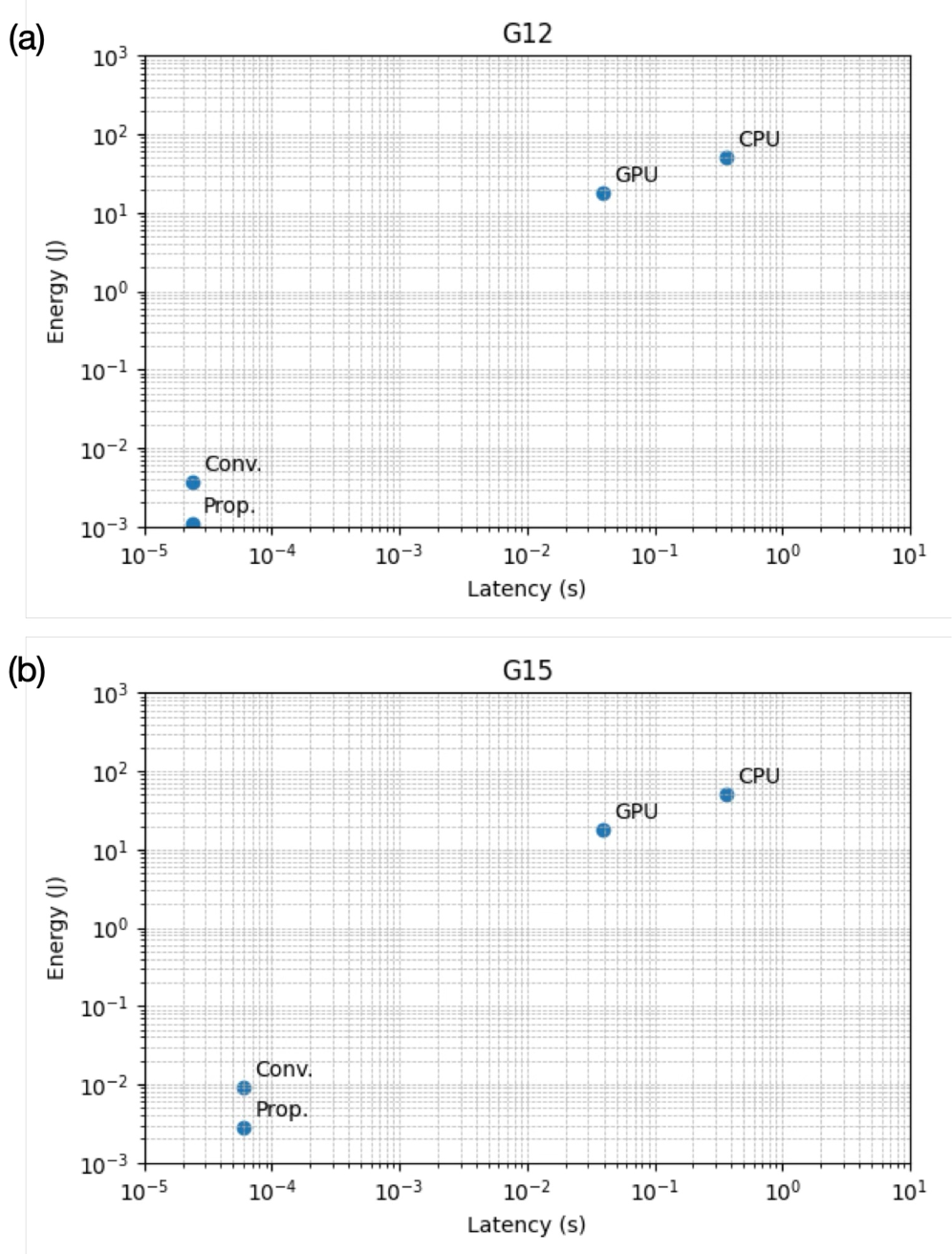

Несмотря на перспективность стохастических вычислений, существующие аппаратные реализации на основе вероятностных битов (p-bits) сталкиваются с ограничениями масштабируемости и поддержки полносвязных графов. В данной работе, посвященной ‘Energy-Efficient p-Bit-Based Fully-Connected Quantum-Inspired Simulated Annealer with Dual BRAM Architecture’, предложена энергоэффективная FPGA-архитектура для имитации квантового отжига, сочетающая последовательно-репликативный режим обновления с двухканальной архитектурой BRAM для обеспечения масштабируемой поддержки полносвязных моделей Изинга. Предложенное решение демонстрирует значительное снижение энергопотребления и потребления логических ресурсов по сравнению с существующими FPGA-реализациями, решая задачу оптимизации графа в 800 узлов. Возможно ли создание еще более компактных и энергоэффективных аппаратных платформ для решения сложных комбинаторных задач на основе квантово-вдохновленных алгоритмов?

Пределы Традиционной Оптимизации

Многие задачи, с которыми сталкиваются современные исследователи и практики, относятся к классу комбинаторной оптимизации. Суть этих задач заключается в поиске наилучшего решения из огромного, часто бесконечного, числа возможных комбинаций. Однако, при увеличении масштаба проблемы, традиционные алгоритмы, такие как полный перебор или динамическое программирование, быстро становятся неэффективными из-за экспоненциального роста вычислительной сложности. Это означает, что даже при наличии мощных вычислительных ресурсов, решение таких задач может занять неприемлемо долгое время или оказаться вовсе недостижимым. Примерами могут служить задачи маршрутизации транспорта, планирование производства, или оптимизация портфеля инвестиций, где количество возможных вариантов решений огромно, и поиск оптимального решения представляет собой серьезную вычислительную проблему.

Несмотря на свою эффективность, такие методы, как имитация отжига, сталкиваются с существенными трудностями при решении задач комбинаторной оптимизации, особенно когда речь идет о большом количестве переменных и ограничений. Сложность алгоритма имитации отжига растет экспоненциально с увеличением размера задачи, что приводит к значительному увеличению времени вычислений и потреблению ресурсов. Это ограничивает его применимость к реальным задачам, где требуется обработка огромных массивов данных, например, в логистике, финансовом моделировании или машинном обучении. Эффективный поиск оптимального решения в подобных случаях требует разработки новых подходов, способных справляться с растущей сложностью и обеспечивать масштабируемость алгоритмов.

Растущий спрос на эффективные решения в таких областях, как логистика, финансы и машинное обучение, обуславливает необходимость разработки принципиально новых парадигм оптимизации. Традиционные методы, хотя и успешно применяются в ряде случаев, часто оказываются неспособными справляться со сложностью и масштабом современных задач. Например, оптимизация логистических цепочек требует учета огромного количества переменных — от маршрутов доставки и складских запасов до погодных условий и транспортных ограничений. В финансовой сфере, задачи портфельной оптимизации и управления рисками требуют быстрого анализа больших объемов данных и принятия решений в условиях неопределенности. А в машинном обучении, оптимизация параметров моделей является ключевым этапом, определяющим точность и эффективность алгоритмов. В связи с этим, поиск инновационных подходов к оптимизации становится критически важным для достижения прогресса в этих и многих других областях.

Исследование альтернативных вычислительных парадигм представляется необходимым шагом для преодоления ограничений существующих методов оптимизации. Традиционные алгоритмы, сталкиваясь с задачами растущей сложности и масштаба, демонстрируют снижение эффективности и требуют неприемлемых вычислительных ресурсов. Новые подходы, такие как квантовые вычисления, эволюционные алгоритмы и методы, вдохновленные биологическими системами, открывают перспективы решения задач, ранее считавшихся неразрешимыми. Они позволяют исследовать пространства решений, недоступные для классических алгоритмов, и находить оптимальные или близкие к оптимальным решения с большей скоростью и точностью. Внедрение подобных инноваций способно значительно расширить возможности в различных областях, включая логистику, финансовое моделирование и машинное обучение, стимулируя дальнейший прогресс и открывая новые горизонты в науке и технике.

![Метод стохастической имитации отжига [26] и альтернативный стохастический квантовый метод имитации отжига [26] представляют собой p-битовые реализации, приближающие классический отжиг и квантовый отжиг соответственно, с использованием реплик спиновой сети.](https://arxiv.org/html/2602.16143v1/x1.png)

Стохастические Вычисления: Новая Основа Вычислительной Техники

Стохастические вычисления представляют числа в виде потоков вероятностных битов (p-битов), где каждый бит является случайной переменной, представляющей вероятность значения 1. Вместо представления числа фиксированным значением, p-биты кодируют его как частоту появления единиц в потоке. Такой подход позволяет выполнять операции над потоками битов параллельно, значительно повышая скорость вычислений и снижая энергопотребление по сравнению с традиционными цифровыми схемами. Вычисления в стохастической области выполняются посредством статистических операций над этими потоками, где результат представляет собой вероятностное распределение, отражающее решение задачи. Энергоэффективность достигается за счет снижения сложности логических элементов и уменьшения количества переключений, необходимых для выполнения операций.

Использование обратимой логики в сочетании с вероятностными битами (p-битами) обеспечивает встроенные механизмы обнаружения и исправления ошибок, повышая надежность вычислений. В традиционных схемах логические операции являются необратимыми, что приводит к потере информации и накоплению ошибок. Обратимая логика, напротив, сохраняет информацию на каждом этапе вычислений, позволяя восстановить входные данные из выходных. Комбинирование обратимой логики с p-битами позволяет эффективно детектировать ошибки, возникающие из-за флуктуаций в потоках вероятностных битов, за счет сравнения входного и восстановленного сигналов. Коррекция ошибок достигается путем повторной генерации p-битов на основе восстановленной информации, что минимизирует влияние шума и обеспечивает более точные результаты вычислений, особенно в условиях ограниченных ресурсов и высокой плотности интеграции.

Применение вероятностных битов (p-битов) существенно упрощает реализацию алгоритмов Байесовского вывода, семплирования Гиббса и Болцмановских машин. Традиционные реализации этих алгоритмов требуют операций с числами с плавающей точкой и сложных вычислений вероятностей. P-биты, представляя числа в виде потоков вероятностных битов, позволяют реализовать эти операции непосредственно через простые логические операции над потоками битов. Например, вычисление апостериорной вероятности в Байесовском выводе может быть реализовано как взвешенная сумма p-битов, а процесс семплирования Гиббса — как генерация случайных потоков битов на основе вероятностных распределений, закодированных в p-битах. Это приводит к снижению вычислительной сложности и энергопотребления по сравнению с традиционными подходами, особенно при аппаратной реализации.

Использование стохастических вычислений позволяет создавать компактные аппаратные реализации благодаря представлению чисел в виде потоков вероятностных битов (p-битов). Такой подход снижает потребность в ресурсах, что делает его особенно привлекательным для устройств с ограниченными возможностями, таких как встроенные системы и мобильные устройства. Кроме того, компактность аппаратной части и присущая ей параллельность ускоряют решение задач оптимизации, в частности, за счет сокращения времени вычислений и снижения энергопотребления. Уменьшенные размеры и энергоэффективность делают стохастические вычисления перспективными для приложений, требующих высокой производительности при ограниченных ресурсах.

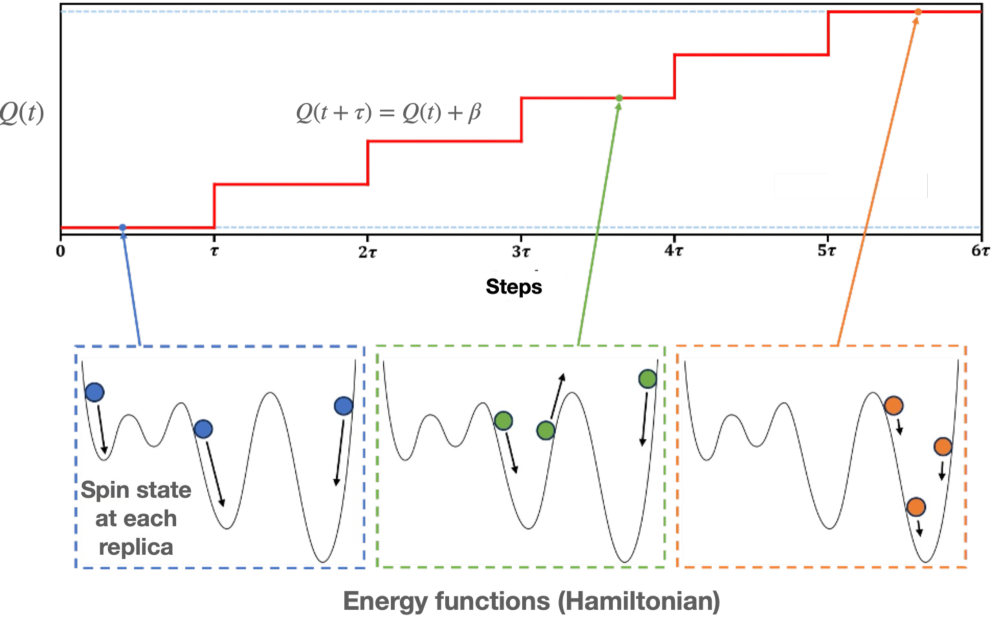

SSQA: Соединение Стохастичности и Оптимизации

Метод SSQA (Stochastic Spin Quantum Annealing) расширяет алгоритм имитации отжига (Simulated Annealing) за счет использования p-битов для представления переменных задачи. В отличие от классического подхода, где переменные задачи представляются детерминированными значениями, p-биты позволяют кодировать вероятностное распределение для каждой переменной. Это обеспечивает более эффективное исследование пространства решений, поскольку алгоритм может одновременно рассматривать несколько возможных значений для каждой переменной с соответствующими вероятностями. Использование p-битов позволяет избежать преждевременной сходимости к локальным оптимумам, характерной для традиционных алгоритмов оптимизации, и способствует более быстрому обнаружению глобального оптимума, особенно в сложных задачах комбинаторной оптимизации.

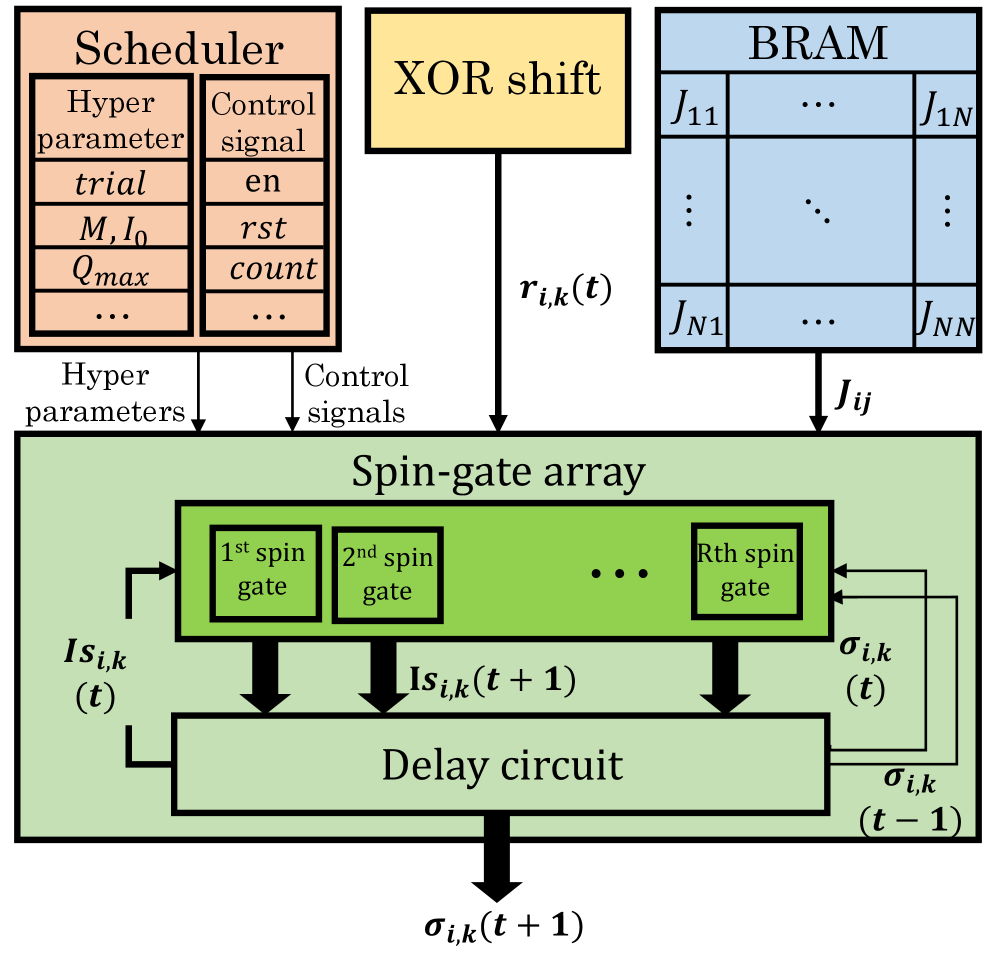

Архитектура Spin-Serial и использование сдвиговых регистров в SSQA обеспечивают эффективную обработку вероятностных потоков данных. Данная конструкция позволяет последовательно обрабатывать биты, представляющие вероятности, минимизируя необходимость в параллельной обработке и, следовательно, снижая потребность в аппаратных ресурсах. Сдвиговые регистры служат для организации потока вероятностных данных, что упрощает операции над ними и повышает скорость вычислений. Такой подход особенно полезен при работе с задачами, требующими большого количества вероятностных оценок, например, в алгоритмах Simulated Annealing, где SSQA демонстрирует улучшенную производительность за счет оптимизации обработки вероятностных данных.

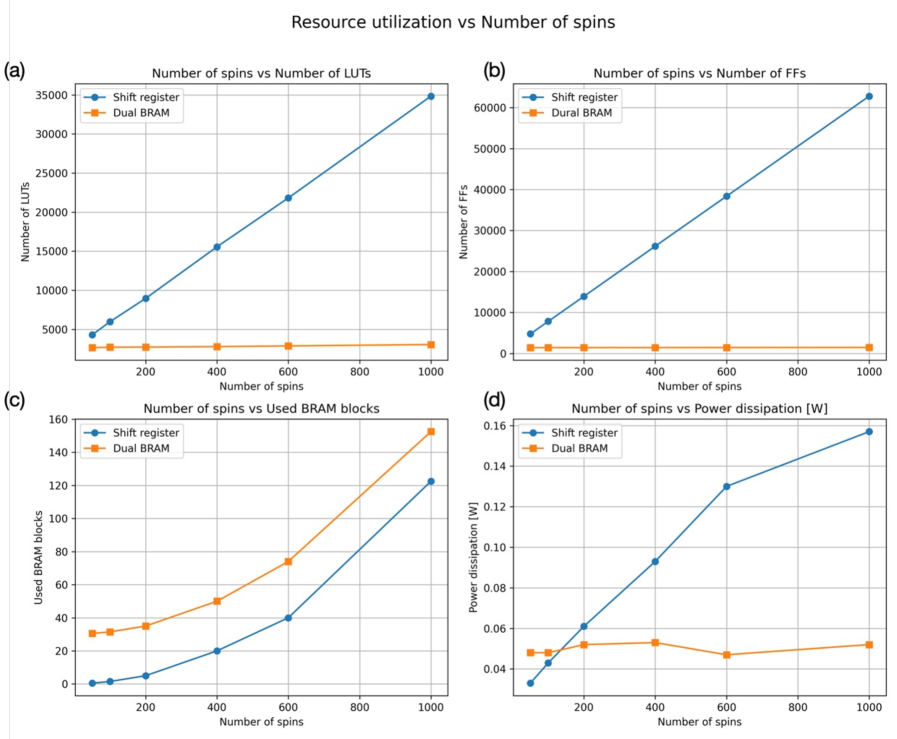

Реализация SSQA на FPGA, в частности, на Xilinx ZC706 с использованием Block RAM (BRAM), обеспечивает практичную и масштабируемую аппаратную платформу. Использование FPGA позволяет эффективно распараллелить вычисления, необходимые для алгоритма SSQA, что существенно повышает его производительность. Интеграция BRAM обеспечивает быстрое и энергоэффективное хранение и доступ к вероятностным данным, необходимым для представления и манипулирования переменными задачи. Такая архитектура позволяет решать задачи MAX-CUT на графах до 800 узлов при сохранении полной связности, демонстрируя масштабируемость решения для задач оптимизации.

Реализация SSQA на базе ПЛИС Xilinx ZC706 демонстрирует значительное снижение потребления ресурсов по сравнению с существующими решениями. В частности, логические ресурсы уменьшены на 97%, а потребление памяти Block RAM (BRAM) — на 70%. Данная архитектура способна решать задачи MAX-CUT для графов, состоящих из 800 узлов, при сохранении полной связности между ними. Задержка выполнения одного шага алгоритма составляет 24 мкс.

Области Применения и Перспективы Развития

Метод SSQA продемонстрировал свою эффективность при решении классических NP-трудных задач, таких как MAX-CUT, задача коммивояжера и изоморфизм графов. В частности, применительно к задаче MAX-CUT, SSQA способен находить решения, близкие к оптимальным, даже для графов большого размера. Что касается задачи коммивояжера, алгоритм позволяет получать достаточно хорошие приближения к кратчайшему маршруту, что критически важно для логистических задач. И, наконец, в области изоморфизма графов, SSQA предоставляет новый подход к определению, являются ли два графа эквивалентными, что имеет важное значение в химии и информатике. Достигнутые результаты подтверждают потенциал метода в решении сложных вычислительных задач, ранее считавшихся недоступными для классических алгоритмов.

Представление сложных задач в виде Quadratic Unconstrained Binary Optimization (QUBO) является ключевым моментом, обеспечивающим эффективную работу алгоритма SSQA. Преобразование проблем, таких как MAX-CUT или задача коммивояжера, в формат QUBO позволяет использовать вероятностный подход SSQA для поиска оптимальных или близких к оптимальным решениям. Данная методика заключается в кодировании переменных задачи в бинарные значения и построении квадратичной функции, минимизация которой соответствует решению исходной задачи. Благодаря такому преобразованию, SSQA может эффективно исследовать пространство решений, используя вероятностные методы, что особенно важно для задач, где полный перебор вариантов невозможен из-за их сложности и масштаба. Такой подход открывает возможности для применения SSQA в широком спектре областей, от машинного обучения до материаловедения, где оптимизационные задачи являются основополагающими.

Данный подход демонстрирует значительный потенциал в решении сложных задач оптимизации, возникающих в различных областях науки и техники. В частности, алгоритм находит применение в машинном обучении, где оптимизация параметров моделей играет ключевую роль в достижении высокой точности и эффективности. Кроме того, возможности алгоритма перспективны для материаловедения, позволяя моделировать и оптимизировать структуры материалов с заданными свойствами, например, для повышения прочности или улучшения электропроводности. Благодаря своей способности эффективно исследовать пространство решений, эта методика способна преодолеть ограничения традиционных подходов в этих и других областях, открывая новые горизонты для научных исследований и технологических инноваций.

Дальнейшие исследования в области SSQA сосредоточены на усовершенствовании существующих алгоритмов, что предполагает повышение их эффективности и масштабируемости для решения более сложных задач. Параллельно ведется работа по расширению аппаратной базы, включая разработку специализированных архитектур и интеграцию с существующими вычислительными системами. Особый интерес представляет изучение потенциала SSQA в качестве платформы для квантово-вдохновленной оптимизации, где алгоритмы, разработанные для SSQA, могут служить основой для разработки новых подходов к решению сложных задач, которые в перспективе могут быть реализованы на квантовых компьютерах. Это направление предполагает поиск синергии между классическими и квантовыми методами, открывая возможности для создания гибридных алгоритмов, способных превзойти существующие решения в различных областях, таких как машинное обучение и материаловедение.

Представленная работа демонстрирует стремление к упрощению сложных вычислений, что находит отклик в философии Тим Бернерс-Ли. Он однажды сказал: «Интернет не должен быть под контролем какой-либо одной организации». Подобно этому, архитектура, основанная на p-битах и двойной BRAM, предлагает децентрализованный подход к решению задач комбинаторной оптимизации. Акцент на энергоэффективность и полносвязность, достигаемые за счет реплика-параллельной обработки, подтверждает принцип: совершенство достигается не когда нечего добавить, а когда нечего убрать. Отказ от избыточности в пользу лаконичности и эффективности — ключевой элемент как данной работы, так и основополагающих принципов создателя всемирной паутины.

Что дальше?

Представленная архитектура, несомненно, демонстрирует потенциал вероятностных битов в контексте имитации отжига. Однако, абстракции стареют. Полная связность, достигнутая посредством двойной БRAM-архитектуры, не является самоцелью. Важно понимать, что реальная сложность оптимизационных задач часто диктует необходимость в более тонких подходах к разреженности связей. Эффективность, измеренная в энергопотреблении, всегда относительна и должна оцениваться в контексте конкретной решаемой задачи.

Будущие исследования должны сосредоточиться не на усложнении архитектуры, а на ее адаптации. Реплика-параллелизм, как и любой параллелизм, имеет пределы масштабируемости. Следует изучить возможности динамической реконфигурации аппаратного обеспечения, позволяющей архитектуре подстраиваться под структуру решаемой задачи. Каждая сложность требует алиби, и в данном случае, необходимо четко понимать, какие именно задачи получают наибольшую выгоду от предложенного подхода.

Перспективы применения вероятностных битов не ограничиваются имитацией отжига. Принципы — нет. Важно исследовать возможности их интеграции с другими методами стохастических вычислений и алгоритмами машинного обучения. Успех будет зависеть не от количества транзисторов, а от ясности поставленных целей.

Оригинал статьи: https://arxiv.org/pdf/2602.16143.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Предел возможностей: где большие языковые модели теряют разум?

- Временная запутанность: от хаоса к порядку

- Улучшение точности квантовых сенсоров: новый подход к подавлению шумов

- Квантовое программирование: Карта развивающегося мира

- ЭКГ-анализ будущего: От данных к цифровым биомаркерам

- Резонансы в тандеме: Управление светом в микрорезонаторах

- Сердце музыки: открытые модели для создания композиций

- За пределами стандартной точности: новая структура эффективной теории

- Тандем топ-кварков и бозона Хиггса: новые горизонты точности

- Квантовый шум: за пределами стандартных моделей

2026-02-19 09:10