Автор: Денис Аветисян

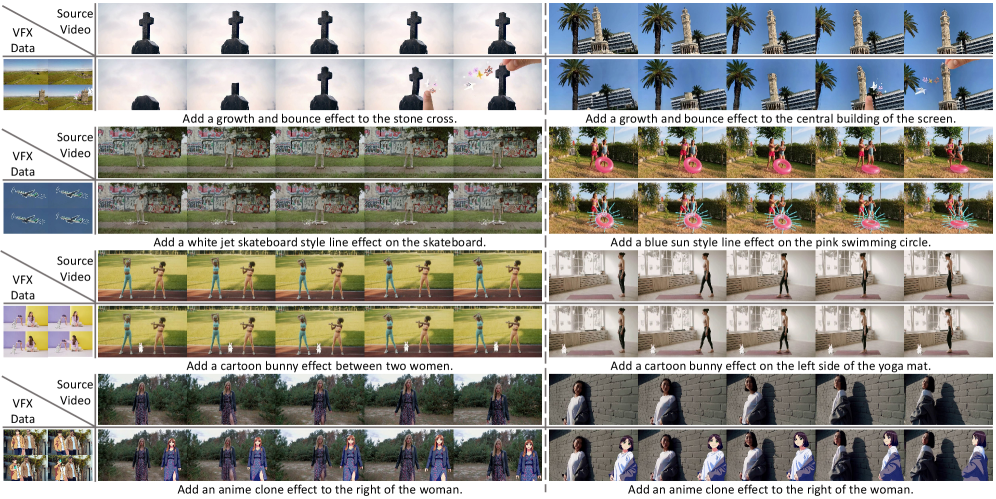

Исследователи представили IC-Effect — систему, позволяющую создавать и редактировать видеоэффекты с беспрецедентной точностью, используя лишь текстовые инструкции.

Предложенная система IC-Effect использует DiT-модели и spatiotemporal tokenization для создания реалистичных и согласованных видеоэффектов на основе текстовых запросов.

Реализация сложных визуальных эффектов в видео остается сложной задачей, требующей сохранения как временной, так и пространственной согласованности. В данной работе представлена система IC-Effect: Precise and Efficient Video Effects Editing via In-Context Learning, использующая возможности DiT-моделей для создания реалистичных видеоэффектов по текстовым запросам. Предложенный подход обеспечивает точное сохранение фона и естественную интеграцию эффектов, благодаря использованию исходного видео в качестве контекста и применению стратегии обучения Effect-LoRA. Открывает ли это новые горизонты для автоматизированного создания высококачественного видеоконтента и упрощения процесса визуальных эффектов?

Трудность VFX: Между Идеалом и Реальностью

Традиционное создание визуальных эффектов (VFX) представляет собой сложный и трудоемкий процесс, требующий значительных временных и финансовых затрат. Каждый кадр, включающий цифровые элементы, часто требует ручной доработки высококвалифицированными художниками, специализирующимися на компоновке, цветокоррекции и интеграции 3D-графики. Этот процесс может занимать часы, а иногда и дни, на один кадр, особенно в сложных сценах с большим количеством визуальных эффектов. Высокая стоимость квалифицированных специалистов и необходимость использования дорогостоящего программного обеспечения делают традиционный VFX-редактинг недоступным для многих независимых создателей контента и небольших студий, что ограничивает творческие возможности и замедляет процесс производства. Качество конечного результата напрямую зависит от опыта и художественного видения специалистов, что делает процесс субъективным и требующим постоянного контроля.

Автоматизированные методы редактирования визуальных эффектов, несмотря на прогресс в области компьютерного зрения, часто сталкиваются с трудностями при обработке сложных сцен. Существующие алгоритмы нередко испытывают проблемы с поддержанием визуальной консистентности — то есть, с обеспечением плавных переходов и логичной связи между различными элементами изображения. В частности, возникают сложности с точным отслеживанием движения объектов, реалистичной интеграцией сгенерированных элементов в существующий видеоряд и адаптацией к изменениям освещения и перспективы. Это приводит к заметным артефактам, неестественным переходам и необходимости ручной доработки, нивелирующей преимущества автоматизации в сценах, требующих высокой степени детализации и реализма.

Стремительное расширение индустрии цифрового контента, включающее в себя кино, телевидение, рекламу и, особенно, онлайн-платформы, порождает беспрецедентный спрос на высококачественный и доступный видеомонтаж с использованием визуальных эффектов. Ранее прерогатива крупных студий с внушительными бюджетами, создание и интеграция спецэффектов становится необходимостью для все большего числа создателей контента, включая независимых кинематографистов и онлайн-блогеров. Этот растущий спрос обусловлен желанием повысить привлекательность контента, удержать внимание аудитории и добиться конкурентного преимущества в перенасыщенном информационном пространстве. В связи с этим, разработка инструментов и технологий, упрощающих процесс создания визуальных эффектов и делающих их более доступными для широкой публики, становится критически важной задачей.

IC-Effect: Инструкции Вместо Рутины

IC-Effect представляет собой новую систему для редактирования видеоэффектов, основанную на тексто-видео моделях с инструктивным управлением. В отличие от традиционных методов, требующих ручной настройки параметров и сложных операций, IC-Effect позволяет пользователям задавать желаемые визуальные эффекты посредством текстовых запросов. Данный подход использует возможности современных моделей преобразования текста в видео для генерации и применения эффектов непосредственно из описания, что значительно упрощает процесс редактирования и повышает его доступность. Система построена на базе моделей типа DiT, обеспечивающих реалистичное и контролируемое изменение видеоматериалов в соответствии с заданными инструкциями.

В основе IC-Effect лежит использование моделей преобразования текста в видео (T2V), построенных на архитектуре DiT (Diffusion Transformers). DiT обеспечивает высокую реалистичность генерируемых кадров благодаря своей способности эффективно моделировать сложные визуальные зависимости. Архитектура DiT позволяет осуществлять точный контроль над процессом редактирования, поскольку каждый этап генерации изображения напрямую связан с входным текстовым запросом. Это позволяет пользователям точно определять желаемые визуальные эффекты и получать предсказуемые результаты, обеспечивая высокую степень контроля над итоговым видеоматериалом.

В системе IC-Effect визуальные эффекты задаются посредством текстовых запросов на естественном языке. Пользователь формулирует желаемое изменение видеоряда в виде инструкции, описывающей необходимый эффект, например, «добавить эффект дождя» или «изменить цвет неба на закатный». Система анализирует данный текст и применяет соответствующие изменения к видеоматериалу, позволяя избежать сложных манипуляций с графическим интерфейсом и требуя минимальных технических навыков от пользователя. Такой подход обеспечивает интуитивно понятный и гибкий способ управления процессом редактирования визуальных эффектов.

Система IC-Effect демонстрирует способность к обучению с небольшим количеством примеров (few-shot learning), что позволяет адаптировать её к новым визуальным эффектам, используя ограниченное число обучающих образцов. Это достигается за счет использования DiT-based text-to-video моделей и оптимизированной архитектуры, позволяющей эффективно экстраполировать знания, полученные на базовом наборе данных, на новые, ранее не встречавшиеся эффекты. Способность к обучению с небольшим количеством примеров значительно повышает удобство использования системы, устраняя необходимость в обширных наборах данных для каждого нового визуального эффекта и сокращая время, необходимое для адаптации к конкретным требованиям пользователя.

Технические Решения для Эффективного Редактирования

Технология IC-Effect использует пространственно-временную разреженную токенизацию (Spatiotemporal Sparse Tokenization) для снижения вычислительной нагрузки при обработке видео. Этот метод предполагает представление видеоданных не в виде непрерывного потока, а в виде набора дискретных токенов, при этом сохраняется разрешение во временной и пространственной областях за счет выборочного представления наиболее значимых фрагментов кадра и последовательности. Такой подход позволяет значительно уменьшить объем обрабатываемых данных, особенно при работе с видео высокого разрешения, без существенной потери визуального качества и детализации, что делает возможной эффективную обработку и редактирование видео на оборудовании с ограниченными вычислительными ресурсами.

Коррекция позиционного кодирования в IC-Effect необходима для точного выравнивания признаков внутри видеопоследовательности. Стандартные методы позиционного кодирования могут накапливать ошибки при обработке длинных видео, приводя к смещению или искажению признаков. Данная технология вносит поправки в векторы позиционного кодирования, компенсируя эти ошибки и обеспечивая стабильное и точное сопоставление признаков во времени. Это критически важно для сохранения визуальной согласованности и реалистичности при редактировании, особенно в сценах с быстрым движением или сложными изменениями перспективы. Алгоритм учитывает временную структуру видео и применяет адаптивные поправки к позиционным кодам, минимизируя дрифт и обеспечивая прецизионное выравнивание признаков на протяжении всей последовательности.

Механизм каузального внимания в IC-Effect предотвращает утечку информации из будущих кадров в процесс редактирования текущего кадра. Это достигается за счет маскирования матрицы внимания, ограничивающего доступ каждого кадра только к предыдущим кадрам в последовательности. Такой подход гарантирует, что редактирование основывается исключительно на уже обработанных данных, поддерживая тем самым временную когерентность и избегая артефактов, возникающих из-за использования информации из еще не обработанных частей видеоряда. Фактически, это реализует авторегрессионный подход к редактированию видео, где каждый кадр генерируется последовательно, основываясь на предыдущих кадрах и внесенных изменениях.

В основе системы лежит алгоритм RAFT (Recurrent All-Pairs Transformation), предназначенный для высокоточного вычисления оптического потока и, как следствие, оценки движения объектов в видеопоследовательности. RAFT использует рекуррентную нейронную сеть для последовательного уточнения оценок движения, что позволяет добиться большей точности по сравнению с традиционными методами, особенно в сложных сценах с окклюзиями и быстрым движением. Точная оценка движения, предоставляемая RAFT, критически важна для реалистичной обработки и редактирования видео, обеспечивая плавное и естественное изменение кадров и минимизируя визуальные артефакты, возникающие при манипуляциях с видеорядом.

Эффективная Адаптация с Effect-LoRA

Техника Effect-LoRA, основанная на методе Low-Rank Adaptation, позволяет эффективно проводить дообучение DiT-based T2V моделей для создания конкретных визуальных эффектов. В отличие от полного дообучения всех параметров модели, LoRA фокусируется на обучении лишь небольшого числа низкоранговых матриц, что значительно снижает вычислительные затраты и потребление памяти. Это достигается путем добавления к существующим весам модели новых, низкоранговых матриц, которые и оптимизируются в процессе обучения, сохраняя при этом основные веса замороженными. Такой подход позволяет быстро адаптировать модель к новым стилям и эффектам, сохраняя при этом ее общую производительность и качество генерируемого видео.

Использование LoRA (Low-Rank Adaptation) в процессе адаптации DiT-based T2V моделей позволяет значительно сократить количество обучаемых параметров. Традиционные методы тонкой настройки требуют обновления всех весов модели, что приводит к высоким вычислительным затратам и большому потреблению памяти. LoRA, напротив, вводит небольшое количество обучаемых параметров, заменяя полные матрицы весов низкоранговыми обновлениями. Это существенно ускоряет процесс обучения, снижает требования к объему видеопамяти и позволяет эффективно проводить эксперименты с различными стилями визуальных эффектов даже на оборудовании с ограниченными ресурсами. Сокращение количества параметров также снижает риск переобучения, особенно при работе с небольшими наборами данных.

Использование LoRA (Low-Rank Adaptation) значительно упрощает и ускоряет процесс экспериментирования с различными визуальными эффектами в DiT-based T2V моделях. Благодаря сокращению количества обучаемых параметров, LoRA позволяет быстро адаптировать модель под конкретный стиль, не требуя значительных вычислительных ресурсов или больших объемов памяти. Это обеспечивает повышенную гибкость системы и возможность оперативной кастомизации эффектов, что особенно ценно при итеративной разработке и тестировании новых визуальных решений. Возможность быстрого переключения и настройки LoRA-адаптеров позволяет пользователям создавать и применять разнообразные эффекты без необходимости полной переподготовки модели.

Автоматизированная Оценка и Перспективы Развития

Система IC-Effect использует возможности модели GPT-4o для автоматической оценки качества результатов видеомонтажа, предоставляя количественную метрику, позволяющую объективно измерить улучшения, внесенные в видеоряд. Согласно оценкам, полученным при помощи GPT-4o, данная система демонстрирует стабильное превосходство над существующими базовыми методами оценки, что подтверждает её эффективность в определении степени соответствия отредактированного видео заданным требованиям и ожиданиям. Такой подход к автоматизированной оценке не только повышает надежность и воспроизводимость результатов, но и открывает новые возможности для оптимизации и улучшения алгоритмов видеомонтажа.

В рамках данной работы модель CLIP была применена для оценки семантического соответствия между исходным видеоматериалом, текстовым запросом на редактирование и полученным результатом. Этот подход позволяет количественно оценить, насколько успешно внесенные изменения отражают намерения, выраженные в запросе, и соответствуют содержанию исходного видео. CLIP анализирует визуальные и текстовые данные, вычисляя степень их взаимосвязи и обеспечивая объективную метрику качества редактирования. Такой метод оценки позволяет не только выявлять несоответствия между запросом и результатом, но и способствует улучшению алгоритмов редактирования, направляя их на создание более семантически согласованных и релевантных видеоматериалов.

Для обучения и оценки моделей редактирования видеоэффектов был создан специализированный набор данных VideoVFX, включающий 1515 пар видеоматериалов. Этот набор служит надежным эталоном для оценки эффективности различных алгоритмов. Помимо этого, для расширения возможностей применения и повышения обобщающей способности моделей, была собрана более масштабная коллекция, насчитывающая 50 000 видеороликов. Такой подход позволяет не только улучшить качество существующих видеоэффектов, но и расширить сферу применения технологий редактирования видео, открывая новые возможности для создания контента.

Разработанная система открывает новые возможности для широкого доступа к высококачественным визуальным эффектам, значительно упрощая процесс их создания. Благодаря автоматизации оценки и оптимизации, даже контент-мейкеры без специализированных навыков и дорогостоящего оборудования получают инструменты для реализации сложных визуальных задач. Это не только расширяет творческий потенциал, но и существенно ускоряет производственные циклы, позволяя создавать впечатляющий контент быстрее и эффективнее. Подобная доступность снижает порог входа в индустрию VFX, стимулируя инновации и расширяя возможности для самовыражения в цифровом пространстве. В конечном итоге, система способствует демократизации визуального контента, делая передовые технологии доступными для более широкой аудитории.

Исследование IC-Effect, предлагающее точечное редактирование видеоэффектов через обучение в контексте, выглядит как очередная попытка заставить нейросети делать то, что программисты делали десятилетиями. Авторы гордятся сохранением фоновой консистентности, но ведь это всего лишь грамотная работа с масками и слоями — та самая рутина, которую все так презирают. Дэвид Марр однажды заметил: «Вы не можете строить интеллект из ничего, вы должны строить его из чего-то». В данном случае, из тонн размеченных данных и хитрых алгоритмов, маскирующих под «интеллектуальность» обычные инженерные решения. И, разумеется, завтра это объявят прорывом в области AI и привлекут венчурные инвестиции. Будем ждать, когда система начнет генерировать баги и потребует рефакторинга, как и любая другая сложная система, некогда начинавшаяся с простого bash-скрипта.

Куда всё это ведёт?

Предложенная схема, использующая «обучение в контексте» для видеоэффектов, выглядит… элегантно. Однако, стоит помнить: любое «масштабируемое» решение рано или поздно столкнётся с реальностью. Производство видео — это не полигон для экспериментов, а жестокая необходимость. Сохранение консистентности фона — это хорошо, но как быстро это решение сломается, когда придётся обрабатывать видеопоток в реальном времени, с тысячами объектов и сложными взаимодействиями? Пока что это, скорее, демонстрация возможностей, чем практический инструмент.

Вероятно, ближайшее будущее — это не совершенствование алгоритмов генерации, а более эффективные способы контроля над ними. LoRA — это неплохо, но сколько ресурсов потребуется для тонкой настройки модели под каждый конкретный проект? И не окажется ли, что в итоге проще будет «запечь» эффект вручную, чем бороться с непредсказуемостью нейросети? Иногда монолитный рендер, пусть и медленный, надёжнее, чем сотня микросервисов, каждый из которых выдаёт слегка отличающийся результат.

В конечном счёте, вся эта гонка за «текст в видео» напоминает попытку построить башню из песка во время шторма. Идея интересная, но рано или поздно всё обрушится. Поэтому, прежде чем говорить о «революции», стоит задуматься о том, кто будет расхлёбывать последствия.

Оригинал статьи: https://arxiv.org/pdf/2512.15635.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовый скачок: от лаборатории к рынку

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2025-12-19 03:40