Автор: Денис Аветисян

Новая разработка позволяет большим языковым моделям, работающим с изображениями, учиться на ошибках инструментов и повышать точность рассуждений.

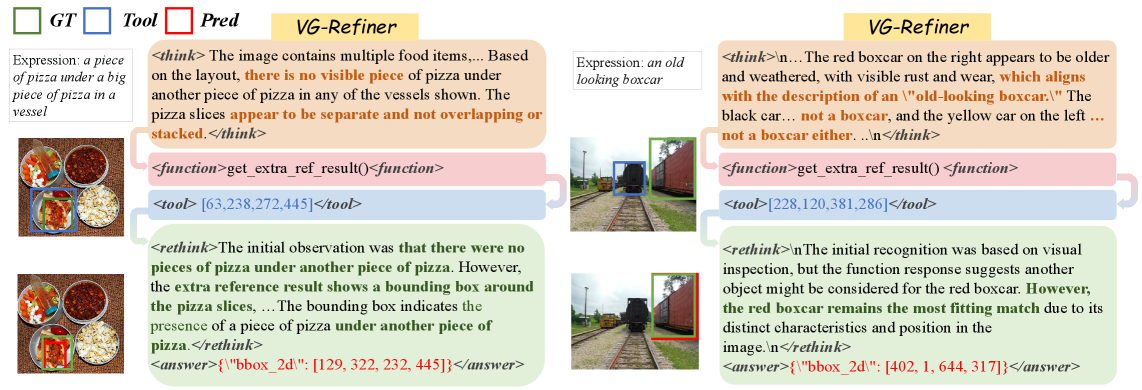

В статье представлена VG-Refiner — система, использующая обучение с подкреплением и специализированную систему вознаграждений для улучшения коррекции ошибок в задачах визуального рассуждения.

Несмотря на значительный прогресс в области визуального рассуждения с использованием инструментов, существующие подходы часто уязвимы к неточностям и ошибкам в работе этих инструментов. В данной работе, представленной под названием ‘VG-Refiner: Towards Tool-Refined Referring Grounded Reasoning via Agentic Reinforcement Learning’, предложен новый фреймворк VG-Refiner, использующий обучение с подкреплением и механизм корректировки, позволяющий моделям эффективно анализировать и исправлять ошибки, возникающие при работе с инструментами. Внедрение специализированной награды за уточнение позволяет значительно повысить точность и способность к самокоррекции в задачах, требующих сопоставления объектов и логических выводов. Сможем ли мы создать действительно надежные системы визуального рассуждения, способные не только решать сложные задачи, но и осознавать собственные ограничения?

Пределы Восприятия и Языковой Логики

Современные большие визуально-языковые модели (LVLM) демонстрируют впечатляющие способности в обработке изображений и текста, однако сталкиваются с трудностями при решении сложных задач, требующих глубокого понимания визуальной информации. Несмотря на кажущуюся ловкость в распознавании объектов и описании сцен, модели часто терпят неудачу, когда необходимо провести логический анализ, установить причинно-следственные связи или сделать выводы на основе неоднозначных или неполных данных. Их производительность существенно снижается в ситуациях, требующих не просто идентификации элементов, а интерпретации их взаимосвязей и контекста, что указывает на ограничение в способности к действительному «зрению» и пониманию, выходящему за рамки поверхностного анализа пикселей и текстовых шаблонов.

Современные методы, используемые в задачах, связанных с восприятием и языком, часто демонстрируют уязвимость при работе с неоднозначной или неполной информацией. Исследования показывают, что даже самые продвинутые модели испытывают трудности в ситуациях, когда для корректного вывода требуется интерпретация неявно выраженных данных или заполнение пробелов в представленной информации. Это приводит к неточностям в процессе обоснованного рассуждения, когда модель делает ошибочные выводы, основываясь на неполном или искаженном понимании окружающей среды. В таких случаях, способность модели к надежному и логичному рассуждению существенно снижается, подчеркивая необходимость разработки новых подходов, способных эффективно справляться с неопределенностью и неполнотой данных.

Несмотря на впечатляющий прогресс в области больших языковых моделей с визуальным входом, простое увеличение их размера не решает проблему надежности рассуждений. Исследования показывают, что достижение более глубокого понимания требует принципиально нового подхода к архитектуре и обучению. Увеличение количества параметров, хоть и улучшает способность модели к запоминанию и обобщению, не обеспечивает критического мышления и способности к корректному выводу при столкновении с неоднозначной или неполной информацией. Необходим переход к моделям, способным к активному моделированию мира, построению гипотез и проверке их на основе поступающих данных, что выходит за рамки простого сопоставления шаблонов и статистического анализа. Такой подход позволит преодолеть ограничения существующих систем и приблизиться к созданию искусственного интеллекта, способного к действительно надежным и осмысленным рассуждениям.

Усиление Восприятия Внешними Инструментами

Интегрированное визуальное рассуждение с использованием инструментов (TiVR) представляет собой перспективный подход, объединяющий большие визуальные языковые модели (LVLM) с внешними инструментами, такими как оценка глубины и обнаружение границ. Данная интеграция позволяет LVLM обрабатывать визуальную информацию более эффективно за счет делегирования задач перцептивной обработки специализированным алгоритмам. Например, модуль оценки глубины предоставляет информацию о трехмерной структуре сцены, а алгоритмы обнаружения границ выделяют ключевые контуры объектов, что позволяет LVLM сосредотачиваться на высокоуровневых процессах рассуждения и принятия решений, не тратя ресурсы на первичный анализ изображения.

В рамках подхода TiVR (Tool-Integrated Visual Reasoning) перенос задач перцептивного анализа на специализированные инструменты позволяет большим языковым моделям (LVLM) оптимизировать вычислительные ресурсы и сосредоточиться на задачах более высокого уровня, таких как логические умозаключения и принятие решений. Вместо непосредственной обработки визуальных данных, LVLM получают результаты работы специализированных инструментов — например, карты глубины или выделение контуров — что снижает сложность анализа и повышает эффективность решения задач, требующих комплексного визуального понимания. Это позволяет модели абстрагироваться от низкоуровневых деталей и сосредоточиться на интерпретации полученной информации и формулировании ответов.

Обучение агентов, использующих внешние инструменты, с применением обучения с подкреплением (Reinforcement Learning) позволяет значительно снизить потребность в дорогостоящей ручной разметке данных. Традиционные методы обучения моделей компьютерного зрения часто требуют больших объемов размеченных данных, что является трудоемким и ресурсозатратным процессом. Обучение с подкреплением, напротив, позволяет агенту учиться путем взаимодействия со средой и получения вознаграждения за правильные действия, минимизируя необходимость в предварительно размеченных примерах. В контексте Tool-Integrated Visual Reasoning (TiVR), агент может обучаться использованию инструментов, таких как оценка глубины или обнаружение границ, для решения задач, получая вознаграждение за успешное выполнение этих задач. Этот подход не только снижает затраты на разметку, но и позволяет агенту адаптироваться к новым ситуациям и задачам без необходимости повторной ручной разметки данных.

Переосмысление и Уточнение Выходных Данных Инструментов

В рамках фреймворка VG-Refiner реализован процесс “обдумывания-переосмысления” (think-rethink), предназначенный для повышения надежности работы с инструментами. Этот процесс заключается в том, что большая языковая модель с визуальным входом (LVLM) не просто выдает результат работы инструмента, но и повторно оценивает его, выявляя и корректируя потенциальные ошибки в выходных данных. Повторная оценка позволяет модели самостоятельно верифицировать правильность результатов, полученных от инструментов, и вносить необходимые исправления, что способствует более обоснованному и точному решению задач.

В рамках VG-Refiner используется механизм «Refinement Reward», представляющий собой сигнал вознаграждения, направленный на стимулирование модели к выявлению и исправлению неточных предсказаний, сделанных инструментами. Этот механизм позволяет модели самостоятельно переоценивать результаты работы инструментов и вносить коррективы, что приводит к улучшению обоснованности рассуждений и повышению точности ответов. Вознаграждение формируется на основе оценки корректности предсказаний и служит для обучения модели более критически относиться к результатам работы инструментов и стремиться к более надежным и обоснованным выводам.

Оценка с использованием протокола PiTER продемонстрировала передовую точность VG-Refiner в задачах понимания отсылающих выражений, значительно превосходящую показатели модели Qwen2.5-VL-32B. В условиях слабой работы инструментов, VG-Refiner обеспечивает существенно более высокие значения Normalized Signed Relative IoU (NSRIw) и Critical Correct Rate (CCR) по сравнению с моделями масштаба 32B и 7B, что подтверждает эффективность предложенного подхода к уточнению выходных данных инструментов и повышению точности обоснованного рассуждения.

К Более Надежному и Достоверному Рассуждению

В рамках развития систем визуального мышления, основанных на использовании внешних инструментов, платформа VG-Refiner представляет собой заметный шаг вперед. В отличие от традиционных подходов, которые часто предполагают безоговорочную достоверность получаемых от инструментов данных, VG-Refiner явно учитывает возможность их неточности. Этот подход позволяет модели критически оценивать информацию, полученную из внешних источников, и корректировать свои выводы в случае обнаружения противоречий или ошибок. Такое сознательное отношение к потенциальной ненадежности инструментов способствует повышению общей надежности и точности системы, позволяя ей более эффективно решать сложные задачи визуального рассуждения и избегать распространения неверных данных. В результате, VG-Refiner демонстрирует повышенную устойчивость к ошибкам и более надежные результаты в различных сценариях.

В рамках разработки VG-Refiner ключевую роль играет система вознаграждений, направленная на повышение надежности визуального мышления с использованием внешних инструментов. Модель обучается, получая положительные сигналы — Tool-Confirmation Rewards — за подтверждение корректности результатов, предоставляемых инструментами, и Tool-Refinement Rewards — за успешную коррекцию ошибок. Такой подход позволяет системе не только доверять надежным ответам, но и эффективно исправлять неточности, возникающие в процессе взаимодействия с внешними ресурсами. В результате, модель демонстрирует способность к самокоррекции и улучшению качества принимаемых решений, что особенно важно при работе со сложными визуальными задачами и потенциально ненадежными инструментами.

Исследования, проведенные с использованием EVF-SAM и Grounding DINO T, продемонстрировали гибкость и эффективность разработанной системы VG-Refiner в различных ситуациях. В частности, отмечено, что VG-Refiner превосходит базовые модели по показателю Follow Correct Rate (FCR), отражающему способность сохранять верные прогнозы, и одновременно демонстрирует более низкий Worsen Rate (WR) — то есть, снижает вероятность ухудшения результатов, полученных от внешних инструментов. Такие результаты указывают на повышенную надежность системы в поддержании корректности и предотвращении ошибок при взаимодействии с инструментами, что делает ее перспективным решением для задач визуального рассуждения, требующих высокой точности и стабильности.

Представленная работа демонстрирует стремление к созданию алгоритмов, обладающих не просто функциональностью, но и математической точностью. VG-Refiner, используя подход агентного обучения с подкреплением и механизм уточняющего вознаграждения, стремится к коррекции ошибок, возникающих при использовании инструментов в задачах визуального рассуждения. Этот подход особенно важен, поскольку, как отмечает Эндрю Ын: «Мы должны стремиться к созданию систем, которые не просто дают ответы, но и могут объяснить, как они к ним пришли.». Акцент на корректировке ошибок и обеспечении надёжности вывода соответствует принципу доказательной корректности алгоритма, а не просто его работоспособности на тестовом наборе данных. Устойчивость к ненадёжным инструментам — ключевой аспект масштабируемости и долгосрочной эффективности.

Куда Далее?

Представленная работа, несомненно, демонстрирует прогресс в обучении больших визуально-языковых моделей коррекции ошибок, возникающих при использовании внешних инструментов. Однако, необходимо помнить, что «оптимизация без анализа» — это самообман и ловушка для неосторожного разработчика. Вопрос не в том, чтобы просто заставить модель «исправлять» ошибки, а в том, чтобы понимать природу этих ошибок и строить алгоритмы, способные их предвидеть и избегать. Акцент на «усилении» (refinement) — это лишь частное решение общей проблемы надежности и верификации алгоритмов.

Дальнейшие исследования должны быть направлены на разработку формальных методов оценки надежности выходных данных инструментов, а не только на обучение моделей «маскировать» их недостатки. Интересным направлением представляется исследование возможности интеграции формальной логики и вероятностных моделей для построения более устойчивых систем визуального рассуждения. Необходимо также учитывать, что предложенный подход, вероятно, чувствителен к качеству данных обучения и требует тщательной валидации в различных условиях.

В конечном счете, истинная элегантность заключается не в сложности архитектуры, а в математической чистоте алгоритма. Задача состоит не в том, чтобы построить модель, которая «выглядит» разумно, а в том, чтобы доказать ее корректность. Пока же, следует признать, что достигнутый прогресс — это лишь первый шаг на пути к созданию действительно надежных систем искусственного интеллекта.

Оригинал статьи: https://arxiv.org/pdf/2512.06373.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовый скачок: от лаборатории к рынку

- Квантовые нейросети на службе нефтегазовых месторождений

- Функциональные поля и модули Дринфельда: новый взгляд на арифметику

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2025-12-09 13:15