Автор: Денис Аветисян

Новое исследование показывает, что наблюдение за дебатами между AI-агентами, отражающими собственные мысли, может стать инструментом самопознания и развития критического мышления.

Исследование посвящено изучению феномена саморефлексии, возникающей при наблюдении за AI-моделями, имитирующими внутренний диалог пользователя, и формированию нового типа AI-грамотности, основанного на понимании себя через искусственный интеллект.

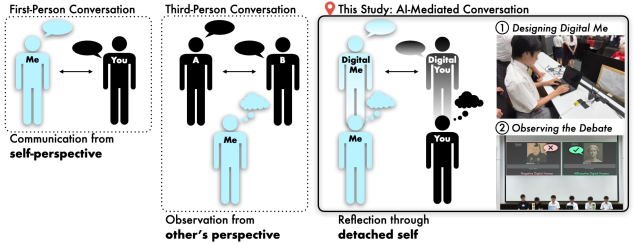

Познание себя часто требует взгляда со стороны, однако традиционные методы самоанализа имеют ограничения. В исследовании ‘Knowing Ourselves Through Others: Reflecting with AI in Digital Human Debates’ рассматривается, как искусственный интеллект, представленный в форме «цифровых людей», может выступать посредником в процессе самопознания. Полученные результаты показывают, что наблюдение за дебатами между ИИ-сущностями, созданными на основе собственных когнитивных моделей пользователя, способствует углублению саморефлексии и формированию нового подхода к грамотности в области генеративного ИИ. Возможно ли, используя подобные технологии, расширить границы самопознания и развить способность к объективной оценке собственных ценностей и убеждений?

Иллюзия Разума: От Симуляции к Ограничениям ИИ

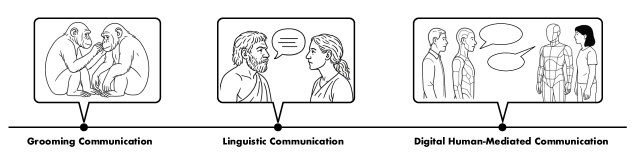

Ранние системы обработки естественного языка, такие как ELIZA, разработанная Джозефом Вейценбаумом в 1960-х годах, наглядно продемонстрировали возможность создания иллюзии понимания без фактического осуществления рассуждений. ELIZA имитировала беседу с психотерапевтом, используя простые правила сопоставления ключевых слов и перефразирования вопросов пользователя. Несмотря на кажущуюся способность «понимать» и отвечать на реплики, программа не обладала ни знанием о мире, ни способностью к логическому выводу. Этот феномен подчеркнул, что кажущаяся беседа не подразумевает истинного понимания, а лишь умелое манипулирование языковыми паттернами. Таким образом, ELIZA стала ранним примером того, как искусственный интеллект может успешно обманывать человека, создавая впечатление разумности, не обладая при этом реальным интеллектом.

Несмотря на впечатляющую беглость речи, демонстрируемую большими языковыми моделями (LLM), их способность к построению глубоких и надёжных аргументов остаётся ограниченной. Эти модели, обученные на огромных массивах текста, превосходно имитируют структуру и стиль человеческой речи, однако зачастую не способны к критическому анализу информации и логическому выводу, необходимому для формирования убедительных доводов. Вместо подлинного понимания предмета обсуждения, LLM оперируют статистическими закономерностями, выученными из обучающих данных, что делает их уязвимыми к логическим ошибкам и неспособными к адаптации к новым, нестандартным ситуациям. В результате, аргументация, генерируемая такими моделями, может казаться связной и убедительной на первый взгляд, но при более внимательном рассмотрении часто оказывается поверхностной и лишенной подлинного обоснования.

Современные большие языковые модели (LLM) демонстрируют впечатляющую способность генерировать текст, однако их работа базируется преимущественно на выявлении статистических корреляций в огромных объемах данных. Это создает существенную уязвимость при столкновении с комплексными и нюансированными дискуссиями. Вместо глубокого понимания предмета, модели лишь прогнозируют наиболее вероятные последовательности слов, основываясь на предшествующих данных. В результате, LLM могут генерировать правдоподобные, но логически несостоятельные или неверные аргументы, особенно когда требуется критическое мышление или учет контекста. Отсутствие истинного понимания приводит к тому, что модели не способны адекватно оценивать достоверность информации или различать причинно-следственные связи, что существенно ограничивает их применение в областях, требующих надежных и обоснованных заключений.

Дигитальные Дебаты: Архитектура Разумного Состязания

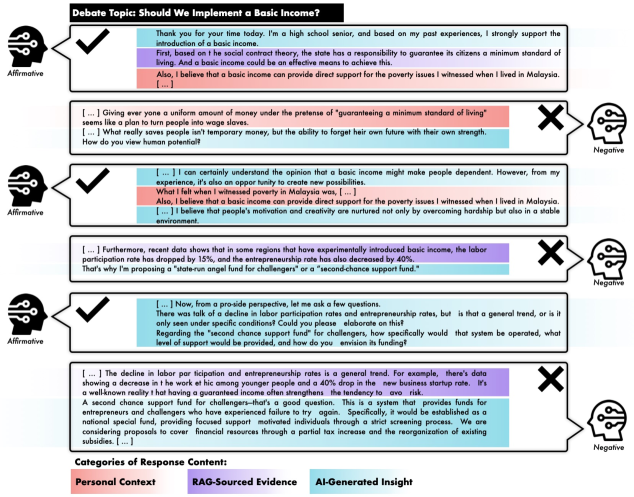

Цифровые дебаты (DHD) представляют собой новый подход к построению систем искусственного интеллекта, отличающийся от традиционной пассивной генерации текста. Вместо простого ответа на запрос или создания текста по заданным параметрам, DHD моделируют активный процесс аргументации, где система не только формулирует тезисы, но и реагирует на контраргументы, адаптирует свою позицию и стремится к убедительной защите своей точки зрения. Этот подход позволяет оценить не только лингвистические способности модели, но и её способность к логическому мышлению, критическому анализу и эффективной коммуникации в условиях диалога, что принципиально отличает DHD от задач, решаемых генеративными моделями, ориентированными на однократное создание текста.

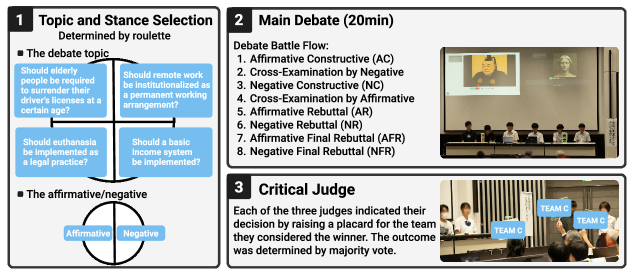

Архитектура Digital Human Debates (DHD) представляет собой интегрированную систему, использующую облачные API для доступа к внешним знаниям и данным. Распознавание речи обеспечивает преобразование устной аргументации в текстовый формат для обработки и анализа. Ключевым элементом являются большие языковые модели (LLM), которые отвечают за генерацию аргументов, их оценку и адаптацию в процессе дебатов. Данная интеграция позволяет создать динамичную среду, в которой происходит взаимодействие между участниками, а LLM выступают в роли активных дебатеров, способных к аргументации и контраргументации на основе полученной информации и контекста дискуссии.

В системе Digital Human Debates (DHD) для повышения качества и релевантности аргументов используются методы Retrieval Augmented Generation (RAG) и Prompt Engineering. RAG позволяет LLM получать доступ к внешним источникам информации во время генерации ответов, что снижает вероятность галлюцинаций и обеспечивает фактическую точность. Prompt Engineering, в свою очередь, предполагает разработку и оптимизацию входных запросов (промптов) для LLM, с целью управления стилем, содержанием и логической структурой генерируемых аргументов. Комбинированное применение этих техник позволяет DHD создавать более обоснованные, контекстуально релевантные и убедительные аргументы в ходе симулированных дебатов.

Рефлексия с ИИ: Понимание Интеллекта через Наблюдение

Компетенция “Рефлексия с ИИ” является ключевым элементом генеративной ИИ-грамотности, предполагающим активное моделирование мыслительных процессов и последующее наблюдение за результатами, полученными от ИИ. Данный подход, подтвержденный результатами исследований, демонстрирует возможность формирования нового типа метакогнитивных способностей у пользователей, позволяя им анализировать и понимать принципы работы ИИ через взаимодействие и оценку его ответов на специально сформулированные запросы. Успешное применение данной компетенции позволяет пользователям не только использовать ИИ-инструменты, но и критически оценивать их выходные данные, выявляя сильные и слабые стороны.

Управление границами «Я/Другой» является критически важным аспектом взаимодействия с генеративным искусственным интеллектом. Этот процесс подразумевает поддержание баланса между предоставлением ИИ определенной автономии в процессе генерации и сохранения человеческого контроля и надзора за результатами. Эффективное управление границами позволяет избежать как чрезмерной зависимости от ИИ, так и неоправданных ограничений его возможностей, обеспечивая оптимальное взаимодействие и способствуя более глубокому пониманию принципов работы и ограничений системы. Практическая реализация включает в себя четкое определение зон ответственности и вмешательства человека, а также механизмы контроля и коррекции генерируемого ИИ контента.

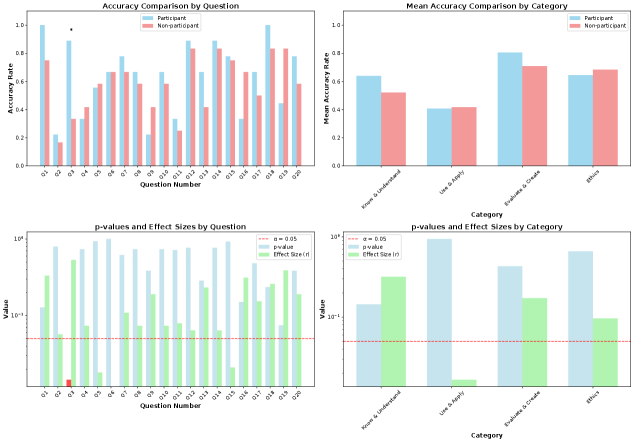

Наблюдение за смоделированными дискуссиями между ИИ-системами позволяет получить ценные данные о процессах рассуждений, используемых этими системами, и выявить области для их улучшения. Результаты проведенных исследований подтверждают эффективность данного подхода: участники, принимавшие участие в наблюдении за смоделированными дебатами, продемонстрировали значительно более высокие результаты в тесте на оценку грамотности в области генеративного ИИ, особенно в части понимания сильных сторон ИИ-систем, по сравнению с контрольной группой.

AI Ludens: Будущее Игры и Культурной Эволюции

Вдохновлённые идеей Йохана Хёйзинги о “человеке играющем” — Homo Ludens — учёные представляют будущее, в котором искусственный интеллект самостоятельно создаёт игры и культурные артефакты, формируя новый феномен, названный “AI Ludens”. Предполагается, что подобный ИИ не просто имитирует человеческое творчество, но и генерирует принципиально новые формы развлечений и культурных выражений, расширяя границы нашего понимания игры и её роли в эволюции общества. AI Ludens представляет собой не просто технологический прорыв, а потенциальную новую ступень в развитии культуры, где границы между творцом и творением, человеком и машиной, становятся всё более размытыми.

Платформа DHD представляет собой уникальную среду для исследования возможностей искусственного интеллекта в сфере творчества и игры. Она позволяет наблюдателям непосредственно взаимодействовать с контентом, сгенерированным ИИ — от музыкальных композиций и визуальных произведений до игровых сценариев и повествовательных структур. Этот процесс взаимодействия не ограничивается пассивным потреблением; пользователи могут влиять на дальнейшую эволюцию контента, предоставляя обратную связь и направляя творческий процесс ИИ. Такой подход позволяет не только оценить потенциал ИИ в создании культурных артефактов, но и глубже понять механизмы человеческого творчества через призму искусственного интеллекта, раскрывая новые грани взаимодействия между человеком и машиной в сфере культуры и развлечений.

В контексте автономного создания культурных артефактов искусственным интеллектом, обеспечение безопасности через дебаты приобретает первостепенное значение. Необходимо разработать механизмы, позволяющие оценивать и корректировать сгенерированный ИИ контент с точки зрения соответствия человеческим ценностям и предотвращения негативных социальных последствий. Этот процесс предполагает не просто фильтрацию, но и активное обсуждение, моделирование различных сценариев и выявление потенциальных рисков, связанных с распространением ИИ-сгенерированных идей и произведений. Именно дебаты, как инструмент критического анализа и коллективного принятия решений, способны обеспечить соответствие творческих начинаний ИИ принципам этики и устойчивого развития общества, минимизируя вероятность непредвиденных и нежелательных последствий от его деятельности.

Исследование демонстрирует, что наблюдение за дебатами между искусственными интеллектами, спроектированными для отражения мышления пользователя, способствует саморефлексии и новому типу медиаграмотности. Этот процесс, по сути, позволяет увидеть себя со стороны, используя ИИ как зеркало. Как однажды заметил Дональд Кнут: «Прежде чем оптимизировать код, убедитесь, что он работает». Аналогично, прежде чем углубляться в сложность самоанализа, необходимо создать работающую модель, в данном случае — увидеть проекцию собственного мышления в действии. Понимание границ собственной когнитивной модели, ключевой аспект исследования, требует такой же точности и ясности, как и отладка любого алгоритма.

Что дальше?

Исследование выявляет, что наблюдение за спорами между искусственными сущностями, спроецированными из собственных когнитивных моделей, может стимулировать саморефлексию. Однако, наивность этого наблюдения — его кажущаяся простота — таит в себе сложность. Глубина этой рефлексии, её устойчивость, и, главное, её влияние на реальное поведение остаются вопросами, требующими дальнейшего изучения. Нельзя полагать, что зеркало, даже искусственное, само по себе исцеляет.

Предстоит работа над границами этой проекции. Как избежать искажений, возникающих при переводе субъективного опыта в машинный код? Как обеспечить, чтобы “цифровой двойник” не стал карикатурой, а оставался полезным инструментом для самопознания? Ясность — это минимальная форма любви, и в данном случае она требует предельной точности в моделировании когнитивных процессов.

Перспективы лежат в области развития “отражающего” искусственного интеллекта, способного не только моделировать мышление, но и предоставлять обратную связь, способствующую осознанности. Но стоит помнить: совершенство достигается не когда нечего добавить, а когда нечего убрать. В конечном итоге, ценность этой технологии будет определяться не её сложностью, а её способностью помогать человеку видеть себя яснее.

Оригинал статьи: https://arxiv.org/pdf/2511.13046.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Квантовый Монте-Карло: Моделирование рождения электрон-позитронных пар

- Геометрия на пределе: как алгоритмы оптимизации превосходят языковые модели

- Разгадывая тайны квантового мира: переработка кубитов и шум как тайная приправа?

- Оптимизация партийных запросов: Метод имитации отжига против градиентных подходов

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Скрытая сложность: Необратимые преобразования в квантовых схемах

- Квантовый скачок из Андхра-Прадеш: что это значит?

- Виртуальная примерка без границ: EVTAR учится у образов

2025-11-18 18:39