Автор: Денис Аветисян

Новое исследование показывает, что простые алгоритмы искусственного интеллекта способны эффективно адаптировать инструменты для анализа медицинских изображений к новым данным, зачастую превосходя решения, разработанные специалистами.

Автоматизированный поиск программных конфигураций с использованием агентного ИИ для оптимизации рабочих процессов биомедицинской визуализации в условиях ограниченных данных.

Адаптация готовых инструментов компьютерного зрения к специализированным научным данным часто является узким местом в исследовательском процессе. В работе «Simple Agents Outperform Experts in Biomedical Imaging Workflow Optimization» рассматривается возможность автоматизации этой рутинной задачи с помощью AI-агентов. Показано, что простая архитектура агента последовательно генерирует код, превосходящий решения, разработанные экспертами, в оптимизации конвейеров обработки биомедицинских изображений. Открывает ли это путь к созданию автоматизированных систем, способных ускорить научные открытия в условиях ограниченных размеченных данных?

Фундамент Точного Анализа: Подготовка Изображений — Ключ к Успеху

Анализ биомедицинских изображений часто сталкивается с трудностями, вызванными присущими им шумами и недостаточной контрастностью, которые могут скрывать важные детали. Эти факторы, возникающие из-за ограничений используемого оборудования, особенностей биологических тканей и методов получения изображений, существенно затрудняют точную интерпретацию и количественную оценку. Низкая контрастность делает трудноразличимыми структуры, а шумы маскируют слабые сигналы, что приводит к неточностям в диагностике и исследованиях. Преодоление этих проблем является критически важным этапом для получения достоверных результатов, поскольку даже незначительные артефакты могут привести к ошибочным выводам и повлиять на принятие клинических решений.

Эффективная предварительная обработка изображений является первостепенным и критически важным этапом в любом точном анализе биомедицинских данных. Недостаточная подготовка изображений может привести к искажению результатов и неверной интерпретации, вне зависимости от сложности используемых алгоритмов. По сути, этот начальный этап закладывает фундамент для всей последующей работы, обеспечивая оптимальное качество входных данных для автоматизированных систем анализа. Поэтому, коррекция артефактов, усиление контраста и устранение шумов — это не просто технические процедуры, а неотъемлемая часть научной достоверности и надежности получаемых выводов. Без тщательно выполненной предварительной обработки даже самые передовые методы машинного обучения и искусственного интеллекта могут дать неточные или вводящие в заблуждение результаты.

Для обеспечения точности и надёжности анализа биомедицинских изображений, часто применяются методы коррекции геометрических искажений и сглаживания. Гауссовское размытие, в частности, эффективно снижает уровень шума, сохраняя при этом общую структуру изображения. Параллельно, аффинные преобразования позволяют корректировать перспективные искажения и выравнивать изображения, возникшие в процессе получения данных. Эти методы не просто улучшают визуальное восприятие, но и готовят изображения к последующим этапам анализа, таким как сегментация, измерение и классификация, обеспечивая более точные и воспроизводимые результаты. Использование этих техник позволяет максимально извлечь полезную информацию из исходных данных, минимизируя влияние артефактов и погрешностей.

Метод нелокального усреднения шума играет ключевую роль в сохранении мелких деталей изображений, особенно в микроскопии. В отличие от традиционных методов, которые усредняют значения пикселей в локальной окрестности, нелокальное усреднение учитывает все пиксели изображения, находя те, которые наиболее похожи на обрабатываемый. Это позволяет эффективно подавлять шум, не размывая важные структуры и границы объектов. Применение данного метода особенно ценно при анализе биологических образцов, где сохранение тонких деталей клеточных структур или тканей критически важно для точной диагностики и исследований. В результате, применение нелокального усреднения шума значительно повышает качество изображений и обеспечивает более надежные результаты анализа.

Определение Границ: Искусство Сегментации Изображений

Сегментация изображения представляет собой процесс разделения цифрового изображения на отдельные, значимые области. Этот процесс позволяет не только визуально выделить объекты на изображении, но и количественно оценить их характеристики, такие как площадь, периметр, интенсивность и другие метрики. Полученные сегменты могут использоваться для последующего анализа, например, для подсчета объектов, измерения их размеров или для выделения областей интереса для дальнейшей обработки. Точность сегментации напрямую влияет на достоверность результатов количественного анализа, поэтому разработка и применение эффективных алгоритмов сегментации является ключевой задачей в области компьютерного зрения и обработки изображений.

Алгоритмы, такие как алгоритм водоразделов (Watershed) и обнаружение контуров, обеспечивают базовый функционал для разделения объектов на изображении, однако их эффективное применение требует тщательной настройки параметров. Алгоритм водоразделов, например, чувствителен к шумам и требует предварительной обработки для определения маркеров и границ, в то время как обнаружение контуров требует определения подходящего порога и фильтрации шумов для точного выделения границ объектов. Неправильная настройка параметров может привести к фрагментации объектов, неполному разделению или ложному выделению границ, что снижает точность и надежность сегментации. Оптимальные значения параметров часто зависят от конкретного изображения и требуют эмпирического подбора или использования адаптивных методов.

Адаптивная пороговая обработка (Adaptive Thresholding) представляет собой автоматизированный метод определения оптимальных границ сегментации на изображениях. В отличие от глобальной пороговой обработки, использующей одно значение порога для всего изображения, адаптивные алгоритмы вычисляют порог для каждого пикселя на основе локального окружения. Это позволяет эффективно обрабатывать изображения с неравномерным освещением или сложным фоном, где применение единого порога приводит к неточным результатам. Различные реализации, такие как метод Ниблека или метод Саувалы, используют различные способы вычисления локального порога, учитывая среднее значение яркости и стандартное отклонение в окрестности пикселя. Автоматизация процесса выбора порога значительно повышает надежность и устойчивость алгоритмов сегментации, снижая необходимость ручной настройки параметров для каждого изображения.

Современные конвейеры сегментации изображений, такие как Cellpose и MedSAM, демонстрируют эффективность интегрированных подходов в биомедицинских задачах. Эти системы, объединяющие несколько алгоритмов и этапов обработки, позволяют достигать стабильно высоких показателей F1-меры (обычно выше 0.8) при анализе изображений различных типов и в разных условиях. В частности, Cellpose использует подход, основанный на прогнозировании полей смещения, а MedSAM — на предварительно обученных моделях, что обеспечивает высокую точность и надежность сегментации клеточных структур и тканей. Сравнение различных конвейеров показывает, что интегрированные подходы превосходят по производительности отдельные алгоритмы, особенно при анализе сложных изображений с низким контрастом или значительным шумом.

Извлечение Сути: Признаки и Их Валидация

Извлечение признаков (Feature Extraction) представляет собой процесс преобразования исходных данных изображения в набор количественно измеримых характеристик. Эти характеристики, такие как текстура, форма, цвет или градиенты, позволяют проводить объективный анализ изображения, исключая субъективные оценки. Вместо работы непосредственно с пикселями, алгоритмы оперируют с этими числовыми представлениями, что упрощает задачу классификации, сегментации или обнаружения объектов. Полученные признаки могут быть использованы для обучения моделей машинного обучения, позволяя автоматизировать процессы анализа изображений и получать воспроизводимые результаты.

Индекс структурного сходства (SSIM) представляет собой метрику, предназначенную для оценки воспринимаемого изменения структурного качества изображения. В отличие от простых метрик, таких как среднеквадратичная ошибка (MSE), SSIM учитывает изменения в яркости, контрастности и структуре изображения, что позволяет более точно оценивать его сходство с эталонным изображением. Метрика SSIM вычисляется на основе трех основных компонентов: яркости, контрастности и структуры, с использованием формулы, включающей среднее арифметическое, стандартное отклонение и ковариацию локальных шаблонов изображения. Значение SSIM варьируется от -1 до 1, где 1 указывает на полное сходство, 0 — на полное отсутствие сходства, а отрицательные значения указывают на значительные различия. SSIM широко используется в задачах валидации и контроля качества изображений, включая оценку эффективности алгоритмов обработки изображений и сжатия данных, а также в медицинском анализе изображений для оценки точности сегментации и обнаружения аномалий.

Предварительная обработка изображений с использованием методов, таких как двусторонний фильтр (Bilateral Filter) и выравнивание гистограммы (Histogram Equalization), оказывает непосредственное влияние на качество извлекаемых признаков. Двусторонний фильтр эффективно сглаживает изображения, сохраняя при этом важные детали и границы, что повышает точность последующего анализа. Выравнивание гистограммы улучшает контрастность изображения, делая признаки более различимыми и облегчая их обнаружение. Неправильный выбор параметров или комбинация этих методов может привести к потере информации или внесению артефактов, что негативно скажется на производительности алгоритмов обработки изображений и точности извлеченных признаков.

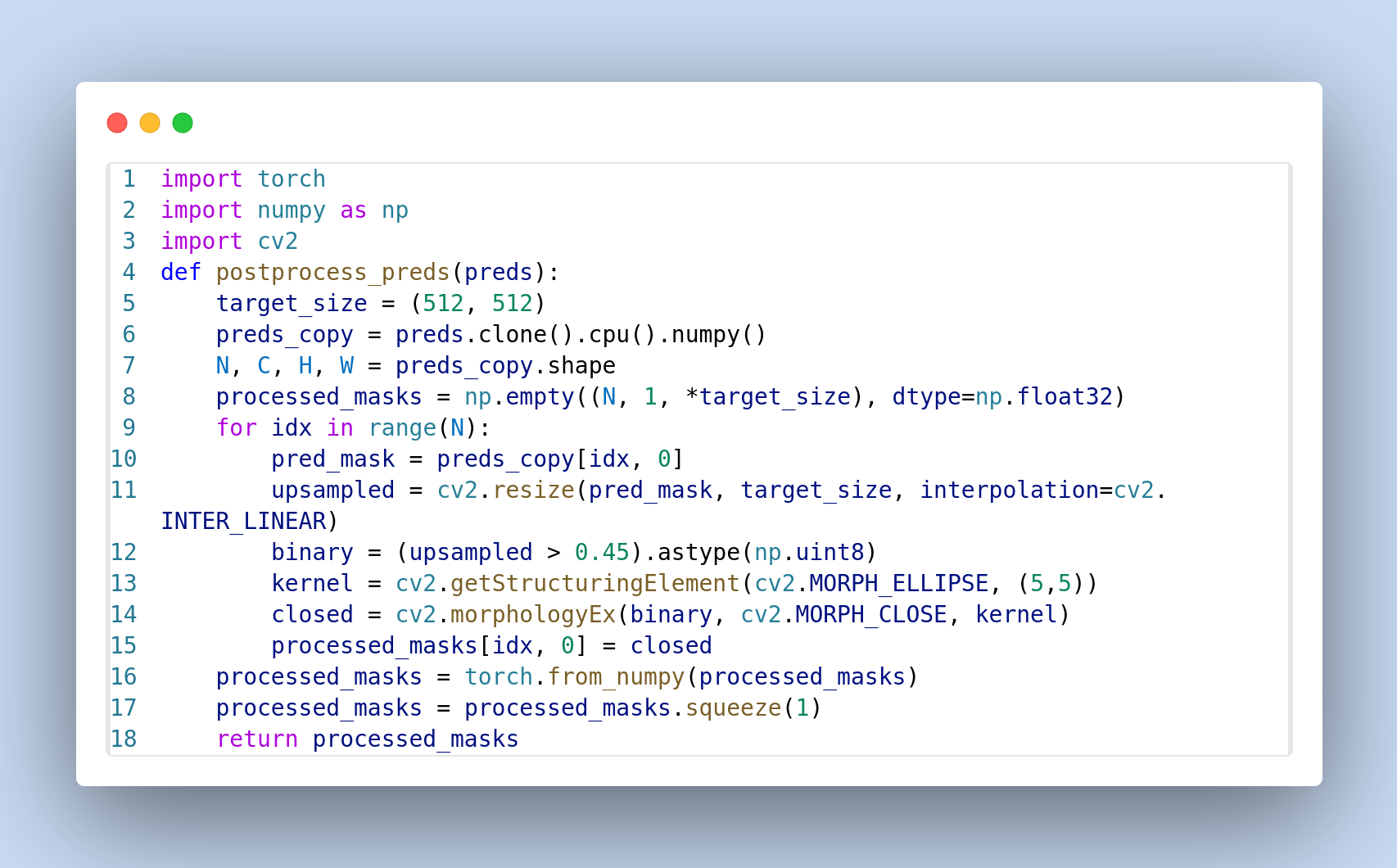

Автоматизированные конвейеры, такие как Polaris, используют комбинацию предварительной обработки изображений и сегментации для эффективного извлечения значимых данных из биомедицинских изображений. Результаты показывают, что такие конвейеры демонстрируют превосходство над решениями, разработанными экспертами, по показателю F1 Score в различных пайплайнах, включая Polaris, Cellpose и MedSAM. Данный подход обеспечивает повышение производительности и сокращает время адаптации до 1-2 дней, в то время как ручная настройка экспертами обычно занимает недели или месяцы.

Автоматизированный подход к извлечению признаков и валидации данных демонстрирует существенное повышение производительности по сравнению с традиционными методами, требующими ручной настройки экспертами. В то время как адаптация и оптимизация вручную могут занимать недели или даже месяцы, предложенная система позволяет достичь необходимой точности всего за 1-2 дня. Это значительное сокращение времени адаптации обусловлено использованием автоматизированных алгоритмов и предобученных моделей, что позволяет быстро приспособить систему к новым типам изображений и задачам анализа, минимизируя необходимость в длительной ручной калибровке и экспертизе.

Исследование демонстрирует, что даже простейшие агентные системы, способные к адаптации существующих инструментов, способны превзойти решения, разработанные экспертами в области обработки научных изображений. Этот подход особенно ценен в условиях ограниченного объема данных, что позволяет ускорить процесс научных открытий. Как заметил Эндрю Ын: «Мы должны стремиться к созданию систем, которые не просто работают, а могут объяснять свои решения и адаптироваться к новым условиям». Данное исследование подтверждает эту мысль, показывая, что элегантность и эффективность алгоритма заключаются не в его сложности, а в математической чистоте и способности к доказательному выводу, что напрямую соотносится с оптимизацией рабочих процессов в биомедицинской визуализации.

Что Дальше?

Представленная работа, демонстрируя превосходство простых агентов над экспертными решениями в оптимизации рабочих процессов биомедицинской визуализации, поднимает вопрос о природе самой оптимизации. Если алгоритм, лишенный интуиции и опыта, способен превзойти человека, то что является истинным мерилом «экспертности»? Не является ли она лишь набором эвристик, которые, будучи формализованными, неизбежно уступают место строгому математическому анализу?

Очевидным направлением дальнейших исследований является расширение сферы применения данного подхода. Ограниченность данных, подчеркнутая в работе, остается серьезной проблемой. Необходимо исследовать методы, позволяющие агентам эффективно обобщать знания, полученные на ограниченном наборе данных, и адаптироваться к новым, ранее не встречавшимся условиям. Вопрос воспроизводимости результатов также требует особого внимания. Если результат нельзя надежно воспроизвести, он, по сути, неверифицирован.

Наконец, стоит задуматься о фундаментальной природе «агента». Достаточно ли простого перебора параметров, или же для достижения истинного научного прогресса требуется нечто большее — способность к формулированию гипотез, к обнаружению скрытых закономерностей, к созданию новых, элегантных моделей? Возможно, истинный прорыв в автоматизированном научном открытии потребует не простого «агента», а некоего цифрового воплощения научной интуиции — задачи, решение которой пока представляется весьма отдаленным.

Оригинал статьи: https://arxiv.org/pdf/2512.06006.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Квантовый скачок: от лаборатории к рынку

- Квантовые нейросети на службе нефтегазовых месторождений

- Функциональные поля и модули Дринфельда: новый взгляд на арифметику

- Интеллектуальная маршрутизация в коллаборации языковых моделей

2025-12-09 13:20