Геометрия весов: Новый взгляд на метрики Данкла

В статье представлена вариационная характеризация метрик Данкла, позволяющая по-новому взглянуть на их свойства и условия существования.

В статье представлена вариационная характеризация метрик Данкла, позволяющая по-новому взглянуть на их свойства и условия существования.

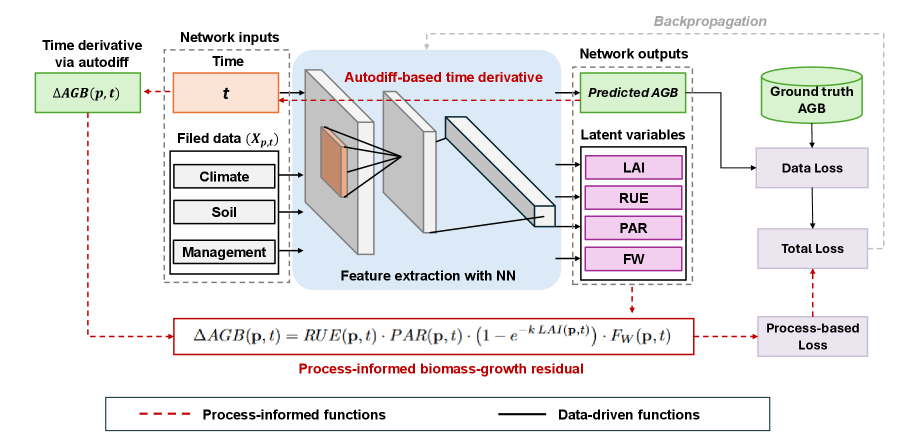

Новый подход к прогнозированию биомассы сельскохозяйственных культур позволяет повысить точность и эффективность оценки влияния засухи.

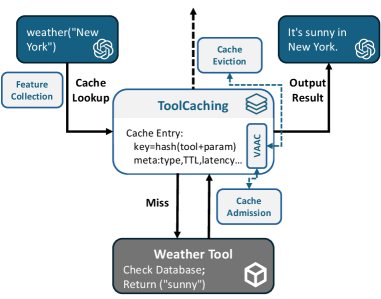

Новая система кэширования ToolCaching значительно ускоряет работу языковых моделей, использующих внешние инструменты, за счет адаптивной стратегии и учета семантических особенностей.

![В рамках предложенной структуры Fission-GRPO, оптимизация стратегии [latex]\pi_{\theta}[/latex] осуществляется в три этапа: первоначальным исследованием распределения запросов [latex]\mathcal{D}[/latex] с использованием GRPO, последующей идентификацией ошибок и их синтезом посредством симулятора [latex]\mathcal{S}_{\phi}[/latex] для отфильтрованных траекторий, и, наконец, обновлением на основе деления, где корректирующие выборки инициируют мультипликативный процесс пересемплирования (фактор [latex]G^{\prime}[/latex]) для согласования стратегии с путями восстановления.](https://arxiv.org/html/2601.15625v1/x2.png)

Новая методика позволяет языковым моделям быстрее восстанавливаться после ошибок при выполнении задач, используя их как ценные уроки.

![При увеличении параметра α, нижняя и верхняя границы приближаются к максимальной вероятности [latex] p^* [/latex], а максимальная вероятность отказа стремится к δ, что демонстрирует взаимосвязь между точностью оценки и уровнем риска.](https://arxiv.org/html/2601.16083v1/x1.png)

В новой работе предложен эффективный подход к решению задач максимального апостериорного правдоподобия (MAP), сочетающий вероятностные схемы и методы, гарантирующие точность результата.

![Процесс анализа устных высказываний осуществляется посредством двухэтапной системы кодирования - открытого и осевого - где на первом этапе [latex]20[/latex] тысяч транскрипций обрабатываются ансамблем языковых моделей, настроенных с использованием LoRA и модерируемых, а затем, посредством прямого запроса к языковой модели или кластеризации векторных представлений с последующей маркировкой, группируются в категории, при этом оценка качества осуществляется как посредством сопоставления с экспертными оценками, так и метриками внутренней интерпретируемости, такими как охват, краткость, связность, новизна и расхождение.](https://arxiv.org/html/2601.15338v1/x1.png)

Новый подход позволяет автоматически выявлять ключевые темы и смыслы в больших объемах текста, открывая возможности для глубокого анализа политического дискурса.

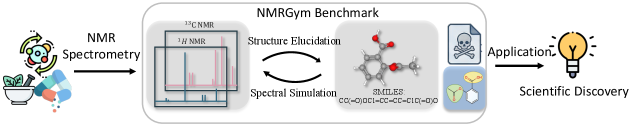

Новый масштабный набор данных и эталонный тест NMRGym призван ускорить разработку алгоритмов машинного обучения для точного определения молекулярной структуры по данным ЯМР-спектроскопии.

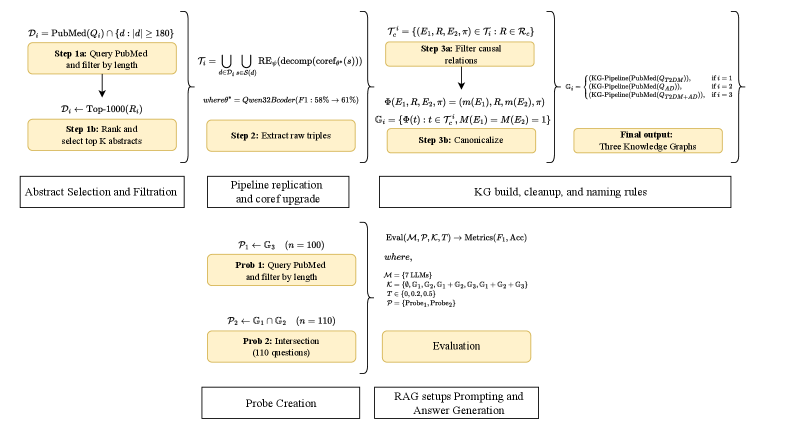

Новое исследование показывает, что использование специализированных баз знаний позволяет значительно повысить точность и релевантность ответов больших языковых моделей в сфере здравоохранения.

Исследование показывает, что формулы дизъюнктивной нормальной формы (ДНФ) могут быть проверены на истинность с допустимой относительной погрешностью, открывая новые возможности для оптимизации алгоритмов.

Новый подход к машинному обучению позволяет создавать более стабильные и отказоустойчивые модели за счет явного моделирования неопределенности на уровне признаков.