SkyReels-V3: Видео из ничего: новый подход к генерации

Представлена технология SkyReels-V3, позволяющая создавать реалистичные видеоролики на основе различных входных данных, включая изображения, видео и аудио.

Представлена технология SkyReels-V3, позволяющая создавать реалистичные видеоролики на основе различных входных данных, включая изображения, видео и аудио.

Статья посвящена анализу влияния искусственного интеллекта на существующие правовые рамки в области интеллектуальной собственности и необходимости их адаптации к новой реальности.

![Для эффективной генерации продолжительных видео последовательностей механизм памяти использует три ключевые операции: сжатие, уменьшающее вычислительную нагрузку за счёт преобразования необработанной истории наблюдений [latex]O_{1:t}[/latex] в компактное представление; извлечение, обеспечивающее релевантность контекста посредством выборочного доступа к историческим сегментам; и консолидация, динамически обновляющая буфер памяти путём интеграции новых наблюдений [latex]O_{t+1}[/latex] и удаления устаревшей информации для поддержания непрерывного потока данных.](https://arxiv.org/html/2601.17067v1/x2.png)

Обзор посвящен развитию видеогенерации, в котором ключевым шагом становится создание «мировых моделей», способных к последовательному и причинно обоснованному моделированию динамики событий.

Новая методика позволяет создавать интеллектуальных агентов, способных самостоятельно находить и анализировать научные статьи для ответов на сложные вопросы.

Исследователи представили масштабный набор данных для оценки способности моделей искусственного интеллекта понимать и поддерживать беседы, в которых говорящие переключаются между разными языками.

Новые подходы искусственного интеллекта открывают беспрецедентные возможности для понимания и модификации T- и B-клеточных рецепторов, приближая эру персонализированной иммунотерапии.

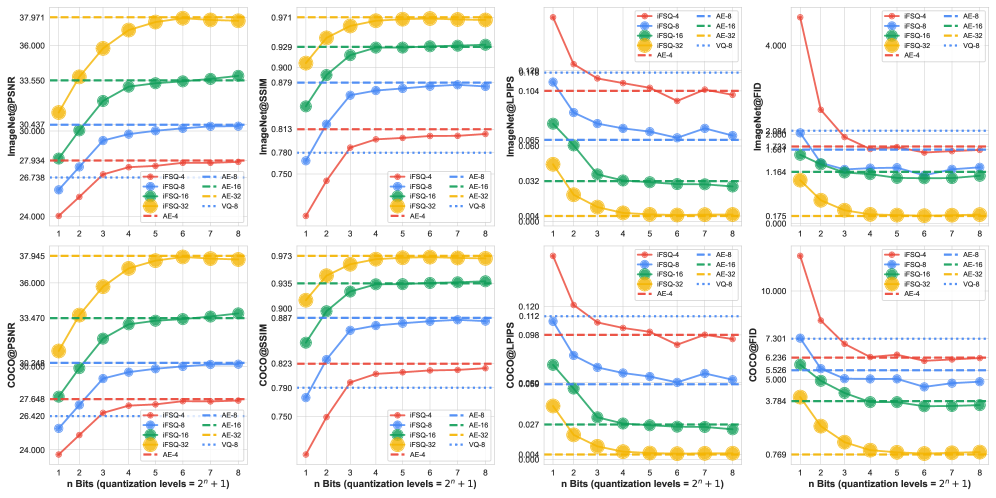

Исследователи представили iFSQ — простой способ улучшить качество генерируемых изображений, объединив подходы, используемые в различных типах нейросетей.

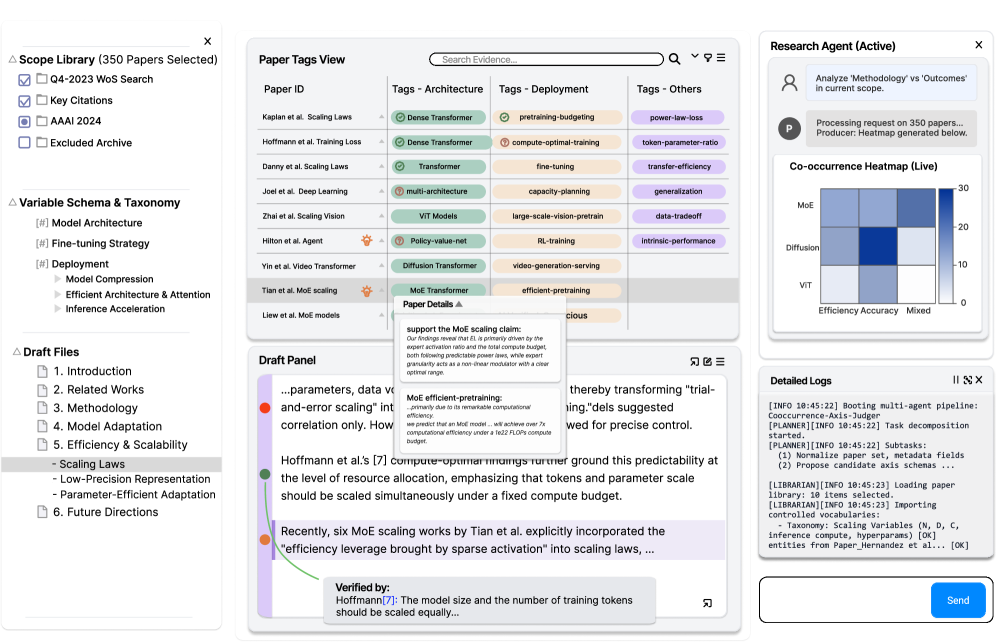

Новый подход к систематическим обзорам позволяет исследователям активно верифицировать утверждения и контролировать процесс анализа, а не полагаться на автоматическую генерацию данных.

Новый алгоритм динамически распределяет вычислительную нагрузку между графическими процессорами в моделях, использующих экспертный параллелизм, повышая скорость и эффективность.

Новые технологии искусственного интеллекта меняют подход к поиску схожих товарных знаков, повышая эффективность регистрации и снижая риски конфликтов.