Память, которая не забывает: Новая архитектура для долгосрочных агентов

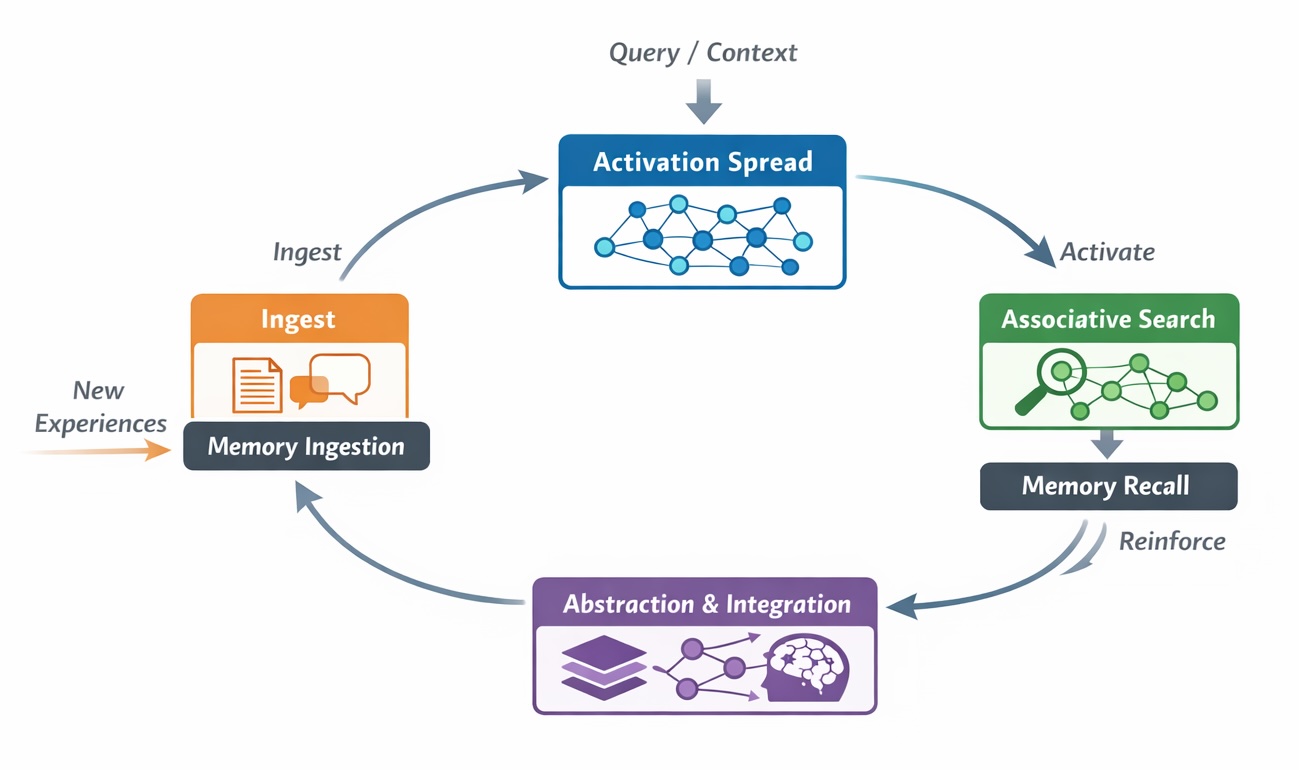

Исследователи предлагают принципиально новый подход к организации памяти для языковых агентов, позволяющий им сохранять и использовать информацию на протяжении неограниченно длительных периодов.

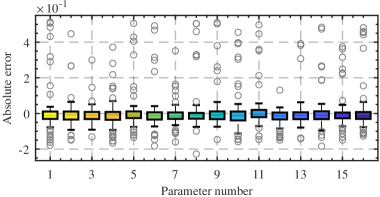

![Оптимальные законы масштабирования, полученные с использованием нейросетевой аппроксимации функции [latex]L(N,D)[/latex], позволяют выявить взаимосвязь между количеством параметров [latex]N[/latex] и объемом данных [latex]D[/latex] для достижения наилучшей производительности.](https://arxiv.org/html/2601.10684v1/x16.png)