Автор: Денис Аветисян

Новый гибридный алгоритм объединяет возможности квантовых вычислений и классического сжатия данных, открывая путь к эффективной подготовке квантовых состояний для устройств ближнего будущего.

В статье представлен метод, использующий классические алгоритмы сжатия, такие как вейвлет-преобразование, для снижения вычислительной сложности подготовки разреженных квантовых состояний на NISQ-устройствах.

Подготовка квантового состояния для произвольного $n$-кубитного вектора требует экспоненциального увеличения числа управляемых операций и глубины квантовой схемы, что делает точное кодирование амплитуд непрактичным для современных квантовых устройств. В данной работе, ‘Hybrid Quantum State Preparation via Data Compression’, предложен гибридный классическо-квантовый подход, использующий сжатие данных для снижения вычислительных затрат до полиномиального порядка для широкого класса сжимаемых данных. Метод сочетает классическое сжатие с последующей загрузкой разреженного представления и реконструкцией целевого состояния с помощью квантового обратного преобразования. Возможно ли, таким образом, создать масштабируемую основу для эффективной подготовки квантовых состояний, снижая квантовую нагрузку без использования вариационной оптимизации или дополнительных регистров?

Элегантность в Подготовке Квантовых Состояний

Подготовка квантовых состояний для обработки сложных данных представляет собой фундаментальное ограничение в квантовых вычислениях, сталкивающееся с экспоненциальным ростом необходимых ресурсов по мере увеличения объема входных данных. Эта сложность обусловлена тем, что для создания произвольного состояния $n$ кубитов требуется количество операций, которое растет экспоненциально с увеличением $n$. По сути, каждое добавление кубита усложняет задачу в геометрической прогрессии, что делает обработку больших объемов информации чрезвычайно ресурсоемкой и практически невозможной на современных и даже будущих квантовых устройствах. Это создает серьезное препятствие для реализации многих квантовых алгоритмов и ограничивает их применимость к реальным задачам, требующим обработки больших данных.

Традиционные методы подготовки квантового состояния (QSP) сталкиваются со значительными трудностями при работе с данными высокой размерности, что существенно ограничивает применимость квантовых алгоритмов на практике. Основная проблема заключается в экспоненциальном росте вычислительных ресурсов, необходимых для точного представления и манипулирования сложными квантовыми состояниями, кодирующими многомерные данные. Например, для кодирования $n$ признаков требуется экспоненциальное количество кубитов и квантовых операций, что быстро становится непосильным даже для современных квантовых компьютеров. В результате, алгоритмы, теоретически обладающие значительным ускорением, оказываются непрактичными для решения реальных задач, требующих обработки больших объемов информации. Поэтому, разработка новых, более эффективных методов QSP, способных справиться с данными высокой размерности, является ключевой задачей для развития квантовых вычислений и раскрытия их потенциала.

Стоимость подготовки квантового состояния напрямую связана с количеством кубитов ($n$). Необходимые ресурсы для создания произвольного $n$-кубитного состояния растут экспоненциально с увеличением $n$, что означает, что с каждым добавленным кубитом сложность и затраты увеличиваются в геометрической прогрессии. Это фундаментальное ограничение связано с тем, что для описания и управления каждым кубитом требуются дополнительные квантовые вентили и операции, а общее количество возможных состояний системы масштабируется как $2^n$. Следовательно, практическая реализация квантовых алгоритмов, требующих большого количества кубитов, сталкивается с серьезными технологическими и вычислительными трудностями, обусловленными экспоненциальным ростом требуемых ресурсов.

Эффективное кодирование данных играет ключевую роль в реализации потенциала квантовых устройств ближайшего будущего. Проблема заключается в том, что классические данные необходимо преобразовать в квантовое состояние, пригодное для обработки кванвым компьютером, и этот процесс может стать узким местом. Неудачное кодирование данных приводит к экспоненциальному росту необходимых ресурсов, делая решение задачи практически невозможным для сложных наборов данных. Исследования направлены на разработку методов, позволяющих компактно и эффективно представлять информацию в квантовой системе, минимизируя количество необходимых кубитов и квантовых операций. Успешное решение этой задачи позволит использовать преимущества квантовых вычислений для решения реальных задач, с которыми классические компьютеры не справляются, открывая новые горизонты в различных областях науки и техники, включая машинное обучение, материаловедение и финансовое моделирование.

Гибридные Алгоритмы: Гармония Классики и Квантов

Гибридные квантово-классические алгоритмы используют преимущества обеих вычислительных парадигм, применяя классические вычисления для предварительной обработки данных перед квантовым кодированием. Этот подход позволяет снизить требования к ресурсам квантового устройства за счет уменьшения объема данных, подлежащих квантовой обработке. Предварительная обработка включает в себя такие операции, как сжатие данных, фильтрация шумов и выделение признаков, которые выполняются классическими алгоритмами до передачи информации в квантовую систему. Использование классической предварительной обработки является ключевым фактором для реализации практических квантовых алгоритмов, учитывая текущие ограничения по количеству кубитов и времени когерентности.

Классическое сжатие является важным этапом в гибридных алгоритмах, поскольку позволяет уменьшить размерность входных данных перед их загрузкой в квантовое устройство. Этот процесс необходим для снижения требований к квантовым ресурсам, таким как число кубитов и глубина квантовой цепи. Уменьшение размерности достигается путем удаления избыточной или незначимой информации, что позволяет представить данные в более компактной форме. Эффективность сжатия напрямую влияет на производительность гибридного алгоритма, поскольку сокращает время вычислений и потребление энергии квантового процессора. Применение классических алгоритмов сжатия перед квантовой обработкой является стандартной практикой для решения задач, требующих обработки больших объемов данных.

Эффективное сжатие данных, используемое в гибридных алгоритмах, основано на достижении разреженного представления (sparse representation). Это означает, что большая часть значений входных данных равна нулю или пренебрежимо мала. Такое представление существенно снижает требования к квантовым ресурсам, таким как количество кубитов и глубина квантовых цепей. В разреженных данных информация кодируется лишь в небольшом количестве значимых элементов, что позволяет оптимизировать процесс квантового вычисления и уменьшить вычислительную сложность. Степень разреженности часто измеряется как отношение количества ненулевых элементов к общему числу элементов в данных. Чем выше эта доля, тем более эффективно сжатие и тем меньше ресурсов требуется для квантовой обработки.

Гибридные алгоритмы, использующие классическое сжатие данных, разработаны с принципом независимости от используемого преобразования (Transform-Agnostic). Это означает, что выбор метода сжатия, например, дискретного косинусного преобразования (DCT), вейвлет-преобразования или других методов, не влияет на основную структуру алгоритма. Такая гибкость позволяет оптимизировать процесс сжатия данных в соответствии со спецификой входных данных и доступными вычислительными ресурсами, а также адаптировать алгоритм к различным задачам, требующим уменьшения размерности входного вектора перед квантовым кодированием. Независимость от конкретного преобразования упрощает интеграцию различных методов сжатия и позволяет исследователям экспериментировать с различными подходами для достижения оптимальной производительности и минимизации требований к квантовым ресурсам.

Квантовая Реконструкция: Точность и Эффективность Сжатия

Кванвенсивное преобразование (Quantum Inverse Transform) является ключевым компонентом в алгоритмах квантовой реконструкции и сжатия. Его основная функция заключается в восстановлении исходного квантового состояния $\rho$ из его сжатого представления, полученного в результате применения квантового преобразования, например, квантового дискретного преобразования Фурье или вейвлета. Применение кванвенсивного преобразования позволяет обратить действие преобразования сжатия, минимизируя потери информации и обеспечивая максимально точное восстановление исходного состояния. Эффективность кванвенсивного преобразования напрямую влияет на общую производительность алгоритма сжатия и восстановления, определяя точность реконструкции квантовой информации.

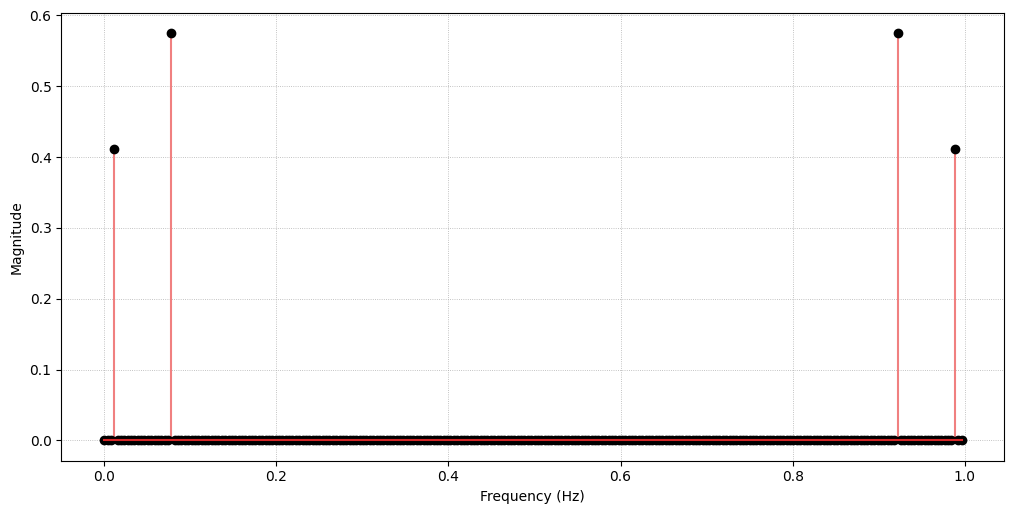

Для сжатия квантовой информации могут применяться различные методы, такие как дискретное преобразование Фурье (ДПФ) и дискретное преобразование Хаара. Выбор конкретного метода определяется характеристиками входных данных: ДПФ эффективно работает с данными, содержащими частотные компоненты, в то время как преобразование Хаара, основанное на вейвлетах, предпочтительнее для данных с резкими изменениями или локализованными особенностями. Оба метода позволяют представить квантовое состояние в более компактной форме, отбрасывая незначительные компоненты и уменьшая объем информации, необходимой для его хранения и передачи. Эффективность сжатия напрямую зависит от степени детализации, сохраняемой в процессе преобразования и от алгоритмов, используемых для отсева менее значимых коэффициентов.

Оценка эффективности алгоритмов квантовой реконструкции и сжатия производится с использованием метрики, известной как расстояние следа (Trace Distance). Данная метрика, определяемая как половина $L_1$-нормы разности матриц плотности исходного и реконструированного состояний, количественно определяет степень различия между этими состояниями. Значение расстояния следа варьируется от 0 до 1, где 0 указывает на идентичность состояний, а 1 — на максимальное отличие. Использование расстояния следа позволяет объективно сравнить различные алгоритмы сжатия и оценить потери информации, возникающие в процессе реконструкции квантового состояния.

В процессе классической компрессии квантовых данных применяются методы пороговой обработки (Thresholding) и нормализации для улучшения представления информации. Пороговая обработка предполагает отбрасывание амплитуд, значения которых ниже определенного порога, что позволяет уменьшить объем данных, сохраняя при этом наиболее значимые компоненты. Нормализация, в свою очередь, приводит амплитуды к единому масштабу, что повышает устойчивость алгоритмов и облегчает последующую обработку. Комбинация этих методов позволяет эффективно снизить объем классических данных, необходимых для хранения квантового состояния, без существенной потери информации, что критически важно для задач квантовой компрессии и реконструкции.

Влияние и Реализация: Квантовые Алгоритмы в Действии

Гибридные алгоритмы, представленные в исследовании, демонстрируют универсальность в обработке различных типов данных, включая сигналы, получаемые посредством фотоплетизмографии (ФПГ). Это открывает возможности для анализа физиологических данных непосредственно на квантовых компьютерах, что потенциально позволяет значительно ускорить и улучшить диагностические процедуры. Возможность применения к сигналам ФПГ, отражающим изменения объема крови в микроциркуляторном русле, позволяет проводить анализ сердечно-сосудистой деятельности и выявлять различные патологии с беспрецедентной точностью. Такой подход выходит за рамки традиционных методов обработки сигналов и позволяет использовать преимущества квантовых вычислений для решения сложных биомедицинских задач, открывая новые горизонты в области персонализированной медицины и мониторинга здоровья.

Для реализации и тестирования разработанных гибридных алгоритмов доступны открытые квантовые вычислительные платформы, такие как Qiskit и Qibo. Эти инструменты предоставляют разработчикам широкий спектр возможностей — от создания квантовых схем и симуляции их работы до непосредственного запуска на реальном квантовом оборудовании. Qiskit, разработанный IBM, отличается модульной структурой и обширной документацией, что облегчает процесс освоения. Qibo, в свою очередь, ориентирован на высокую производительность и оптимизацию ресурсов, что особенно важно при работе со сложными алгоритмами. Благодаря этим платформам, исследователи и разработчики получают возможность экспериментировать с квантовыми вычислениями, проверять работоспособность алгоритмов на различных типах данных и вносить свой вклад в развитие этой перспективной области науки и техники.

Оценка практической реализуемости квантовых алгоритмов неразрывно связана с анализом сложности квантовых схем. Ключевыми метриками в этом процессе выступают количество вентилей CNOT и глубина схемы — параметры, напрямую влияющие на требуемые ресурсы и время вычислений. Высокое число вентилей CNOT увеличивает вероятность ошибок, а большая глубина схемы затрудняет поддержание квантовой когерентности. Таким образом, минимизация этих показателей, при сохранении необходимой точности вычислений, является критически важной задачей при разработке и внедрении квантовых алгоритмов для решения реальных задач, включая анализ биомедицинских данных и обработку сигналов.

Предложенный подход демонстрирует значительное снижение вычислительной сложности по сравнению с методом полного перебора состояний (Exhaustive State Encoding, EAE) при обработке сигналов Гаусса. Исследования показали, что количество логических вентилей, необходимых для реализации алгоритма, может быть уменьшено до 79 раз, а глубина схемы — до 119 раз. Такое существенное сокращение вычислительных затрат открывает возможности для применения квантовых алгоритмов к более сложным задачам и данным, особенно в областях, где ресурсы квантовых компьютеров ограничены. Уменьшение $CNOT$ Gate Count и Circuit Depth является ключевым фактором для практической реализации квантовых вычислений, поскольку напрямую влияет на время выполнения и вероятность ошибок.

Исследование продемонстрировало высокую эффективность разработанного алгоритма при анализе реальных биомедицинских данных, а именно сигналов фотоплетизмографии (ФПГ). В ходе экспериментов, алгоритм достиг показателя достоверности в 99.755%, что свидетельствует о его способности точно воспроизводить и интерпретировать физиологические данные. Такая высокая точность открывает перспективы для применения квантовых вычислений в задачах мониторинга здоровья, диагностики заболеваний и персонализированной медицины, где критически важна надежность и точность анализа данных.

Перспективы и Сравнение: Ключ к Будущему Квантовых Алгоритмов

Несмотря на многообещающие результаты, гибридные подходы к квантовому сжатию данных сталкиваются с конкуренцией со стороны альтернативных методов, таких как загрузчик Фурье. Этот метод представляет собой упрощенную процедуру квантового сжатия признаков (QSP), предлагая более простую реализацию и потенциально меньшие вычислительные затраты. В отличие от сложных гибридных алгоритмов, загрузчик Фурье использует принципы разложения Фурье для эффективного представления данных в квантовой форме, что позволяет достичь сопоставимых результатов сжатия при меньшей сложности. Исследования показывают, что, хотя гибридные методы демонстрируют высокую производительность, их практическая реализация может быть затруднена из-за необходимости оптимизации множества параметров и высокой вычислительной нагрузки, в то время как загрузчик Фурье предоставляет более прямолинейный и экономичный путь к квантовому сжатию.

Исследование компромисса между степенью сжатия данных, точностью восстановления и сложностью квантовой схемы представляет собой ключевую задачу в развитии квантовых алгоритмов обработки сигналов. Более высокая степень сжатия, безусловно, снижает требования к памяти и пропускной способности, однако может привести к потере информации и снижению точности реконструкции исходного сигнала. В свою очередь, повышение точности восстановления часто требует более сложных квантовых схем, что увеличивает количество необходимых квантовых вентилей и глубину схемы — факторы, критичные для практической реализации на существующих и перспективных квантовых компьютерах. Оптимизация этого баланса, с учетом специфики конкретных данных и аппаратных ограничений, позволит создавать эффективные и масштабируемые квантовые алгоритмы, способные решать сложные задачи в различных областях, от обработки изображений и звука до анализа биомедицинских данных и финансовых рынков.

Исследования показали, что предложенный гибридный метод, применяемый к сигналу фотоплетизмографии (ФПГ), демонстрирует сопоставимое количество квантовых логических элементов с методом загрузчика ряда Фурье (FSL). Однако, ключевым преимуществом гибридного подхода является значительное снижение глубины квантовой схемы — на 32% по сравнению с FSL. Это означает, что для выполнения вычислений требуется меньше последовательных операций, что потенциально снижает вероятность ошибок и повышает эффективность квантового алгоритма. Уменьшение глубины схемы особенно важно для реализации на существующих и перспективных квантовых компьютерах, где ограничения по когерентности и точности операций являются критическими факторами.

В будущем исследования будут направлены на создание адаптивных алгоритмов сжатия, способных автоматически оптимизировать свою производительность в зависимости от характеристик входных данных. Такой подход предполагает, что алгоритм будет анализировать поступающий сигнал и динамически выбирать оптимальные параметры сжатия, обеспечивая наилучший баланс между степенью сжатия, точностью восстановления и сложностью квантовой схемы. Вместо использования фиксированных настроек, адаптивные алгоритмы смогут приспосабливаться к различным типам данных, что позволит существенно повысить эффективность квантовой обработки сигналов и расширить область применения квантовых вычислений. Особое внимание будет уделено разработке методов, способных эффективно обрабатывать данные с различной степенью сложности и изменчивости, обеспечивая высокую производительность в широком спектре сценариев.

Развитие представленных алгоритмов и методов квантового сжатия данных открывает перспективы для расширения области применения квантовых вычислений. Ожидается, что оптимизированные алгоритмы позволят решать задачи, недоступные для классических компьютеров, в таких областях, как обработка сигналов, анализ больших данных и машинное обучение. Уменьшение глубины квантовых схем и повышение точности реконструкции данных стимулируют разработку новых квантовых приложений, способствуя инновациям в медицине, финансах и материаловедении. В конечном итоге, эти достижения позволят реализовать весь потенциал квантовых вычислений, предоставляя инструменты для решения сложнейших проблем и продвигая научный прогресс в различных областях знаний.

Представленная работа демонстрирует изящное решение сложной задачи подготовки квантового состояния. Алгоритм, сочетающий классическое сжатие данных и квантовые вычисления, позволяет эффективно загружать многомерные данные на квантовые устройства ближнего действия. Этот подход, использующий, в частности, вейвлет-преобразование для снижения вычислительных затрат, подчеркивает стремление к оптимизации и гармонии между формой и функцией. Как однажды заметил Альберт Эйнштейн: «Фантазия важнее знания. Знание ограничено. Фантазия охватывает весь мир». Именно фантазия и стремление к элегантности позволили исследователям разработать столь изящное решение для подготовки квантовых состояний, открывая новые возможности для работы с данными на квантовых компьютерах.

Куда Далее?

Представленный подход к подготовке квантовых состояний, использующий сжатие данных, безусловно, открывает новые возможности для работы с данными высокой размерности на квантовых устройствах ближнего будущего. Однако, эйфория от кажущейся простоты не должна затмевать фундаментальные вопросы. Эффективность алгоритма напрямую зависит от выбора метода сжатия и, следовательно, от структуры исходных данных. Вполне возможно, что в погоне за снижением сложности квантовой схемы, мы лишь перекладываем вычислительную нагрузку на классический этап, создавая новые узкие места.

Более того, вопрос о природе “разреженности” квантовых состояний, используемых в алгоритме, требует более глубокого осмысления. Действительно ли достигнутая разреженность отражает истинную структуру данных, или это лишь артефакт выбранного метода сжатия? Настоящая элегантность заключается не в простом уменьшении количества кубитов, а в создании алгоритмов, которые эффективно используют имеющиеся ресурсы, сохраняя при этом информационную целостность.

Будущие исследования должны быть сосредоточены на разработке адаптивных методов сжатия, учитывающих специфику квантовых данных, а также на поиске новых способов представления разреженных состояний, минимизирующих потребность в ресурсах. Необходимо помнить, что квантовые вычисления — это не просто замена классических алгоритмов, а поиск принципиально новых подходов к решению сложных задач. И в этом поиске важна не только эффективность, но и изящество.

Оригинал статьи: https://arxiv.org/pdf/2512.01798.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Игры в коалиции: где стабильность распадается на части.

- Разгадывая тайны рождения джетов: машинное обучение на службе физики высоких энергий

- Доказательство устойчивости веб-агента: проактивное свертывание контекста для задач с горизонтом в бесконечность.

- Доказательства просят: Как искусственный интеллект помогает отличать правду от вымысла

- Квантовый прорыв в планировании ресурсов 5G

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Квантовая статистика без границ: новый подход к моделированию

- Голос в переводе: как нейросети учатся понимать речь

2025-12-02 13:10