Автор: Денис Аветисян

Новые рекомендации от COSEAL Research Network помогут повысить качество и воспроизводимость эмпирических исследований в области мета-алгоритмики.

Комплексный обзор лучших практик в области экспериментального дизайна, разработки программного обеспечения, статистического анализа и предотвращения загрязнения данных.

Эмпирические исследования в области метаалгоритмики, несмотря на свою важность, часто сталкиваются с проблемой обеспечения воспроизводимости и достоверности результатов. В настоящей работе, ‘Best Practices For Empirical Meta-Algorithmic Research Guidelines from the COSEAL Research Network’, представлен комплексный обзор лучших практик, охватывающий весь цикл эксперимента — от формулировки вопросов и выбора дизайна до анализа данных и представления результатов. Данное руководство, разработанное сообществом COSEAL, систематизирует разрозненные рекомендации и служит ориентиром для повышения качества исследований в сфере выбора, настройки и планирования алгоритмов. Сможем ли мы, следуя этим принципам, значительно ускорить прогресс и повысить надежность эмпирических выводов в метаалгоритмике?

Основы надежных исследований в метаалгоритмике

Метаалгоритмика, как быстро развивающаяся область, предъявляет повышенные требования к качеству исследований. Для обеспечения значимого прогресса в этой сфере необходима прочная основа научно-исследовательских практик. Это подразумевает не только четкое формулирование гипотез и выбор адекватных методов, но и строгое соблюдение этических норм, а также прозрачность и воспроизводимость полученных результатов. Отсутствие надежных исследовательских практик может привести к ошибочным выводам, неэффективным алгоритмам и замедлению развития всей области. Поэтому, систематическое применение проверенных методологий и постоянное совершенствование исследовательских подходов являются ключевыми факторами успеха в метаалгоритмике, позволяя создавать надежные и эффективные решения для широкого спектра задач.

Международное сообщество активно содействует укреплению эмпирической строгости и внедрению лучших практик в области мета-алгоритмики, что находит отражение в инициативах, подобных COSEAL. Данная организация, объединяя усилия исследователей по всему миру, разрабатывает и распространяет стандартизированные протоколы для проведения экспериментов, обеспечивая воспроизводимость и надежность полученных результатов. Акцент делается на прозрачности методологии, открытом доступе к данным и инструментам, а также на коллегиальном рецензировании, что позволяет минимизировать субъективные ошибки и повысить доверие к научным открытиям. Такая совместная работа способствует не только развитию самой области, но и формированию этичных и ответственных подходов к проведению исследований, гарантируя, что прогресс в мета-алгоритмике будет основан на достоверных и объективных данных.

Несмотря на внедрение строгих исследовательских протоколов, проблема загрязнения данных представляет собой серьезную угрозу для достоверности результатов в мета-алгоритмике. Загрязнение возникает, когда информация из тестового набора данных непреднамеренно проникает в обучающую выборку, что приводит к искусственно завышенным показателям производительности и неверной оценке обобщающей способности алгоритмов. Подобные утечки данных могут быть крайне тонкими и труднообнаружимыми, требуя постоянного и тщательного мониторинга всего процесса исследования, включая проверку источников данных, методов предобработки и алгоритмов обучения. Осознание этой потенциальной угрозы и применение строгих мер по предотвращению загрязнения данных — необходимое условие для обеспечения надежности и воспроизводимости научных результатов в данной области.

Проектирование экспериментов для валидации и надежности

Эффективное проектирование экспериментов является основополагающим для получения достоверных результатов в мета-алгоритмических исследованиях. Необходимость изоляции переменных достигается путем контролируемого изменения одного параметра при фиксации остальных, что позволяет установить причинно-следственные связи между входными данными и выходными результатами. Использование контрольных групп и рандомизация процедур снижает влияние систематических ошибок и случайных факторов. Тщательное планирование эксперимента включает определение ключевых метрик, выбор подходящих алгоритмов и методов анализа данных, а также достаточный размер выборки для обеспечения статистической мощности и минимизации вероятности ложноположительных или ложноотрицательных выводов. Отсутствие строгого экспериментального дизайна может привести к неверной интерпретации результатов и ошибочным заключениям о производительности или эффективности исследуемых мета-алгоритмов.

Оценка алгоритмов и методов посредством бенчмаркинга является ключевым этапом исследований, однако ценность долгосрочного использования эталонных наборов данных напрямую зависит от сохранения их актуальности. Со временем, изменения в аппаратном обеспечении, оптимизации компиляторов, а также развитие самих алгоритмов могут приводить к устареванию бенчмарков. В результате, производительность алгоритмов, измеренная на устаревших наборах данных, может не отражать их реальную эффективность в современных условиях. Поддержание долгосрочной релевантности бенчмарков требует периодического обновления наборов данных, добавления новых тестов, отражающих современные задачи и аппаратные возможности, а также учета изменений в технологическом ландшафте. Отсутствие такой поддержки снижает информативность бенчмарков и затрудняет объективную оценку прогресса в области разработки алгоритмов.

Статистическое тестирование, основанное на концепции статистической значимости, предоставляет количественные доказательства для подтверждения или опровержения выдвинутых гипотез. Оно включает в себя применение различных статистических методов, таких как t-тест, ANOVA и непараметрические тесты, для оценки вероятности получения наблюдаемых результатов при условии истинности нулевой гипотезы. Статистическая значимость обычно определяется с помощью $p$-значения, представляющего собой вероятность получения результатов, столь же экстремальных или более экстремальных, чем наблюдаемые, если нулевая гипотеза верна. Значение $p$ ниже установленного уровня значимости (обычно 0.05) указывает на статистическую значимость и позволяет отвергнуть нулевую гипотезу в пользу альтернативной. Важно отметить, что статистическая значимость не является мерой величины эффекта, а лишь указывает на то, что наблюдаемый эффект вряд ли произошел случайно.

Столпы воспроизводимой науки

Воспроизводимость является основополагающим принципом в мета-алгоритмике, обеспечивая возможность независимой проверки и подтверждения полученных результатов. Отсутствие воспроизводимости подрывает доверие к научным исследованиям и замедляет прогресс в данной области. Воспроизводимость позволяет другим исследователям повторить эксперименты, используя предоставленные данные и методы, что способствует выявлению ошибок, улучшению существующих алгоритмов и созданию новых, более эффективных решений. Это критически важно для валидации научных открытий и обеспечения их надежности, особенно в быстро развивающейся области мета-алгоритмов, где сложность и абстрактность требуют особо тщательной проверки.

Открытое программное обеспечение является ключевым фактором обеспечения воспроизводимости научных исследований в мета-алгоритмике. Публикация исходного кода позволяет другим исследователям изучить логику работы алгоритмов, проверить корректность реализации и подтвердить полученные результаты. Это включает в себя возможность независимой верификации, повторного запуска экспериментов с использованием тех же данных и параметров, а также возможность модификации и расширения кода для решения смежных задач или адаптации к новым данным. Предоставление доступа к коду способствует прозрачности научного процесса и повышает доверие к полученным выводам, позволяя сообществу совместно развивать и улучшать алгоритмы и методы.

Качество кода напрямую влияет на воспроизводимость результатов исследований в мета-алгоритмике. Надежный и поддерживаемый код позволяет независимым исследователям верифицировать полученные результаты, повторно выполнив эксперименты и подтвердив их корректность. Отсутствие четкой структуры, некачественная документация, использование устаревших библиотек или наличие ошибок в коде существенно затрудняют или делают невозможным воспроизведение результатов, подрывая доверие к научным выводам. Важными аспектами качественного кода являются модульность, читаемость, наличие тестов и соответствие общепринятым стандартам кодирования, что обеспечивает долгосрочную поддержку и возможность адаптации кода для новых задач и данных.

Влияние и коммуникация сложных результатов

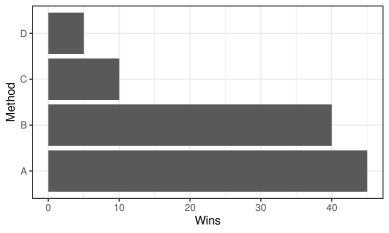

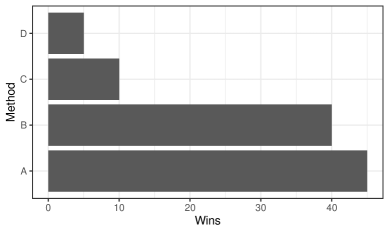

Эффективная визуализация данных играет ключевую роль в понимании и донесении результатов метаалгоритмических исследований. Сложность современных алгоритмов и объемы обрабатываемой информации часто делают традиционные текстовые отчеты недостаточными для полного восприятия. Визуальные представления, такие как графики, диаграммы и интерактивные элементы, позволяют исследователям выявлять закономерности, тренды и аномалии, которые могли бы остаться незамеченными в таблицах данных. Более того, качественно разработанная визуализация значительно облегчает процесс коммуникации результатов как внутри научного сообщества, так и для более широкой аудитории, способствуя более быстрому принятию новых идей и технологий. Особенно важно, чтобы визуализация была не только информативной, но и понятной, избегая излишней сложности и акцентируя внимание на наиболее значимых аспектах исследования, что делает ее незаменимым инструментом для продвижения научного прогресса.

Графики сходимости являются незаменимым инструментом для наглядной демонстрации эффективности алгоритмов во времени или при использовании различных ресурсов. Эти графики, как правило, отображают изменение ключевого показателя — например, значения функции потерь $L(x)$ или точности модели — в процессе работы алгоритма. Наблюдая за формой кривой сходимости, исследователь может быстро оценить скорость обучения, стабильность алгоритма и, при необходимости, выявить потенциальные проблемы, такие как переобучение или колебания. Более того, сравнение графиков сходимости для различных алгоритмов или параметров позволяет объективно оценить их относительную производительность и выбрать наиболее оптимальный подход для конкретной задачи. Использование графиков сходимости значительно упрощает процесс интерпретации результатов и делает информацию доступной для широкого круга специалистов.

Исследования в области мета-алгоритмов, несмотря на всю свою сложность, обретают истинную ценность лишь при условии сочетания строгой методологии и ясного изложения полученных результатов. Простого проведения качественного анализа недостаточно; необходимо уметь эффективно донести его суть до коллег и широкой научной общественности. Именно прозрачность и понятность позволяют другим исследователям использовать полученные данные в своей работе, строить на их основе новые гипотезы и, таким образом, способствовать развитию всей области. Игнорирование принципов четкой коммуникации приводит к тому, что даже самые значимые открытия остаются незамеченными или, что еще хуже, неправильно интерпретированными, что замедляет прогресс науки и снижает потенциальное влияние работы.

Исследование, представленное в данной работе, акцентирует внимание на необходимости строгого подхода к эмпирическим исследованиям в области мета-алгоритмики. Оно подчеркивает важность воспроизводимости и корректного статистического анализа, чтобы обеспечить надежность и значимость полученных результатов. В этом контексте, слова Эдсгера Дейкстры: «Простота — это высшая степень совершенства» как нельзя лучше отражают суть предлагаемых практик. Стремление к ясности в экспериментальном дизайне и программном обеспечении, а также исключение загрязнения данных, — это не просто технические требования, но и проявление уважения к научному процессу и будущим исследователям. Устранение избыточной сложности, как и предложено в статье, позволяет сосредоточиться на существенных аспектах исследования и повысить его ценность.

Что дальше?

Представленные рекомендации — не свод догм, а попытка выявить скелет, на котором можно нарастить мясо конкретных исследований. Абстракции стареют, принципы — нет. Иллюзия контроля над сложностью опасна. Необходимо признать, что воспроизводимость — это не просто проверка, а непрерывный процесс самоочищения методологии.

Главный вызов — не в создании более сложных алгоритмов, а в разработке инструментов для анализа их уязвимостей. Загрязнение данных — проблема не техническая, а эпистемологическая. Каждая сложность требует алиби. Особенно важно сместить фокус с оценки результатов на оценку процесса их получения.

Будущие исследования должны сосредоточиться на автоматизации проверки целостности данных и кода. Необходимо создать стандарты для мета-данных, описывающих не только сами алгоритмы, но и контекст их применения. И, возможно, самое главное — научиться признавать собственные ошибки, не пряча их за статистической значимостью.

Оригинал статьи: https://arxiv.org/pdf/2512.16491.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовый скачок: от лаборатории к рынку

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Функциональные поля и модули Дринфельда: новый взгляд на арифметику

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

2025-12-19 17:26