Автор: Денис Аветисян

Новая методика ProPhy позволяет значительно повысить физическую правдоподобность генерируемых видео, приближая их к реальности.

ProPhy — это фреймворк для улучшения видеогенерации с использованием явного физического руководства и точной пространственной привязки.

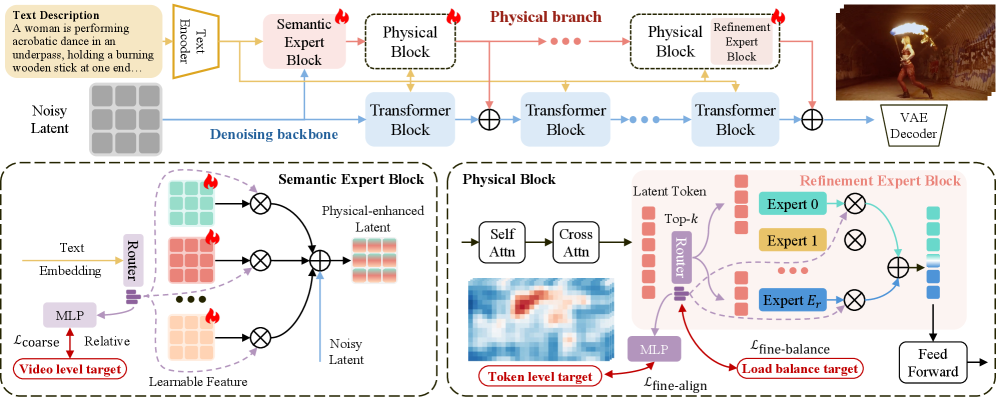

Несмотря на значительный прогресс в генерации видео, современные модели часто испытывают трудности с обеспечением физической согласованности, особенно в сложных динамических сценах. В данной работе представлена система ProPhy: Progressive Physical Alignment for Dynamic World Simulation, предлагающая новый подход к генерации видео с учетом физических принципов и точной пространственной ориентации объектов. Ключевой особенностью ProPhy является механизм двухэтапной экспертной смеси (MoPE), позволяющий модели извлекать знания о физике из текстовых описаний и точно воспроизводить динамику в генерируемых видео. Сможет ли предложенный фреймворк стать основой для создания реалистичных и правдоподобных виртуальных миров?

Физическая достоверность в генерации видео: вызов современным алгоритмам

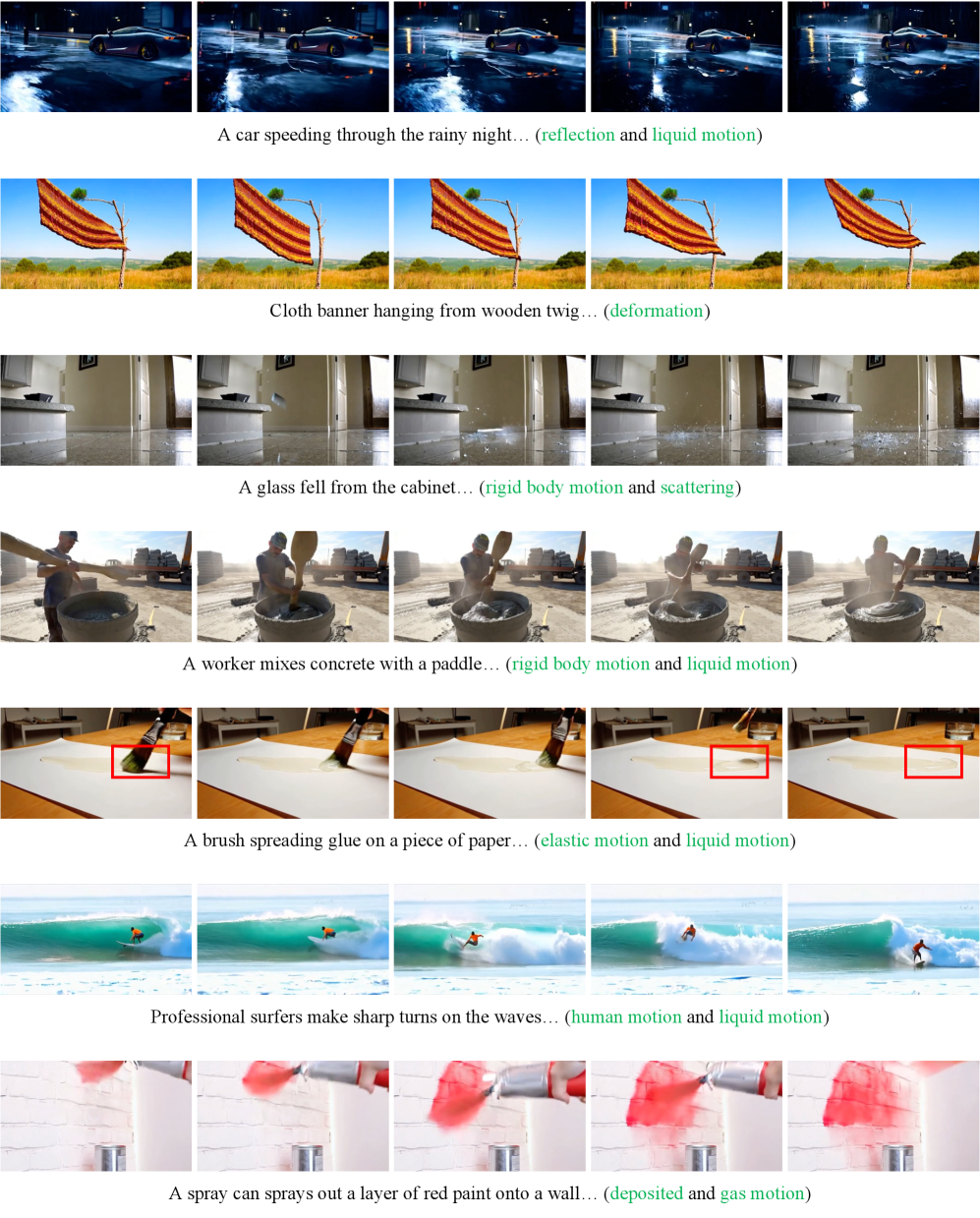

Современные методы генерации видео, несмотря на свою визуальную привлекательность, часто сталкиваются с проблемой физической достоверности, создавая сцены, которые кажутся неправдоподобными. Хотя сгенерированные изображения могут быть эстетически приятными, внимательный зритель легко заметит несоответствия в поведении объектов, например, неестественные траектории движения или нарушение законов гравитации. Это связано с тем, что большинство алгоритмов фокусируются на визуальном сходстве с реальными изображениями, а не на точной симуляции физических процессов, определяющих взаимодействие объектов в мире. В результате, даже высококачественные видеоролики, сгенерированные искусственным интеллектом, могут содержать тонкие, но заметные артефакты, разрушающие ощущение реализма и вызывающие дискомфорт у наблюдателя.

Отсутствие физической достоверности в генерируемых видео зачастую объясняется недостаточным моделированием базовых законов физики, регулирующих взаимодействие объектов. Современные алгоритмы, несмотря на впечатляющие визуальные результаты, нередко игнорируют такие факторы, как гравитация, инерция, трение и упругость материалов. В результате, создаваемые сцены могут казаться неестественными и неправдоподобными, поскольку объекты ведут себя не так, как ожидается в реальном мире. Например, падающие предметы могут демонстрировать аномальное поведение, жидкости могут течь вопреки законам гидродинамики, а твердые тела могут проникать друг в друга. Улучшение учета этих физических принципов является ключевой задачей для создания действительно реалистичных и убедительных видео, что требует разработки новых методов и алгоритмов, способных адекватно моделировать сложные физические явления.

Современные диффузионные модели, демонстрирующие впечатляющие результаты в генерации видео, требуют колоссальных вычислительных ресурсов даже для достижения умеренного уровня реализма. Этот факт существенно ограничивает их широкое применение, особенно в условиях ограниченных аппаратных возможностей или при необходимости генерации больших объемов видеоконтента. Несмотря на прогресс в оптимизации алгоритмов, процесс обучения и инференса таких моделей остается чрезвычайно затратным, требуя мощных графических процессоров и значительных объемов памяти. В результате, доступ к передовым технологиям генерации видео остается привилегией крупных исследовательских групп и компаний, что сдерживает инновации и развитие приложений в различных областях, от развлечений до образования и научных исследований.

ProPhy: гармонизация видео с физической реальностью

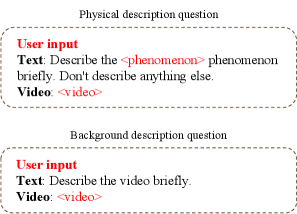

ProPhy представляет собой прогрессивную структуру физического выравнивания (Progressive Physical Alignment Framework), предназначенную для улучшения генерации видео за счет обеспечения соответствия с законами физики. В отличие от традиционных методов, которые часто игнорируют физическую достоверность, ProPhy активно внедряет физические ограничения в процесс генерации, что позволяет создавать более реалистичные и правдоподобные видеоролики. Это достигается путем анализа текстовых запросов на предмет физически релевантной информации и последующего применения этих знаний для корректировки и уточнения генерируемого видеоконтента. Таким образом, ProPhy стремится к созданию видео, в котором объекты взаимодействуют друг с другом и с окружающей средой в соответствии с принципами физики, минимизируя аномалии и нереалистичное поведение.

В основе ProPhy лежит использование Mixture-of-Physics-Experts — ансамбля экспертных моделей, предназначенного для извлечения и уточнения иерархических физических априорных знаний из текстовых запросов. Этот подход позволяет системе анализировать входной текст и выделять релевантную информацию о физических свойствах объектов и взаимодействиях между ними. Извлеченные знания затем структурируются в виде иерархии, где более общие физические принципы применяются на верхних уровнях, а более специфические детали — на нижних. Уточнение этих априорных знаний осуществляется посредством обучения экспертных моделей на большом объеме данных, что позволяет системе генерировать видео, более точно соответствующие законам физики и обеспечивающие реалистичное поведение объектов в кадре.

Архитектура ProPhy включает в себя два ключевых блока: Семантический экспертный блок и блок Уточнения. Семантический экспертный блок осуществляет разбор текстовых запросов с целью выявления информации, релевантной физическим законам и принципам. Извлеченные данные о физических свойствах и взаимосвязях затем передаются в блок Уточнения. Блок Уточнения использует эту информацию для внесения соответствующих корректировок и ограничений в процесс генерации видео, обеспечивая соответствие сгенерированного контента законам физики и реалистичному поведению объектов. Это позволяет создавать более правдоподобные и физически корректные видеоролики.

Строгая оценка с использованием VideoPhy2

Для оценки ProPhy используется бенчмарк VideoPhy2, специализированный набор данных, предназначенный для всесторонней оценки физической правдоподобности генерируемых видео. В отличие от общих метрик, VideoPhy2 учитывает не только соблюдение базовых законов физики, но и более сложные аспекты, такие как пространственная анизотропия и корректность взаимодействия объектов. Набор данных состоит из разнообразных видеосцен, тщательно разработанных для выявления даже незначительных отклонений от реалистичной физической симуляции, что позволяет проводить объективную и детализированную оценку моделей генерации видео.

В процессе оценки физической правдоподобности генерируемых видео, VideoPhy2 учитывает не только соблюдение фундаментальных законов физики, но и более сложные аспекты. В частности, оценивается учет пространственной анизотропии — зависимости физических свойств от направления в пространстве, что критически важно для реалистичной симуляции движения и деформации объектов. Кроме того, benchmark анализирует корректность взаимодействия объектов между собой, включая столкновения, трение и гравитационное влияние, что позволяет выявить недостатки в моделировании физических процессов, выходящих за рамки простых законов движения и сохранения энергии.

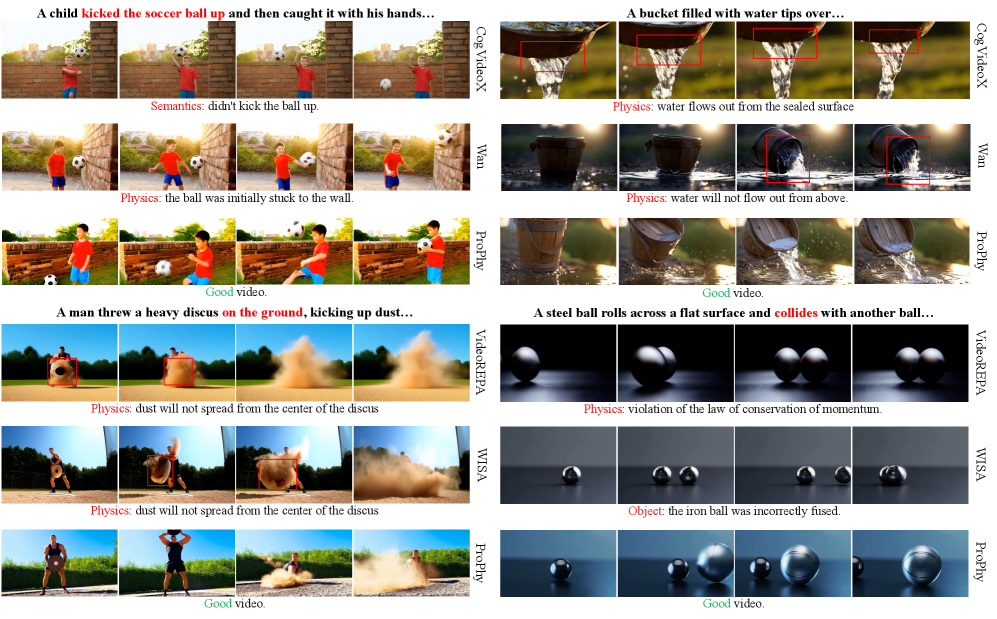

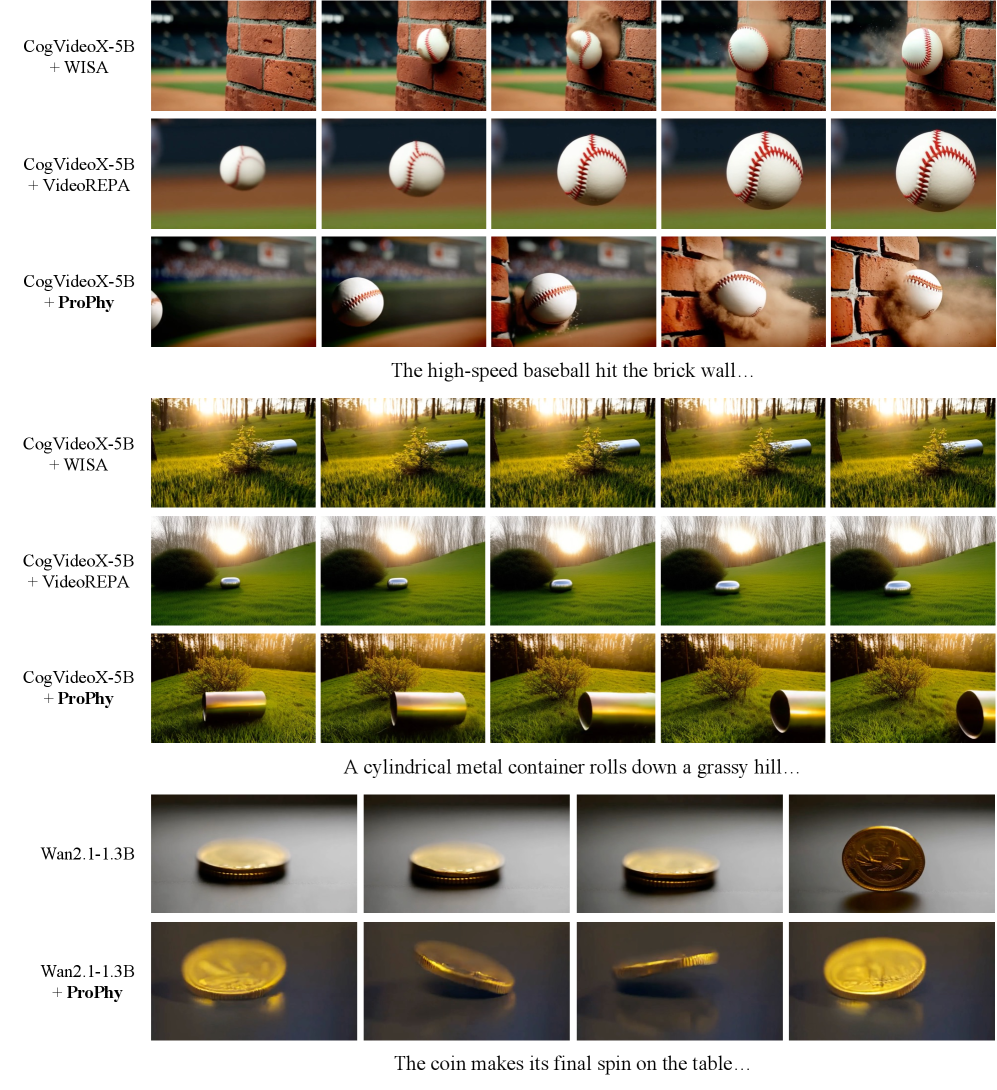

Результаты оценки ProPhy на бенчмарке VideoPhy2 демонстрируют значительное улучшение физической реалистичности генерируемых видео по сравнению с базовыми моделями. В частности, ProPhy достиг повышения показателя Joint Pass Rate на 19.7% относительно базовой модели Wan2.1. Данный показатель отражает способность модели генерировать видео, которые соответствуют базовым и сложным законам физики, включая пространственную анизотропию и взаимодействие объектов. Улучшение Joint Pass Rate свидетельствует о более высокой степени соответствия генерируемого контента физическим принципам, что является важным критерием оценки для моделей генерации видео.

В основе системы лежит использование Визуально-Языковых Моделей (VLM), в частности Qwen2.5, для повышения точности интерпретации текстовых запросов, связанных с физикой. Оценка точности VLM проводилась на основе детальной аннотации, демонстрируя общий показатель в 76.9%. Это позволяет системе более корректно понимать и учитывать физические ограничения и взаимосвязи, указанные в текстовом описании, что критически важно для генерации физически правдоподобных видео.

Влияние и перспективы развития

Система ProPhy открывает новые горизонты для реалистичного моделирования в областях, требующих высокой степени достоверности визуальных данных. В робототехнике это позволит создавать виртуальные среды для обучения и тестирования роботов, максимально приближенные к реальным условиям. Для беспилотных автомобилей ProPhy может генерировать сценарии вождения с учетом физических законов, обеспечивая более надежное обучение систем автопилотирования. В сфере виртуальной реальности технология способна создавать захватывающие и правдоподобные миры, где взаимодействие с окружением будет ощущаться естественно и интуитивно, значительно повышая уровень погружения и доверия к симуляции.

Основывая генерацию видео на принципах физики, создается принципиально новый подход к разработке искусственного интеллекта, обеспечивающий повышенную надежность и устойчивость систем. Традиционные методы часто генерируют реалистичные, но физически неправдоподобные сцены, что приводит к ошибкам в задачах, требующих понимания окружающего мира. В отличие от них, модели, учитывающие законы физики, способны создавать видео, в котором объекты ведут себя предсказуемо и логично, что критически важно для приложений, связанных с робототехникой, автономным транспортом и виртуальной реальностью. Такой подход позволяет системам не просто «видеть», но и «понимать» происходящее, значительно повышая их способность к адаптации и принятию обоснованных решений в сложных и динамичных условиях.

Дальнейшие исследования ProPhy направлены на расширение возможностей моделирования сложных физических явлений, включая нелинейную динамику жидкостей и газов, деформацию твердых тел и взаимодействие света с материей. Особое внимание уделяется интеграции более продвинутых алгоритмов рассуждений, позволяющих системе не только генерировать визуально правдоподобные сцены, но и предсказывать поведение физических объектов в различных ситуациях. Это предполагает разработку методов, позволяющих ProPhy понимать причинно-следственные связи и применять физические принципы для решения задач, выходящих за рамки простой визуализации, что откроет новые перспективы в области робототехники, виртуальной реальности и автономных систем.

В дальнейшем исследовании планируется использовать архитектуры WAN и CogVideoX в качестве основы для ProPhy, что позволит значительно повысить производительность и масштабируемость системы. Особое внимание будет уделено сохранению высоких показателей качества, измеряемых с помощью VBench, гарантируя, что улучшения в скорости и объеме обработки не скажутся на реалистичности и достоверности генерируемых видео. Такой подход позволит создать более эффективную и универсальную платформу для моделирования физических процессов, расширяя возможности применения ProPhy в различных областях, таких как робототехника и виртуальная реальность.

В рамках исследования ProPhy, представленного в статье, акцент на достижение физической правдоподобности в генерируемых видео приобретает особую значимость. Подход, заключающийся в тонкой пространственной привязке и использовании физически обоснованного обучения, подчеркивает стремление к элегантности в моделировании динамичного мира. Как однажды заметил Джеффри Хинтон: «Я думаю, что машинное обучение очень хорошо подходит для поиска закономерностей. Но когда речь заходит о причинности, мы должны быть осторожны». В контексте ProPhy, это предостережение напоминает о необходимости не просто генерировать визуально убедительные сцены, но и обеспечивать их соответствие фундаментальным законам физики, что и является ключом к созданию действительно реалистичных и правдоподобных симуляций.

Куда же дальше?

Представленная работа, стремясь к элегантности в симуляции динамичного мира, неизбежно обнажает границы текущего понимания. Хотя ProPhy и демонстрирует впечатляющий прогресс в достижении физической правдоподобности генерируемых видео, вопрос о полной гармонии между алгоритмом и реальностью остаётся открытым. В конечном счёте, воспроизведение сложной физики требует не просто введения ограничений, но и глубокого понимания лежащих в её основе принципов — понимания, которое пока ещё ускользает от современных моделей.

Особый интерес представляет дальнейшее исследование взаимодействия между физическими ограничениями и возможностями больших языковых моделей (VLM). Умение VLM понимать и интерпретировать физические явления, безусловно, является ценным активом, однако вопрос о том, как эффективно интегрировать эти знания в процесс генерации видео, требует более детального изучения. Необходимо искать способы, позволяющие моделям не просто следовать заданным правилам, но и творчески применять их, создавая видео, которые кажутся не просто правдоподобными, но и осмысленными.

В перспективе, представляется важным отойти от упрощенных моделей физики и перейти к более сложным и реалистичным симуляциям. Это потребует значительных вычислительных ресурсов, но и откроет новые возможности для создания видео, которые будут неотличимы от реальности. И тогда, возможно, станет понятно, что истинная красота заключается не в безупречном воспроизведении физических законов, а в умении создавать иллюзии, которые заставляют нас поверить в невозможное.

Оригинал статьи: https://arxiv.org/pdf/2512.05564.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Квантовый Борьба: Китай и США на Передовой

- Укрощение шума: как оптимизировать квантовые алгоритмы

- Интеллектуальная маршрутизация в коллаборации языковых моделей

- Квантовые симуляторы: проверка на прочность

- Квантовые нейросети на службе нефтегазовых месторождений

- Искусственный интеллект заимствует мудрость у природы: новые горизонты эффективности

2025-12-08 12:00