Автор: Денис Аветисян

В статье рассматриваются эффективные методы ускорения работы диффузионных моделей, позволяющие создавать изображения по текстовому описанию с меньшими затратами ресурсов.

Обзор и сравнение техник дистилляции траекторий и моделей согласованности для оптимизации генерации изображений по тексту.

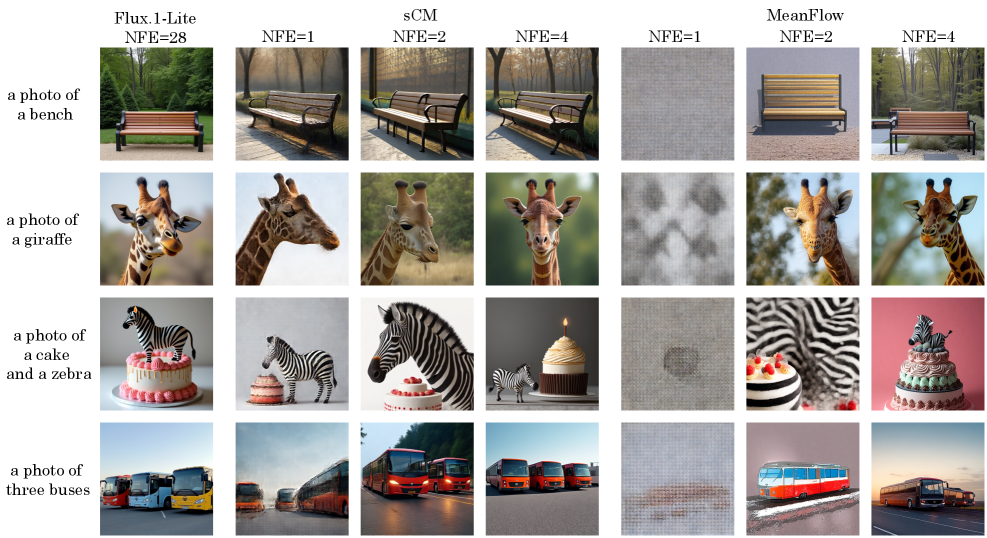

Несмотря на значительный прогресс в генерации изображений по текстовому описанию, вычислительная сложность диффузионных моделей остается серьезным препятствием. В работе ‘Few-Step Distillation for Text-to-Image Generation: A Practical Guide’ представлено систематическое исследование методов дистилляции, направленное на ускорение и оптимизацию процесса генерации изображений. Авторы сравнивают различные подходы, включая Consistency Models, MeanFlow и Consistency Distillation, выявляя ключевые факторы, влияющие на производительность и качество генерируемых изображений. Сможет ли дистилляция стать эффективным инструментом для развертывания быстрых, экономичных и высококачественных генераторов изображений в реальных приложениях?

Вычислительные Пределы Диффузионных Моделей

Диффузионные модели, демонстрирующие передовые результаты в генерации изображений, характеризуются значительной вычислительной сложностью. Суть проблемы заключается в необходимости выполнения огромного количества $Network Function Evaluations$ — последовательных вычислений, требующих больших ресурсов. Каждая итерация процесса генерации подразумевает обработку данных нейронной сетью, что, при стремлении к высокой детализации и реалистичности изображения, приводит к экспоненциальному росту требуемых вычислительных мощностей и времени. В результате, несмотря на выдающееся качество генерируемых изображений, практическое применение этих моделей часто ограничено из-за высоких затрат и низкой скорости работы.

Несмотря на выдающиеся результаты в генерации изображений, диффузионные модели сталкиваются с серьезным ограничением — высокой вычислительной стоимостью. Это препятствует их широкому применению в сценариях, требующих быстродействия, таких как интерактивные приложения или обработка данных в реальном времени. Необходимость выполнения большого количества вычислений, связанных с итеративным процессом диффузии, делает генерацию одного изображения ресурсоемкой задачей. В результате, несмотря на превосходное качество создаваемых изображений, практическая реализация и масштабирование этих моделей оказываются затруднены, что подчеркивает потребность в инновационных методах ускорения вычислений и оптимизации алгоритмов.

Устранение разрыва в эффективности вычислений имеет решающее значение для обеспечения широкого доступа к генеративному искусственному интеллекту высокого качества. В настоящее время значительные вычислительные затраты, связанные с диффузионными моделями, ограничивают их применение в различных областях, особенно для пользователей с ограниченными ресурсами. Снижение этих затрат позволит расширить круг лиц, способных использовать мощь генеративного ИИ для решения творческих задач, проведения научных исследований и разработки инновационных приложений. Обеспечение доступности этих технологий способствует более широкому распространению знаний и возможностей, демократизируя сферу искусственного интеллекта и позволяя большему числу людей воспользоваться преимуществами передовых алгоритмов генерации контента. Это, в свою очередь, может стимулировать новые открытия и инновации, способствуя развитию технологий и расширению творческого потенциала.

Традиционные методы генерации изображений, несмотря на достигнутые успехи, часто сталкиваются с проблемой компромисса между скоростью и качеством результата. Попытки ускорить процесс генерации зачастую приводят к заметной потере детализации и реалистичности изображения, а стремление к высокой точности требует значительных вычислительных ресурсов и времени. Это создает потребность в принципиально новых подходах к ускорению диффузионных моделей, которые позволят добиться высокой скорости генерации без ущерба для качества и фотореалистичности получаемых изображений. Разработка инновационных техник, способных эффективно использовать доступные вычислительные мощности и оптимизировать процесс диффузии, является ключевой задачей для дальнейшего развития и широкого внедрения этой перспективной технологии.

Дистилляция Распределений: Путь к Ускорению Генерации

Дистилляция распределений (Distribution Distillation) представляет собой эффективный метод ускорения генерации изображений, основанный на передаче знаний от большой, медленной «учительской» модели к меньшей, более быстрой «студенческой» модели. Этот процесс позволяет «студенту» приблизиться к производительности «учителя», используя меньшее количество шагов генерации. Передача знаний осуществляется не путем прямого копирования параметров, а путем обучения «студента» воспроизводить вероятностные распределения, генерируемые «учителем». Таким образом, «студент» учится не только чему генерировать, но и как генерировать, имитируя поведение более сложной модели, что обеспечивает значительное повышение скорости генерации при сохранении качества выходных данных.

Метод дистилляции распределений позволяет ускорить генерацию изображений за счет передачи знаний от большой, медленной «учительской» модели к более компактной и быстрой «студенческой». Суть подхода заключается в сопоставлении выходных распределений вероятностей, генерируемых обеими моделями. Минимизируя расхождение между этими распределениями, «студенческая» модель обучается приближать производительность «учительской», требуя при этом значительно меньшего числа шагов для генерации аналогичного результата. Это достигается за счет того, что «студент» не просто копирует выходные значения «учителя», а усваивает структуру вероятностного распределения, что позволяет ему делать более обоснованные предсказания и генерировать качественные изображения с меньшими вычислительными затратами.

Прямая дистилляция распределений (Direct Distribution Distillation) представляет собой усовершенствованный метод передачи знаний от большой, медленной «учительской» модели к меньшей, более быстрой «студенческой» модели. В отличие от традиционных подходов, DMD напрямую минимизирует расхождение между выходными распределениями учителя и студента, используя такие метрики как $KL$-дивергенция или расстояние Вассерштейна. Это позволяет студенческой модели более эффективно аппроксимировать производительность учителя, требуя меньше шагов для генерации изображения и значительно повышая скорость работы, особенно в задачах, где важна низкая латентность.

Модели DMD и её улучшенная версия DMDv2 демонстрируют возможность одношаговой генерации изображений, используя принцип дистилляции распределений. DMD (Distribution Matching Distillation) напрямую минимизирует расхождение между распределениями выходов «учителя» и «ученика», позволяя последнему воспроизводить качество генерации «учителя» за один шаг. DMDv2, в свою очередь, вносит улучшения в процесс дистилляции, оптимизируя функцию потерь и архитектуру сети для повышения эффективности и стабильности одношаговой генерации. Обе модели позволяют значительно сократить время генерации изображений по сравнению с традиционными многошаговыми методами, сохраняя при этом высокое качество выходных данных.

Латентная Оптимизация и Состязательная Дистилляция

Метод $Latent Adversarial Diffusion Distillation$ (LADD) является расширением дистилляции распределений, в котором используется состязательная игра (adversarial game) непосредственно в латентном пространстве. В отличие от стандартной дистилляции, LADD обучает модель-студент не только воспроизводить выходные данные модели-учителя, но и противостоять дискриминатору, который пытается отличить сгенерированные студентом данные от реальных. Это состязательное обучение в латентном пространстве позволяет студенту лучше усваивать сложные характеристики распределения данных, что приводит к более эффективной передаче знаний и повышению качества генерируемых данных по сравнению с традиционными методами дистилляции.

Модели, такие как LADD и SD3-Turbo, демонстрируют значительное увеличение скорости генерации изображений при сохранении высокого уровня качества. В частности, LADD использует дистилляцию с состязательным обучением в латентном пространстве, что позволяет снизить вычислительные затраты без существенной потери в метриках качества изображения, таких как FID и IS. SD3-Turbo, в свою очередь, использует оптимизированный процесс дистилляции, позволяющий достичь скорости генерации до 30 кадров в секунду на стандартном оборудовании, сохраняя при этом визуальную достоверность и детализацию генерируемых изображений. Эти результаты подтверждают, что оптимизация процесса дистилляции в латентном пространстве является эффективным методом для создания быстрых и качественных моделей генерации изображений.

Успех моделей, таких как LADD и SD3-Turbo, подтверждает преимущества углубленной оптимизации процесса дистилляции знаний. Использование состязательного обучения (adversarial learning) в латентном пространстве позволяет не только ускорить процесс генерации изображений, но и сохранить высокое качество получаемых результатов. Состязательная дистилляция, в отличие от традиционных методов, предполагает обучение модели-студента не только подражанию выходным данным модели-учителя, но и обману дискриминатора, который пытается отличить сгенерированные изображения от реальных. Это приводит к более эффективной передаче знаний и повышению производительности модели-студента, поскольку она вынуждена генерировать изображения, которые не только соответствуют распределению данных, но и выглядят реалистично с точки зрения дискриминатора.

Оптимизация процесса дистилляции в латентном пространстве позволяет значительно повысить эффективность генерации изображений. Вместо работы непосредственно с пикселями, современные модели, такие как LADD и SD3-Turbo, фокусируются на сжатом представлении данных в латентном пространстве. Это позволяет снизить вычислительную сложность и ускорить процесс генерации без существенной потери качества изображения. Такой подход обеспечивает более эффективную передачу знаний от большой, сложной модели («учителя») к меньшей, более быстрой модели («ученику»), что приводит к сокращению времени генерации и снижению требований к вычислительным ресурсам, сохраняя при этом высокую степень детализации и реалистичности генерируемых изображений.

Траекторная Дистилляция и Согласованное Моделирование

В отличие от традиционной одношаговой дистилляции, метод траекторной дистилляции позволяет студенческой модели обучаться предсказывать целые сегменты траектории выборки, генерируемой учительской моделью. Такой подход выходит за рамки простого копирования отдельных шагов, позволяя студенту улавливать динамику и структуру всего процесса генерации. Вместо того, чтобы фокусироваться на мгновенных решениях, студент учится прогнозировать последовательность действий, что приводит к более стабильному и качественному результату. Это особенно важно в задачах, где важна согласованность и долгосрочное планирование, поскольку студент получает возможность учитывать контекст и предвидеть будущие шаги, подобно учительской модели.

Методики, такие как sCM и IMM, играют ключевую роль в улучшении стабильности и качества генерации данных, основываясь на принципе обеспечения согласованности на уровне распределений. Вместо простого копирования отдельных шагов, эти подходы стремятся к тому, чтобы генерируемые данные соответствовали общему распределению, характерному для обучающей выборки. sCM, например, фокусируется на согласовании между различными стадиями генерации, минимизируя отклонения и обеспечивая плавный переход между состояниями. IMM, в свою очередь, использует концепцию смешивания моделей для создания более надежного и устойчивого процесса генерации. Благодаря этому, модели, обученные с использованием этих техник, демонстрируют высокую производительность и способны воспроизводить данные, близкие к оригинальным, даже при ограниченном количестве шагов генерации.

Метод MeanFlow совершенствует процесс дистилляции траекторий, фокусируясь на изучении среднего значения вектора скорости в поле потока данных. Этот подход позволяет более эффективно оптимизировать генерацию, поскольку обучение модели на усредненных векторах скорости способствует созданию более плавных и последовательных траекторий. В результате, MeanFlow демонстрирует значительные улучшения в показателях, приближаясь к производительности модели-учителя при меньшем количестве шагов, что подтверждается достижением оценки GenEval Overall в 51.41% при NFE=4 и высокой степенью согласования с эталонными данными, измеренной как DPG-Bench Alignment Score в 80.03% при NFE=4. Такой подход позволяет генерировать более реалистичные и качественные данные, эффективно используя вычислительные ресурсы.

Исследования в области дистилляции траекторий продемонстрировали впечатляющие результаты в достижении производительности, сопоставимой с эталонными моделями. В частности, применение метода sCM позволило достичь показателя GenEval Overall Score в 52.81% при NFE=2, что соответствует эффективности модели-учителя. Более того, sCM демонстрирует функциональную одношаговую генерацию с результатом 43.28% при NFE=1. Параллельно, подход MeanFlow достиг GenEval Overall Score в 51.41% при NFE=4, а также показал высокую степень согласованности с эталонными данными, достигнув 80.03% по шкале DPG-Bench Alignment Score при NFE=4. Эти результаты свидетельствуют о потенциале дистилляции траекторий для создания эффективных генеративных моделей, способных приближаться к производительности более сложных систем при меньшем количестве шагов.

Статья исследует методы ускорения генерации изображений, что, конечно, неизбежно. Все эти Consistency Models, MeanFlow и Consistency Distillation — лишь попытки приручить неуправляемый процесс диффузии. По сути, это всё та же самая задача — заставить машину рисовать картинки, только теперь с более изящными (или претендующими на изящество) алгоритмами. Как говорил Эндрю Ын: «Самый важный навык для инженера машинного обучения — это умение заставить что-то работать». И пусть эти «революционные» подходы через год превратятся в очередной техдолг, главное, чтобы картинки генерировались хотя бы последовательно. Ведь стабильная ошибка — это тоже результат.

Что дальше?

Исследование, представленное в данной работе, неизбежно сталкивается с тем, что каждая оптимизация — это лишь отсрочка неизбежного техдолга. Ускорение генерации изображений путем дистилляции, будь то Consistency Models или MeanFlow, лишь временно снижает стоимость вычислений. Рано или поздно, потребность в более сложных сценах, более высоком разрешении и, конечно же, запросах, сформулированных с присущей человеку нелогичностью, вновь вернет проблему к исходному состоянию. Тесты, подтверждающие качество сгенерированных изображений, — это, скорее, форма надежды, а не гарантия стабильности в реальных условиях эксплуатации.

Очевидно, что следующий этап — это не столько усовершенствование алгоритмов дистилляции, сколько поиск способов более эффективного использования доступных ресурсов. Автоматизация, обещающая спасение, уже не раз демонстрировала свою способность удалять прод по понедельникам. Вместо того, чтобы гнаться за идеальным алгоритмом, следует сосредоточиться на создании систем, способных адаптироваться к неизбежным сбоям и нелепым запросам пользователей.

В конечном счете, вся эта гонка за скоростью и эффективностью — лишь временное облегчение. Истинный вызов заключается в том, чтобы построить системы, которые смогут выжить в хаосе реального мира, где запросы всегда будут сложнее, данные — грязнее, а пользователи — непредсказуемее.

Оригинал статьи: https://arxiv.org/pdf/2512.13006.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Восполняя пробелы в знаниях: Как языковые модели учатся делать выводы

- Квантовый Монте-Карло: Моделирование рождения электрон-позитронных пар

- Квантовый скачок из Андхра-Прадеш: что это значит?

- Виртуальная примерка без границ: EVTAR учится у образов

- Геометрия на пределе: как алгоритмы оптимизации превосходят языковые модели

- Разгадывая тайны квантового мира: переработка кубитов и шум как тайная приправа?

- Оптимизация партийных запросов: Метод имитации отжига против градиентных подходов

- Эмоциональный отпечаток: Как мы научили ИИ читать душу (и почему рейтинги вам врут)

- Скрытая сложность: Необратимые преобразования в квантовых схемах

2025-12-17 01:22