Автор: Денис Аветисян

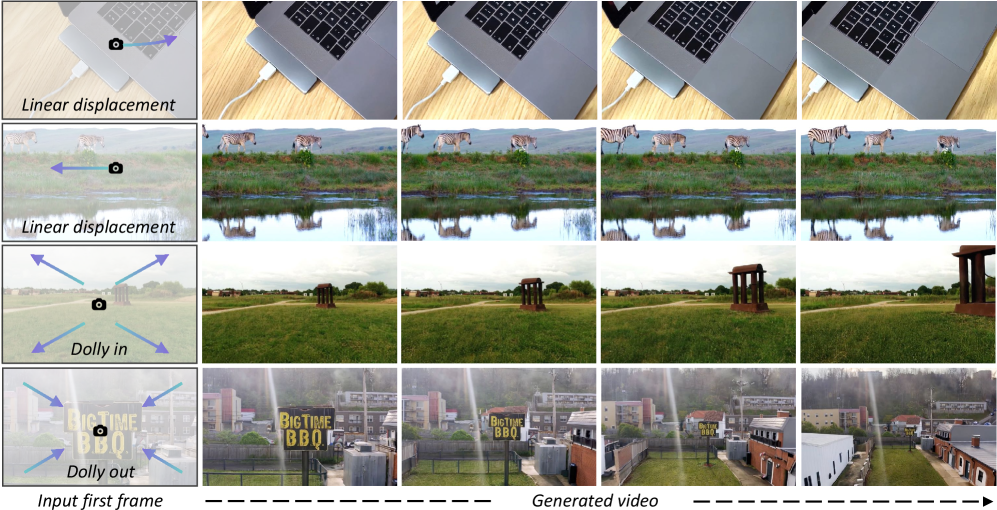

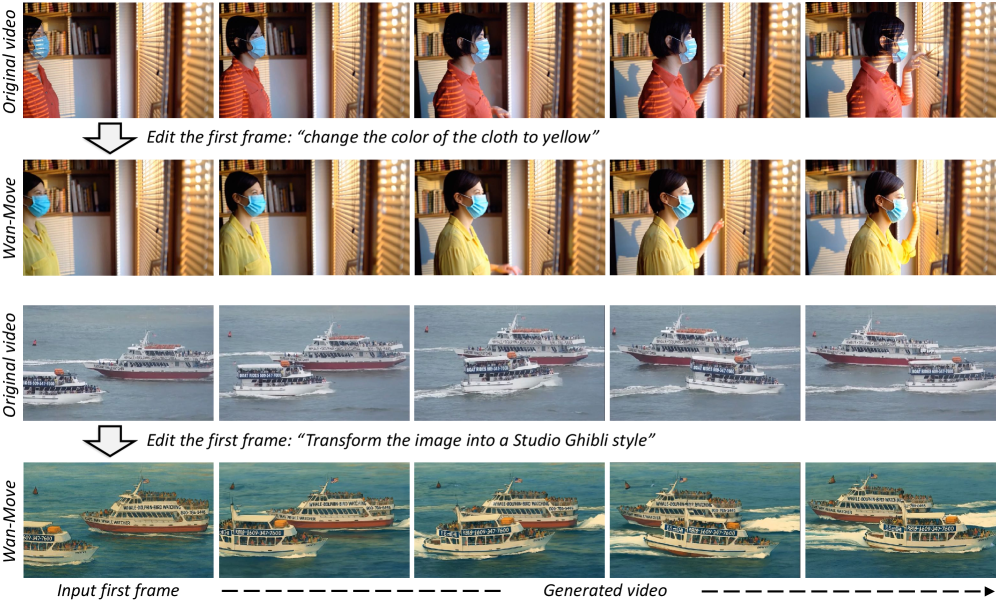

Исследователи представили Wan-Move — систему, позволяющую точно контролировать движения объектов в сгенерированных видеороликах.

Wan-Move использует латентное управление траекторией для редактирования признаков изображения, обеспечивая высококачественную генерацию видео без дополнительных модулей.

Несмотря на значительный прогресс в генерации видео, точное управление движением объектов остается сложной задачей. В данной работе представлена система Wan-Move: Motion-controllable Video Generation via Latent Trajectory Guidance, предлагающая новый подход к управлению движением в генерируемых видеороликах. Ключевая идея заключается в непосредственном редактировании признаков, определяющих изображение, с помощью траекторий движения объектов в скрытом пространстве, что позволяет достичь высокого качества и детализации. Возможно ли дальнейшее масштабирование данной технологии для создания реалистичных и интерактивных видео с беспрецедентным уровнем контроля?

Сложность Динамического Управления Движением

Создание реалистичных и управляемых видеороликов осложняется сложностью точного контроля движения внутри генерируемого контента. Существующие методы часто сталкиваются с проблемой поддержания согласованности и правдоподобия движения объектов, что приводит к неестественным или хаотичным результатам. Неспособность точно направлять динамику приводит к артефактам, заметным даже при визуальном осмотре, и требует значительных вычислительных ресурсов для их устранения. Эта проблема особенно актуальна в задачах, где требуется точное воспроизведение сложных движений или взаимодействие между несколькими объектами, поскольку малейшие отклонения могут значительно ухудшить общее качество и реалистичность генерируемого видеоряда.

Существующие подходы к генерации видео часто сталкиваются с проблемой вычислительной сложности, поскольку для точного управления движением в генерируемом контенте требуются специализированные, и зачастую весьма ресурсоемкие, модули обработки движения. Эти модули, хоть и обеспечивают определенный уровень контроля, существенно ограничивают масштабируемость и эффективность всей системы. Высокая вычислительная нагрузка не только замедляет процесс генерации видео, но и препятствует развертыванию подобных систем на устройствах с ограниченными ресурсами, таких как мобильные телефоны или встроенные системы. Поиск более эффективных и менее затратных методов управления движением является ключевой задачей для развития технологий генерации видео и расширения спектра их применения.

Достижение точного контроля над движением в процессе генерации видео из изображений остается сложной задачей, особенно в отсутствие заранее заданных моделей движения. Существующие подходы часто полагаются на явное определение траекторий и характеристик движения, что ограничивает гибкость и способность системы адаптироваться к новым, непредсказуемым сценариям. Отсутствие таких априорных знаний требует от алгоритмов самостоятельного «понимания» и воспроизведения реалистичной динамики, что представляет собой значительный вызов для современных моделей искусственного интеллекта. Разработка методов, способных генерировать плавные и правдоподобные движения без предварительного обучения на конкретных шаблонах, открывает новые возможности для создания высококачественного видеоконтента и расширяет область применения генеративных моделей.

Wan-Move: Легкий Фреймворк Управления Движением

Wan-Move представляет собой новую систему управления движением, разработанную для расширения возможностей существующих моделей генерации видео из изображений (I2V). В отличие от традиционных подходов, Wan-Move не требует добавления дополнительных модулей обработки движения в архитектуру модели. Это достигается путем непосредственной интеграции управления движением в процесс генерации видео, что позволяет сохранять компактность и эффективность модели, избегая увеличения вычислительных затрат и сложности, связанных с отдельными компонентами обработки движения. Данный подход позволяет использовать существующие I2V модели без значительной модификации их структуры.

Основная инновация Wan-Move заключается в использовании управления траекторией в латентном пространстве. Вместо обработки движения как отдельного этапа, информация о движении передается в латентное пространство генеративной модели посредством траекторий ключевых точек. Это достигается путем кодирования траекторий движения в векторные представления, которые затем используются для управления процессом генерации видео. Таким образом, движение интегрируется непосредственно в процесс декодирования латентного пространства, позволяя более эффективно и точно контролировать динамику генерируемого видео без дополнительных вычислительных затрат, связанных с отдельными модулями обработки движения.

Использование латентного управления траекторией в Wan-Move позволяет существенно снизить вычислительную нагрузку и упростить архитектуру системы генерации видео. Традиционные методы часто требуют дополнительных модулей для обработки движения, что увеличивает сложность и потребление ресурсов. В Wan-Move информация о движении передается непосредственно в латентное пространство генеративной модели, минуя необходимость в этих дополнительных компонентах. Это приводит к более эффективному использованию вычислительных ресурсов и снижению времени генерации видео, сохраняя при этом высокий уровень контроля над динамикой генерируемого контента. Сокращение вычислительной сложности делает Wan-Move применимым для устройств с ограниченными ресурсами и позволяет масштабировать процесс генерации видео для более сложных сцен и продолжительности.

Извлечение и Кодирование Динамики Движения

Траектории точек, отражающие движение объектов, извлекаются из видеокадров с использованием различных методов, таких как CoTracker. Эти методы отслеживают перемещение отдельных точек или групп точек во времени, формируя последовательность координат, описывающих путь объекта. CoTracker, в частности, использует алгоритмы сопоставления признаков и корреляции для определения соответствия между точками в последовательных кадрах, обеспечивая устойчивое отслеживание даже при частичных перекрытиях или изменениях освещения. Полученные траектории служат основой для анализа динамики движения и последующего кодирования в латентное пространство.

Траектории движения объектов, извлеченные из видеопоследовательности, могут быть представлены двумя основными способами. Плотные представления, такие как оптический поток, кодируют смещение каждого пикселя между кадрами, предоставляя детальную информацию о движении, но требуя больших вычислительных ресурсов и объёма памяти. Альтернативой являются разреженные представления, использующие ограничивающие рамки (bounding boxes) или сегментационные маски для обозначения положения и формы движущихся объектов. Разреженные представления требуют меньше вычислительных ресурсов, но могут не учитывать детализированные деформации или изменения формы объекта во времени. Выбор между плотными и разреженными представлениями зависит от конкретной задачи и доступных ресурсов.

Для кодирования и декодирования представлений траекторий движения используется вариационный автоэнкодер (VAE). VAE преобразует данные о траекториях в латентное пространство, представляющее собой пространство меньшей размерности, сохраняющее ключевые характеристики движения. Это позволяет эффективно манипулировать данными о траекториях — например, изменять скорость или направление движения — путем выполнения операций в латентном пространстве, а затем декодировать измененные данные обратно в исходное пространство траекторий. Использование VAE обеспечивает возможность сжатия данных и генерации новых, правдоподобных траекторий на основе изученного распределения в латентном пространстве.

Диффузионные Модели и Улучшенный Контроль

В основе современных систем генерации видео лежат диффузионные модели, и для повышения их управляемости внедряется концепция управления латентной траекторией. Данный подход предполагает интеграцию с архитектурами, такими как DiT (Diffusion Transformers), которые служат основой для генерации видеопоследовательностей. Суть заключается в том, чтобы не просто генерировать видео, а направлять процесс генерации по заранее заданной траектории в латентном пространстве, что позволяет добиться большей согласованности и предсказуемости результатов. Посредством управления латентной траекторией, модель способна создавать видео, более точно соответствующие заданным условиям и требованиям, обеспечивая, таким образом, более высокий уровень контроля над процессом генерации и качеством итогового видеоматериала.

Для обеспечения генерации высококачественного видео используется обучение модели с применением целевых функций, таких как Flow Matching. Этот метод позволяет напрямую оптимизировать процесс диффузии, моделируя непрерывный поток данных от шума к конечному изображению. В отличие от традиционных подходов, где модель обучается предсказывать шум, Flow Matching фокусируется на обучении векторному полю, которое направляет процесс генерации. $F(x,t)$ описывает это поле, определяющее направление движения в латентном пространстве. Такой подход не только ускоряет обучение, но и обеспечивает более стабильную и реалистичную генерацию видео, минимизируя артефакты и обеспечивая плавные переходы между кадрами. Эффективность Flow Matching заключается в его способности моделировать сложные зависимости в данных, что критически важно для создания правдоподобных и детализированных видеопоследовательностей.

Для достижения более точного управления процессом генерации изображений и видео, диффузионные модели все чаще интегрируются с архитектурами, такими как ControlNet. Этот подход позволяет внедрять дополнительную условную информацию, например, карты глубины, эскизы или семантическую сегментацию, непосредственно в процесс диффузии. Вместо того, чтобы модель генерировала изображение исключительно на основе случайного шума, ControlNet направляет генерацию, учитывая предоставленные условия. Это достигается за счет заморозки весов предварительно обученной сети ControlNet и обучения лишь небольшого количества дополнительных параметров, что значительно повышает эффективность и позволяет контролировать различные аспекты генерируемого контента, от общей композиции до детализации конкретных объектов. Такая интеграция открывает новые возможности для творческого контроля и позволяет пользователям создавать изображения и видео, точно соответствующие их замыслам.

Оценка и Будущее Управления Движением

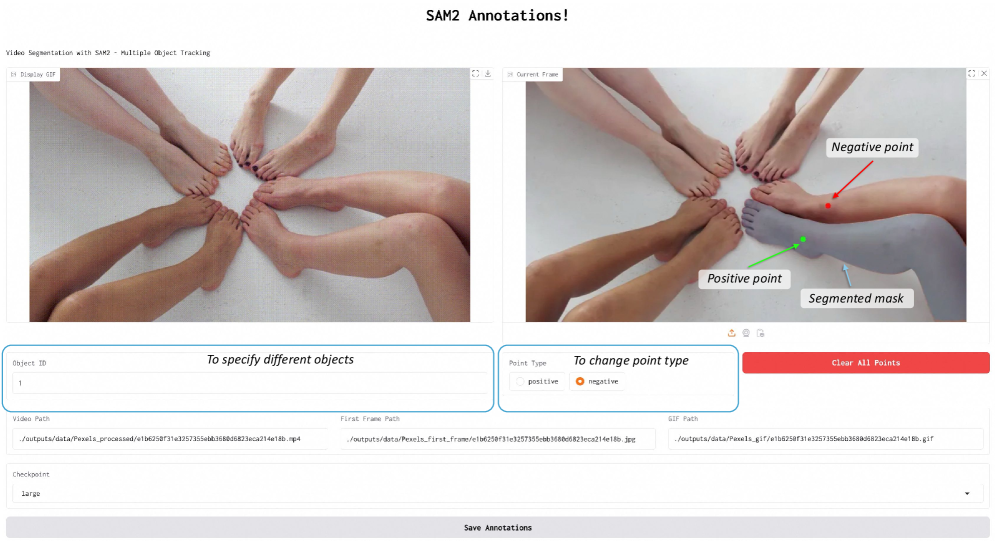

Для всесторонней оценки разработанной системы управления движением использовался MoveBench — свободно распространяемый эталонный набор данных, предоставляющий обширные данные и надежные аннотации. Этот бенчмарк позволяет проводить объективное сравнение с существующими решениями и гарантирует воспроизводимость результатов. MoveBench включает в себя инструменты, такие как SAM и SigLIP, которые обеспечивают генерацию сегментационных масок и кластеризацию видеоконтента, что необходимо для точной оценки качества генерируемого движения. Использование MoveBench позволило не только количественно оценить производительность системы, но и выявить ее сильные и слабые стороны, способствуя дальнейшей оптимизации и развитию.

Для обеспечения точной оценки разработанной системы управления движением, используется платформа MoveBench, активно применяющая инструменты сегментации изображений, такие как SAM (Segment Anything Model), и алгоритмы кластеризации видеоконтента, например SigLIP. SAM позволяет автоматически создавать маски сегментации, выделяя объекты на видео, что критически важно для анализа движения и оценки точности. SigLIP, в свою очередь, эффективно группирует схожие кадры, снижая вычислительную нагрузку и обеспечивая более репрезентативную оценку качества генерируемых видео. Комбинация этих инструментов позволяет MoveBench проводить всесторонний анализ, учитывая как точность отслеживания движения, так и визуальное качество результатов, что необходимо для надежной оценки прогресса в области управления движением.

В рамках всесторонней оценки, разработанная система Wan-Move продемонстрировала передовые результаты, достигнув минимальной ошибки конечной точки (End-Point Error, EPE) в 2.6 единиц на эталонном наборе данных MoveBench. Этот показатель значительно превосходит существующие аналоги и свидетельствует о высокой точности и стабильности системы в задачах управления движением. Низкое значение $EPE$ указывает на способность Wan-Move точно отслеживать и воспроизводить заданные траектории, что критически важно для широкого спектра применений, включая робототехнику, создание анимации и виртуальную реальность. Достигнутая производительность подтверждает эффективность предложенных алгоритмов и открывает новые перспективы для разработки более совершенных систем управления движением.

В ходе сравнительного анализа, разработанная система продемонстрировала значительное превосходство в качестве генерируемого движения. В частности, она достигла 52%-ного показателя побед в соревновании с моделью Kling 1.5 Pro, признанной одним из лидеров в данной области. Более того, полученное значение PSNR (Peak Signal-to-Noise Ratio) составило 17.8 — наивысший показатель, зафиксированный на тестовом наборе MoveBench, что свидетельствует о высокой степени реалистичности и детализации генерируемых видеофрагментов. Данные результаты подтверждают способность системы создавать движения, которые не только точны, но и визуально привлекательны и соответствуют высоким стандартам качества.

В ходе исследований было зафиксировано снижение показателей FVD (Frechet Video Distance) при использовании предложенного подхода, что свидетельствует о значительном улучшении качества генерируемого видео по сравнению с существующими аналогами. Более низкие значения FVD указывают на то, что сгенерированные видеоролики визуально ближе к реальным, демонстрируя более высокую степень реалистичности и детализации. Данный результат подтверждается сравнительным анализом с другими передовыми моделями, что позволяет утверждать о существенном прогрессе в области генерации видео и открывает новые перспективы для применения в таких сферах, как робототехника, анимация и виртуальная реальность. Уменьшение расхождений между сгенерированным и реальным видео способствует более естественному и правдоподобному восприятию контента.

Представленная работа значительно расширяет горизонты создания видео, обеспечивая не только повышенную эффективность и управляемость, но и реалистичность генерируемого контента. Достигнутые результаты открывают новые перспективы в различных областях: от робототехники, где требуется точное моделирование движений и взаимодействие с окружающей средой, до анимации и виртуальной реальности, где реалистичное воспроизведение движений является ключевым фактором погружения и достоверности. Повышенная точность и качество генерируемых видеопотоков позволяет создавать более сложные и правдоподобные симуляции, что, в свою очередь, способствует развитию передовых технологий в этих и смежных областях, включая обучение роботов, создание интерактивных развлечений и разработку инструментов для визуализации данных.

Представленная работа демонстрирует стремление к элегантности в решении сложной задачи генерации видео. Wan-Move избегает излишней сложности, отказываясь от добавления дополнительных модулей и фокусируясь на прямом редактировании признаков изображения в латентном пространстве. Это соответствует убеждению, что истинная эффективность алгоритма определяется не количеством кода, а его масштабируемостью и устойчивостью. Как заметил Дэвид Марр: «Простота — это высшая форма сложности». Этот принцип находит отражение в Wan-Move, где прямое управление траекторией в латентном пространстве обеспечивает точный контроль над движением, минимизируя при этом вычислительные затраты и сложность реализации.

Куда же дальше?

Представленная работа, безусловно, демонстрирует элегантность подхода к управлению движением в генерируемых видео. Однако, стоит признать, что истинная проблема заключается не в самом механизме управления, а в детерминированной воспроизводимости результата. Если траектория в латентном пространстве не приводит к предсказуемому движению в каждом отдельном случае, то ценность подобного контроля сводится к нулю. Должна быть доказана гарантия соответствия между латентной траекторией и физически правдоподобным движением, а не просто достигнута визуальная убедительность на тестовом наборе данных.

Очевидным направлением для дальнейших исследований является формализация понятия “правдоподобного движения”. Недостаточно просто генерировать видео, которое выглядит реалистично; необходимо, чтобы оно соответствовало физическим законам и принципам кинематики. Следует рассмотреть возможность интеграции физических моделей непосредственно в процесс генерации, чтобы обеспечить детерминированность и предсказуемость результатов. Иначе, останется лишь иллюзия контроля, а не реальная возможность управления.

В конечном счете, задача не в создании более сложных алгоритмов, а в поиске математической чистоты и элегантности. Истинное решение должно быть доказуемым, а не просто “работать”. Иначе, мы обречены на бесконечную гонку за улучшением тестовых метрик, забывая о фундаментальных принципах научного подхода.

Оригинал статьи: https://arxiv.org/pdf/2512.08765.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Сердце музыки: открытые модели для создания композиций

- Адаптация моделей к новым данным: квантильная коррекция для нейросетей

- Где «смотрят» большие языковые модели: новый взгляд на визуальное понимание

- Интеллектуальный поиск научных статей: новый подход к исследованию литературы

- Квантовая статистика без границ: новый подход к моделированию

- Голос в переводе: как нейросети учатся понимать речь

- Игры без модели: новый подход к управлению в условиях неопределенности

- Проверка научных статей: новый эталон для автоматического рецензирования

- Цифровые двойники: первый опыт обучения

- Ищем закономерности: Новый пакет TSQCA для R

2025-12-11 03:58